Python 使用CNN进行图像分类的初学者指南

卷积神经网络(CNNs)是一种专门设计用于处理具有网格状拓扑结构的数据的神经网络,例如图像。CNN由一系列卷积和池化层组成,这些层旨在从输入数据中提取特征,并使用全连接层对这些特征进行分类。

CNN的主要优势是它们能够自动学习与任务相关的特征,而无需依赖手动特征工程。这使它们特别适合图像分类任务,因为分类所需的关键特征可能事先未知。

在本文中,我们将提供关于CNN的详细概述,包括它们的架构和背后的关键概念。然后,我们将演示如何使用流行的Keras库在Python中实现CNN进行图像分类。

CNN架构

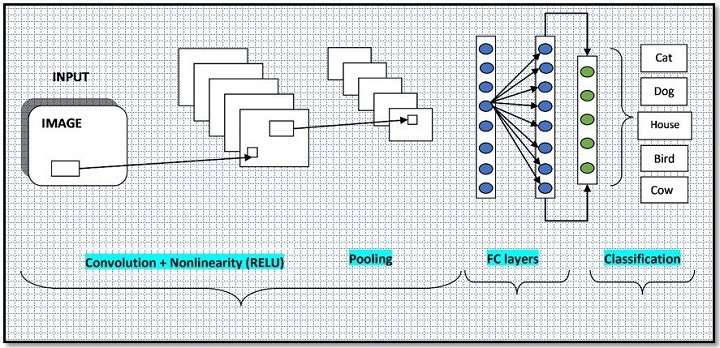

CNN由许多不同的层组成,每个层执行特定的功能。CNN中最常见的层类型包括卷积层、池化层和全连接层。

卷积层

卷积层是CNN的主要构建模块。它们对输入数据应用卷积操作,即通过在输入数据上滑动一个小矩阵(称为核或滤波器)并计算核与输入数据中条目之间的点积。结果是一个新的转换特征图,它捕捉输入数据中条目之间的关系。

卷积层的参数包括核的大小、步幅(即核每次移动的像素数)和填充(即添加到输入数据边界的像素数,以确保核可以应用于输入数据的所有部分)。

池化层

池化层用于通过对卷积层产生的特征图应用池化操作来对输入数据进行下采样。最常见的池化类型是最大池化和平均池化,分别取一组输入的最大值和平均值。

池化层通常用于减小输入数据的空间维度(即宽度和高度),从而减少模型中的参数数量并提高其泛化性能。

全连接层

全连接层用于对卷积和池化层提取的特征进行分类。它们由多个神经元组成,每个神经元与上一层的每个神经元相连。全连接层的输出是一组类别分数,可以用于预测输入数据的类别标签。

卷积神经网络(CNN)的典型架构如下图所示−

使用CNN进行图像分类

为了有效地使用CNN进行图像分类,有一些重要概念需要理解。

滤波器和核

如上所述,卷积层将一个核或过滤器应用于输入数据,以产生一个转换后的特征映射。核的大小决定了在卷积操作的每一步中所考虑的输入数据区域的大小。例如,一个3×3的核在每一步中考虑输入数据的一个3×3的区域。 核的权重在训练过程中进行学习,并用于从输入数据中提取特征。不同的核可以用于提取不同类型的特征,如边缘、角落或纹理。 步幅决定了将核应用于输入数据时的步长。更大的步幅会导致较小的输出特征映射,因为核仅应用于输入数据的少数位置。另一方面,较小的步幅会导致较大的输出特征映射,因为核被应用于输入数据的更多位置。 填充是卷积操作应用之前在输入数据边界上添加的像素数量。填充通常用于确保输出特征映射具有与输入数据相同的空间维度,这对于某些类型的下游处理非常有用。 池化是应用于卷积层输出的下采样操作。它减少了数据的空间维度,并且通常用于减少模型中的参数数量并提高其泛化性能。 现在我们对CNN有了基本的了解,让我们看一下如何使用流行的Keras库在Python中实现图像分类的CNN。 我们需要做的第一件事是安装所需的库。我们将使用以下库: - NumPy:用于处理数组和矩阵的库 - Matplotlib:用于创建图表和图形的库 - Keras:用于构建和训练神经网络的高级库 您可以使用pip命令安装这些库。

pip install numpy matplotlib keras

接下来,我们需要导入我们将使用的库−

import numpy as np

import matplotlib.pyplot as plt

from tensorflow import keras

from tensorflow.keras.datasets import mnist

from tensorflow.keras.utils import to_categorical

from tensorflow.keras.models import Sequential

from tensorflow.keras.layers import Conv2D, MaxPooling2D, Flatten, Dense, Dropout

我们将在这个例子中使用MNIST数据集,它由6万张训练图像和1万张手写数字的测试图像组成。这些图像的尺寸为28×28像素,每个像素的灰度值介于0和255之间。任务的目标是将这些图像分类为10个类别之一(即0-9的数字)。

我们首先需要做的是加载数据集并对数据进行预处理。我们可以使用以下代码来实现这一步骤 −

# Load the dataset

(X_train, y_train), (X_test, y_test) = mnist.load_data()

# Pre-process the data

X_train = X_train.astype(np.float32) / 255.0

X_test = X_test.astype(np.float32) / 255.0

# Reshape the data to add a channel dimension

X_train = np.expand_dims(X_train, axis=-1)

X_test = np.expand_dims(X_test, axis=-1)

# One-hot encode the labels

y_train = to_categorical(y_train, num_classes=10)

y_test = to_categorical(y_test, num_classes=10)

接下来,我们需要定义模型。我们将使用Sequential模型,它允许我们将模型定义为一系列层。我们将首先添加一个具有32个3×3大小的滤波器的卷积层,然后是一个具有2×2池大小的最大池化层。然后,我们将添加一个具有0.25比率的dropout层,在训练过程中随机删除25%的单元,以防止过拟合。

然后,我们将添加第二个具有64个3×3大小的滤波器的卷积层,然后是另一个具有2×2池大小的最大池化层。我们再次添加一个具有0.25比率的dropout层。

最后,我们将扁平化第二个池化层的输出,并添加一个具有128个单元的全连接层,然后是具有10个单元的输出层(每个类别一个)。

我们可以使用以下代码来定义模型−

# Define the model

model = Sequential()

model.add(Conv2D(32, kernel_size=(3, 3), activation='relu', input_shape=(28, 28, 1)))

model.add(MaxPooling2D(pool_size=(2, 2)))

model.add(Dropout(0.25))

model.add(Conv2D(64, kernel_size=(3, 3), activation='relu'))

model.add(MaxPooling2D(pool_size=(2, 2)))

model.add(Dropout(0.25))

model.add(Flatten())

model.add(Dense(128, activation='relu'))

model.add(Dense(10, activation='softmax'))

接下来,我们需要通过指定损失函数、优化器和我们想要使用的指标来编译模型。对于这个例子,我们将使用分类交叉熵损失函数、Adam优化器和准确率指标。

# Compile the model

model.compile(loss='categorical_crossentropy', optimizer='adam', metrics=['accuracy'])

最后,我们可以通过调用fit方法来训练模型,并指定训练数据、迭代次数(即模型将看到数据的次数)和批处理大小(即每次梯度更新的样本数量)。

# Train the model

history = model.fit(X_train, y_train, epochs=10, batch_size=32, validation_data=(X_test, y_test))

运行上述代码片段后的输出如下:

Epoch 1/10

1875/1875 [==============================] - 38s 20ms/step - loss: 0.1680 - accuracy: 0.9481 - val_loss: 0.0556 - val_accuracy: 0.9823

Epoch 2/10

1875/1875 [==============================] - 42s 22ms/step - loss: 0.0608 - accuracy: 0.9811 - val_loss: 0.0374 - val_accuracy: 0.9880

Epoch 3/10

1875/1875 [==============================] - 42s 22ms/step - loss: 0.0470 - accuracy: 0.9854 - val_loss: 0.0292 - val_accuracy: 0.9903

Epoch 4/10

1875/1875 [==============================] - 44s 24ms/step - loss: 0.0370 - accuracy: 0.9889 - val_loss: 0.0260 - val_accuracy: 0.9908

Epoch 5/10

1875/1875 [==============================] - 43s 23ms/step - loss: 0.0311 - accuracy: 0.9903 - val_loss: 0.0246 - val_accuracy: 0.9913

Epoch 6/10

1875/1875 [==============================] - 43s 23ms/step - loss: 0.0267 - accuracy: 0.9911 - val_loss: 0.0278 - val_accuracy: 0.9910

Epoch 7/10

1875/1875 [==============================] - 40s 21ms/step - loss: 0.0233 - accuracy: 0.9923 - val_loss: 0.0261 - val_accuracy: 0.9926

Epoch 8/10

1875/1875 [==============================] - 41s 22ms/step - loss: 0.0193 - accuracy: 0.9939 - val_loss: 0.0268 - val_accuracy: 0.9917

Epoch 9/10

1875/1875 [==============================] - 41s 22ms/step - loss: 0.0188 - accuracy: 0.9941 - val_loss: 0.0252 - val_accuracy: 0.9916

Epoch 10/10

1875/1875 [==============================] - 41s 22ms/step - loss: 0.0169 - accuracy: 0.9945 - val_loss: 0.0314 - val_accuracy: 0.9909

训练完成后,我们可以通过调用evaluate方法来评估模型在测试数据上的表现。

# Evaluate the model

loss, accuracy = model.evaluate(X_test, y_test)

print("Loss: ", loss)

print("Accuracy: ", accuracy)

以下是运行上述代码片段后的输出结果 –

313/313 [==============================] - 1s 5ms/step - loss: 0.0314 - accuracy: 0.9909

Loss: 0.031392790377140045

Accuracy: 0.9908999800682068

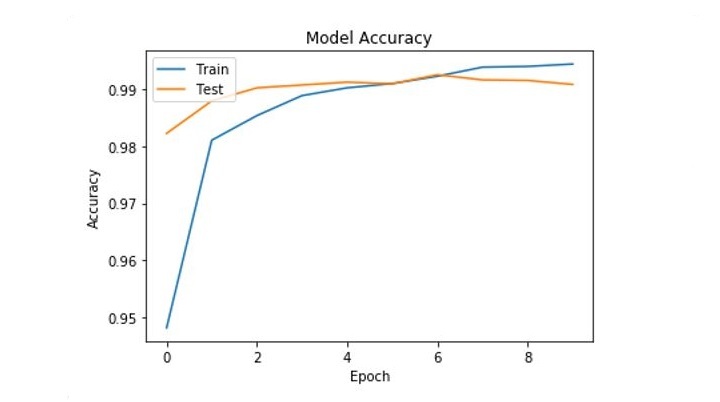

我们还可以通过从history对象中提取准确性历史数据来绘制训练和验证准确性的训练过程。

# Extract the accuracy history

acc = history.history['accuracy']

val_acc = history.history['val_accuracy']

# Plot the accuracy history

plt.plot(acc)

plt.plot(val_acc)

plt.title('Model Accuracy')

plt.ylabel('Accuracy')

plt.xlabel('Epoch')

plt.legend(['Train', 'Test'], loc='upper left')

plt.show()

将训练和验证准确率绘制如下 −

提高性能

为了进一步提高CNN的性能,您可以考虑以下几点−

- 优化架构 − 设计CNN的方式有很多种,对于您的任务来说,最佳架构将取决于您数据的特定特征。您可以尝试不同数量的层级、内核大小、步长等等,以找到最适合您的任务的设置。

-

使用数据增广 − 数据增广是一种通过对现有数据应用变换来生成额外训练数据的技术。当您只有有限的训练数据时,这对于改善泛化性能非常有用。

-

使用预训练模型 − 预训练模型是在像ImageNet这样的大型数据集上训练过的CNN,可以作为您自己任务的起点。迁移学习是一种强大的技术,可以在您自己的数据集上微调预训练模型,从而大大加快训练速度并提高性能。

-

优化超参数 − 您还可以通过优化超参数(如学习率、批量大小等)来改善CNN的性能。您可以使用网格搜索或随机搜索等技术,找到适合您任务的最优超参数组合。

通过遵循这些提示并将其应用于您自己的CNN,您应该能够在各种图像分类任务上取得良好的性能。

结论

在本文中,我们详细介绍了卷积神经网络(CNN)的概述,并展示了如何使用Keras库在Python中实现图像分类的CNN。我们讨论了CNN背后的关键概念,包括过滤器和卷积核、步幅、填充和池化,并解释了这些概念如何用于从输入数据中提取特征并对其进行分类。

我们还展示了如何微调CNN的架构和超参数,使用数据增广来改善泛化性能,以及使用预训练模型加快训练速度并提高性能。

通过遵循本文中概述的技巧,您应该能够在各种图像分类任务上取得良好的性能。总的来说,CNN是分析和分类图像数据的强大工具,正确的方法可以用于解决计算机视觉和机器学习中的各种问题。

极客笔记

极客笔记