Spark cogroup函数

在Spark中,cogroup函数用于不同的数据集,比如,(K, V)和(K, W),并返回一个(K, (Iterable

cogroup函数示例

在这个示例中,我们执行 groupWith 操作。

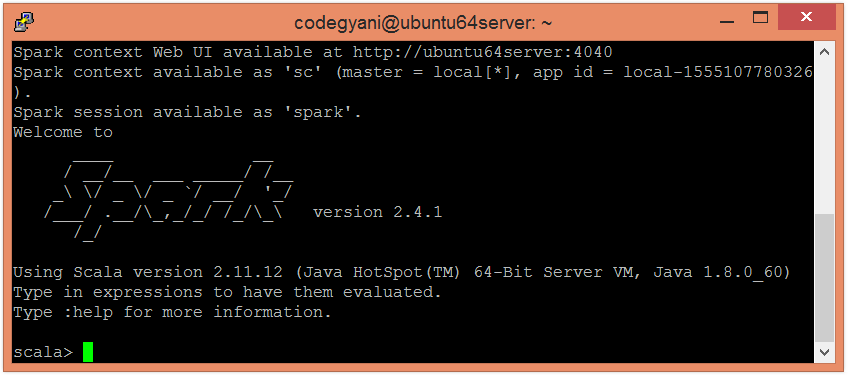

- 要以Scala模式打开Spark,请执行以下命令。

$ spark-shell

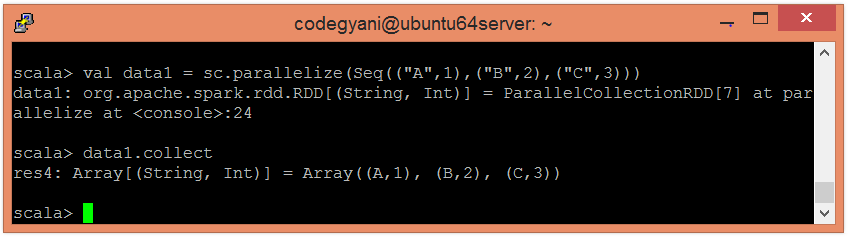

- 使用并行化集合创建RDD。

scala> val data1 = sc.parallelize(Seq(("A",1),("B",2),("C",3)))

现在,我们可以使用以下命令来阅读生成的结果。

scala> data1.collect

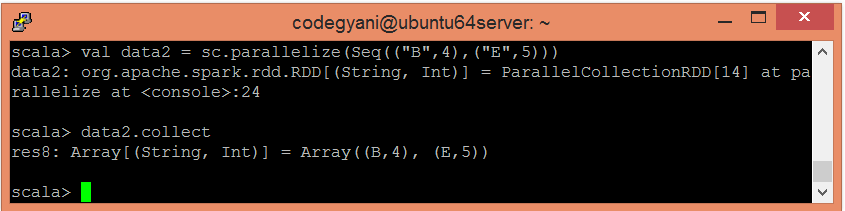

- 使用并行集合创建另一个RDD。

scala> val data2 = sc.parallelize(Seq(("B",4),("E",5)))

现在,我们可以使用以下命令阅读生成的结果。

scala> data2.collect

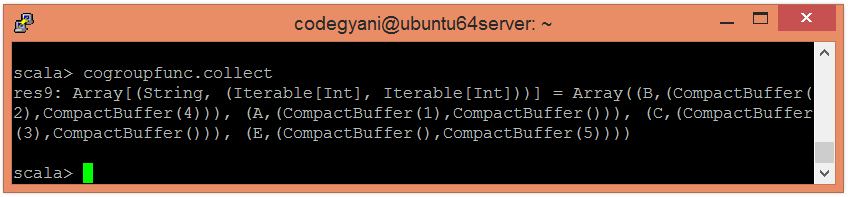

- 将

cogroup()函数应用于值进行分组。

scala> val cogroupfunc = data1.cogroup(data2)

- 现在,我们可以使用以下命令来阅读生成的结果。

scala> cogroupfunc.collect

这里,我们获得了所需的输出。

极客笔记

极客笔记