Spark Cartesian函数

在Spark中,Cartesian函数生成两个数据集的笛卡尔积,并返回所有可能的配对组合。这里,一个数据集的每个元素与另一个数据集的每个元素配对。

Cartesian函数的示例

在这个示例中,我们生成了两个数据集的笛卡尔积。

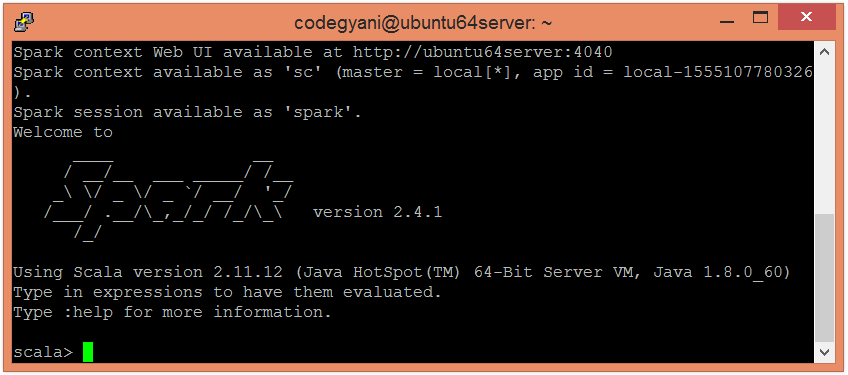

- 要打开Scala模式的Spark,请按照以下命令操作。

$ spark-shell

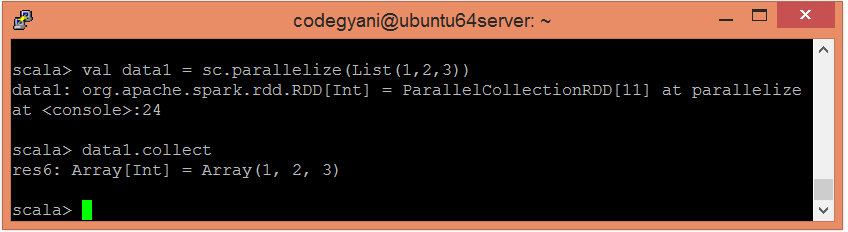

- 使用并行化的集合创建一个RDD。

scala> val data1 = sc.parallelize(List(1,2,3))

- 现在,我们可以使用以下命令来读取生成的结果。

scala> data1.collect

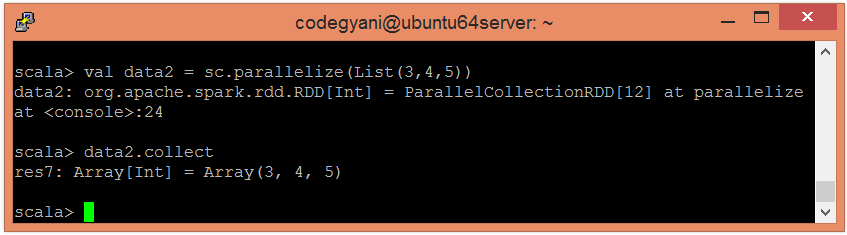

- 使用并行集合创建另一个RDD。

scala> val data2 = sc.parallelize(List(3,4,5))

- 现在,我们可以使用以下命令来读取生成的结果。

scala> data2.collect

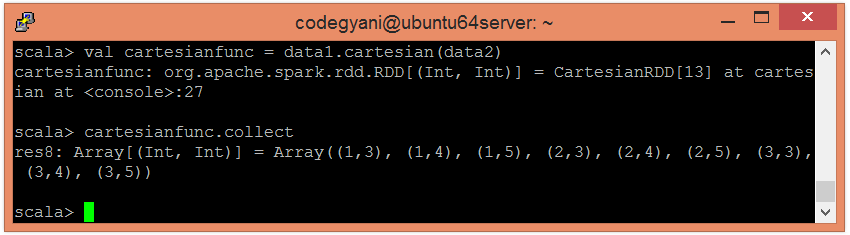

- 应用cartesian()函数返回元素的笛卡尔积。

scala> val cartesianfunc = data1.cartesian(data2)

- 现在,我们可以使用以下命令读取生成的结果。

scala> cartesianfunc.collect

在这里,我们得到了期望的输出。

极客笔记

极客笔记