Spark 安装

在这部分中,我们将进行Spark的安装。所以,请按以下步骤进行。

- 下载Apache Spark的tar文件。 点击这里

- 解压下载的tar文件。

sudo tar -xzvf /home/codegyani/spark-2.4.1-bin-hadoop2.7.tgz

- 打开bashrc文件。

sudo nano ~/.bashrc

- 现在,在最后复制以下Spark路径。

SPARK_HOME=/ home/codegyani /spark-2.4.1-bin-hadoop2.7

export PATH=SPARK_HOME/bin:PATH

- 更新环境变量

source ~/.bashrc

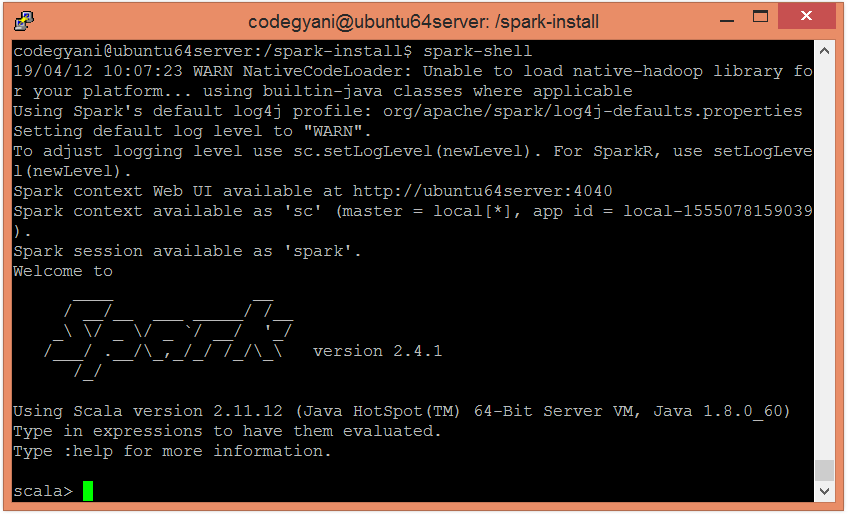

- 让我们在命令提示符上测试安装类型

spark-shell

提示 – 在此处,Spark已在Scala模式下启用。

极客笔记

极客笔记