Spark groupByKey函数

在Spark中,groupByKey函数是一种经常使用的转换操作,用于对数据进行洗牌。它接收键值对(K, V)作为输入,根据键对值进行分组,并生成一个(K, Iterable)对的数据集作为输出。

groupByKey函数的示例

在此示例中,我们根据键对值进行分组。

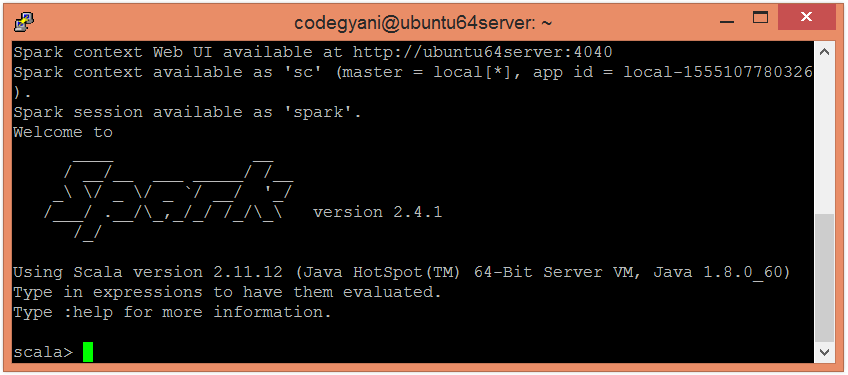

- 要在Scala模式下打开Spark,请按照以下命令进行操作。

$ spark-shell

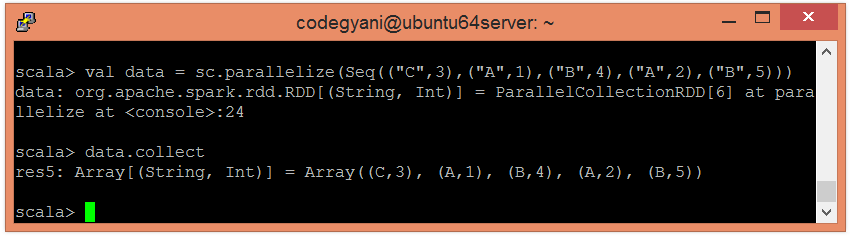

- 使用并行化集合创建一个RDD。

scala> val data = sc.parallelize(Seq(("C",3),("A",1),("B",4),("A",2),("B",5)))

现在,我们可以通过以下命令来阅读生成的结果。

scala> data.collect

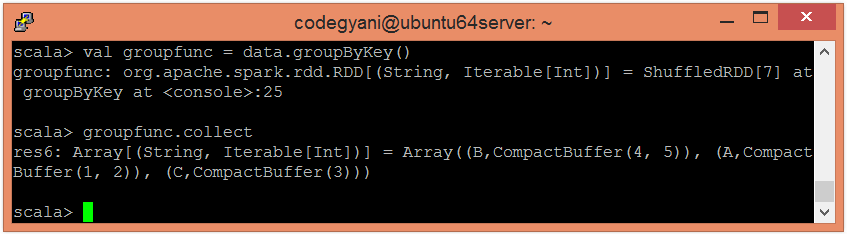

- 应用groupByKey()函数来对值进行分组。

scala> val groupfunc = data.groupByKey()

- 现在,我们可以使用以下命令来读取生成的结果。

scala> groupfunc.collect

在这里,我们得到了所需的输出。

极客笔记

极客笔记