Spark reduceByKey函数

在Spark中,reduceByKey函数是一个经常使用的转换操作,用于对数据进行聚合。它接收键值对(K, V)作为输入,根据键对值进行聚合,并生成一个输出为(K, V)对的数据集。

reduceByKey函数示例

在这个示例中,我们根据键对值进行聚合。

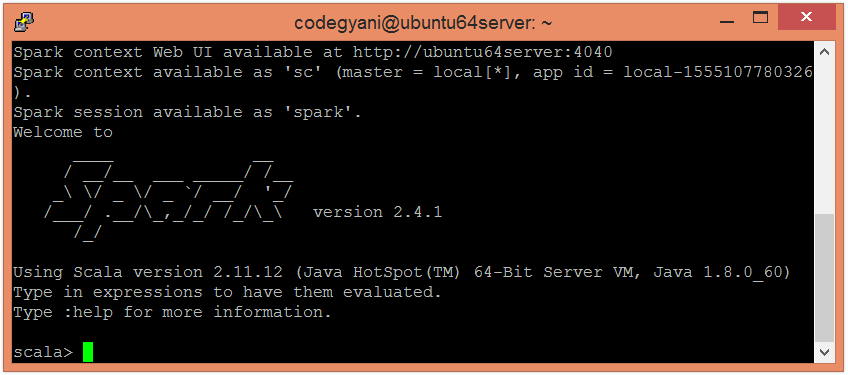

- 要以Scala模式打开Spark,请按照以下命令进行操作。

$ spark-shell

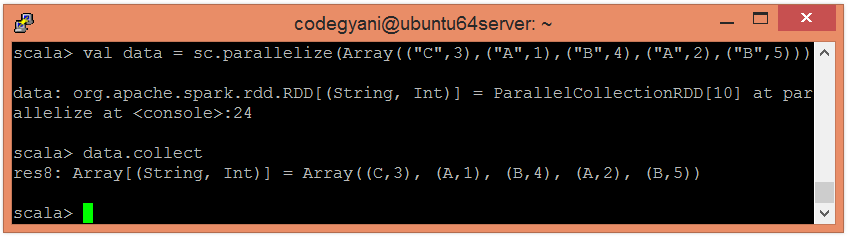

- 使用并行化集合创建RDD。

scala> val data = sc.parallelize(Array(("C",3),("A",1),("B",4),("A",2),("B",5)))

现在,我们可以使用以下命令读取生成的结果。

scala> data.collect

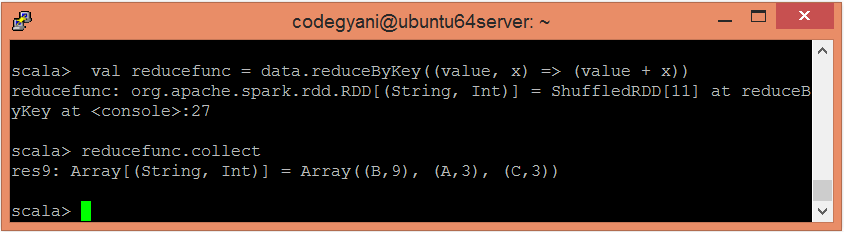

- 将reduceByKey()函数应用于聚合值。

scala> val reducefunc = data.reduceByKey((value, x) => (value + x))

- 现在,我们可以使用以下命令来阅读生成的结果。

scala> reducefunc.collect

这里,我们得到了期望的输出。

极客笔记

极客笔记