机器学习 集成分类器

集成分类器是将多个模型的预测能力结合起来生成比单个模型更强大的模型的分类模型。通过学习一组分类器,并使用投票机制选择最终的模型。

数据挖掘是探索和分析大型数据集以发现和探索重要的模式、关系和信息的过程。提取的信息可以用于解决企业问题、预测趋势和制定组织的战略计划。集成分类器用于在数据挖掘中执行这些任务。

为什么我们需要集成分类器

集成模型(分类器)可以解决许多问题,并具有其他单一方法不具备的几个优点。它们是:

- 提高预测准确性

-

即使基础模型无法准确分类,最终模型的准确性仍较高

-

能够并行化并实现资源的高效管理

-

可以改进先前模型产生的错误并生成高效的模型

数据挖掘中的集成分类器类型

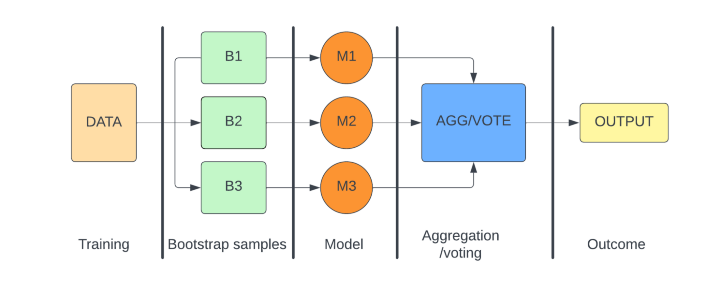

Bagging

Bagging方法也被称为自助聚合。在Bagging方法中,从原始数据集中取出一个自助样本,并对其进行类似于决策树的分类器的训练。对于其他子样本,也会进行有放回的自助采样。每个子样本使用决策树分类器进行训练后,使用算法对结果进行聚合并生成最终模型。这通常使用多数投票机制来实现。也可以进行平均操作以生成通常优于单个模型的最终结果。

Bagging有助于减少模型的方差,并且可以与并行操作一起使用。

Bagging分类器的例子包括随机森林分类器和极端随机树分类器。

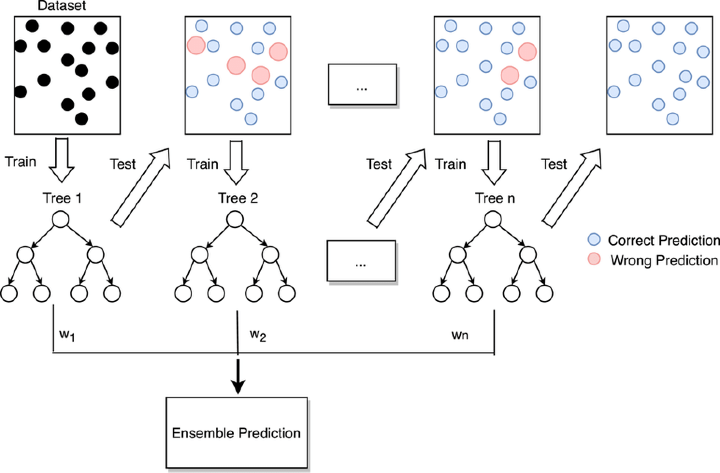

Boosting

Boosting方法利用弱学习器和强学习器。最终模型是基于多个弱学习器构建的。弱学习器产生的准确性略高于随机预测,但不能产生准确结果,容易产生错误,预测能力较低。由于提升方法是按顺序使用弱学习器进行训练,一个特定的学习器试图减少由前一个弱学习器产生的错误并提高准确性。当使用多个这样的学习器时,它们按顺序协同工作,最终得到相对较好的结果,形成最终模型。

Boosting有助于减少模型的偏差,但不能与并行操作一起使用。

提升方法的例子包括AdaBoost、CatBoost和GBDT分类器。

在上图中,我们使用训练数据集和测试数据集。最初我们在该数据上训练弱学习器w1(决策树Tree1)。在下一步中,我们考虑第一个模型产生的错误,并尝试通过第二个弱学习器w2改进先前模型产生的测试错误。弱学习器w2是经过训练的决策树Tree2。这个过程一直持续到第n步,直到达到最佳准确性或最大步骤n。

集成分类器的局限性

- 集合分类器的可解释性较低,很难解释。

-

它需要选择正确的基础模型,因为这可能导致低于每个基础模型的预测准确度。

-

它有些昂贵,并且在训练过程中可能消耗大量的时间和资源。

结论

由于利用多个模型的预测能力并产生更准确的结果,集合分类方法由于使用多个模型而变得非常流行。它们在许多行业的数据挖掘和其他相关应用中非常有用,然而在某些业务中,集合分类器的使用受到限制,其中可解释性是关键因素。

极客笔记

极客笔记