Pandas中使用groupby合并两列数据的高效方法

参考:pandas groupby combine two columns

Pandas是Python中强大的数据处理库,它提供了丰富的功能来处理结构化数据。在数据分析过程中,我们经常需要对数据进行分组和聚合操作。本文将详细介绍如何使用Pandas的groupby功能来合并两列数据,并通过实际示例展示这一技术的应用。

1. Pandas groupby的基本概念

在深入探讨如何合并两列数据之前,我们首先需要了解Pandas中groupby的基本概念。groupby是Pandas中用于数据分组的重要功能,它允许我们按照一个或多个列的值将数据分成不同的组,然后对每个组应用聚合函数。

1.1 groupby的基本用法

让我们从一个简单的例子开始:

import pandas as pd

# 创建示例数据

data = {

'name': ['Alice', 'Bob', 'Charlie', 'Alice', 'Bob'],

'city': ['New York', 'London', 'Paris', 'New York', 'London'],

'sales': [100, 200, 300, 400, 500]

}

df = pd.DataFrame(data)

# 使用groupby按name分组并计算sales的总和

result = df.groupby('name')['sales'].sum()

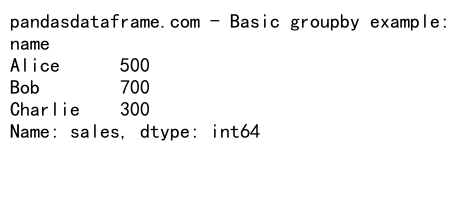

print("pandasdataframe.com - Basic groupby example:")

print(result)

Output:

在这个例子中,我们首先创建了一个包含名字、城市和销售额的DataFrame。然后,我们使用groupby按照’name’列进行分组,并计算每个人的总销售额。这个简单的操作展示了groupby的基本用法。

1.2 groupby的多列分组

groupby不仅可以按单列分组,还可以同时按多列分组:

import pandas as pd

# 创建示例数据

data = {

'name': ['Alice', 'Bob', 'Charlie', 'Alice', 'Bob'],

'city': ['New York', 'London', 'Paris', 'New York', 'London'],

'category': ['A', 'B', 'A', 'B', 'A'],

'sales': [100, 200, 300, 400, 500]

}

df = pd.DataFrame(data)

# 使用groupby按name和city分组并计算sales的总和

result = df.groupby(['name', 'city'])['sales'].sum()

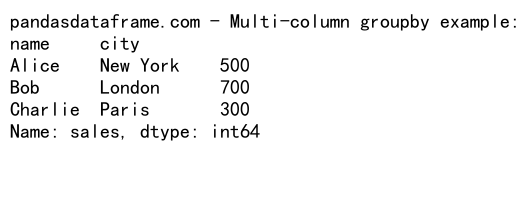

print("pandasdataframe.com - Multi-column groupby example:")

print(result)

Output:

在这个例子中,我们按照’name’和’city’两列进行分组,这样可以得到每个人在每个城市的销售总额。

2. 合并两列数据的方法

现在我们已经了解了groupby的基本用法,接下来让我们探讨如何使用groupby来合并两列数据。

2.1 使用agg函数合并列

agg函数是一个强大的工具,它允许我们对分组后的数据应用多个聚合函数:

import pandas as pd

# 创建示例数据

data = {

'name': ['Alice', 'Bob', 'Charlie', 'Alice', 'Bob'],

'city': ['New York', 'London', 'Paris', 'New York', 'London'],

'sales': [100, 200, 300, 400, 500],

'profit': [10, 20, 30, 40, 50]

}

df = pd.DataFrame(data)

# 使用groupby和agg合并sales和profit列

result = df.groupby('name').agg({

'sales': 'sum',

'profit': 'sum'

})

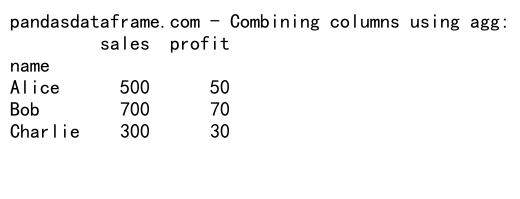

print("pandasdataframe.com - Combining columns using agg:")

print(result)

Output:

在这个例子中,我们使用agg函数同时对’sales’和’profit’列进行求和操作。这样,我们就得到了每个人的总销售额和总利润。

2.2 使用lambda函数自定义合并操作

有时,我们可能需要进行更复杂的合并操作。这时,我们可以使用lambda函数来自定义合并逻辑:

import pandas as pd

# 创建示例数据

data = {

'name': ['Alice', 'Bob', 'Charlie', 'Alice', 'Bob'],

'city': ['New York', 'London', 'Paris', 'New York', 'London'],

'sales': [100, 200, 300, 400, 500],

'profit': [10, 20, 30, 40, 50]

}

df = pd.DataFrame(data)

# 使用groupby和lambda函数合并sales和profit列

result = df.groupby('name').agg({

'sales': 'sum',

'profit': 'sum',

'combined': lambda x: (x['sales'] * x['profit']).sum()

})

print("pandasdataframe.com - Combining columns using lambda function:")

print(result)

在这个例子中,我们不仅计算了总销售额和总利润,还创建了一个新的’combined’列,它是sales和profit的乘积之和。这展示了如何使用lambda函数进行更复杂的列合并操作。

3. 高级groupby技巧

除了基本的groupby操作,Pandas还提供了一些高级技巧,可以帮助我们更灵活地处理数据。

3.1 使用transform函数

transform函数允许我们在保持原始DataFrame结构的同时,对分组后的数据进行操作:

import pandas as pd

# 创建示例数据

data = {

'name': ['Alice', 'Bob', 'Charlie', 'Alice', 'Bob'],

'city': ['New York', 'London', 'Paris', 'New York', 'London'],

'sales': [100, 200, 300, 400, 500]

}

df = pd.DataFrame(data)

# 使用transform计算每个人的平均销售额

df['avg_sales'] = df.groupby('name')['sales'].transform('mean')

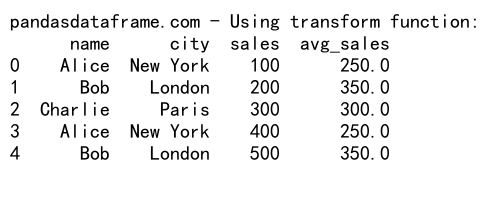

print("pandasdataframe.com - Using transform function:")

print(df)

Output:

在这个例子中,我们使用transform函数计算了每个人的平均销售额,并将结果添加到原始DataFrame中作为一个新列。

3.2 使用apply函数

apply函数允许我们对分组后的数据应用自定义函数:

import pandas as pd

# 创建示例数据

data = {

'name': ['Alice', 'Bob', 'Charlie', 'Alice', 'Bob'],

'city': ['New York', 'London', 'Paris', 'New York', 'London'],

'sales': [100, 200, 300, 400, 500],

'profit': [10, 20, 30, 40, 50]

}

df = pd.DataFrame(data)

# 定义自定义函数

def custom_agg(group):

return pd.Series({

'total_sales': group['sales'].sum(),

'total_profit': group['profit'].sum(),

'profit_ratio': group['profit'].sum() / group['sales'].sum()

})

# 使用apply应用自定义函数

result = df.groupby('name').apply(custom_agg)

print("pandasdataframe.com - Using apply function:")

print(result)

在这个例子中,我们定义了一个自定义函数来计算总销售额、总利润和利润率,然后使用apply函数将这个自定义函数应用到每个分组。

4. 处理缺失值

在实际数据处理中,我们经常会遇到缺失值的情况。Pandas提供了多种方法来处理groupby操作中的缺失值。

4.1 使用fillna处理缺失值

import pandas as pd

import numpy as np

# 创建包含缺失值的示例数据

data = {

'name': ['Alice', 'Bob', 'Charlie', 'Alice', 'Bob'],

'city': ['New York', 'London', 'Paris', 'New York', 'London'],

'sales': [100, np.nan, 300, 400, 500],

'profit': [10, 20, np.nan, 40, 50]

}

df = pd.DataFrame(data)

# 使用fillna处理缺失值

result = df.groupby('name').agg({

'sales': lambda x: x.fillna(0).sum(),

'profit': lambda x: x.fillna(0).sum()

})

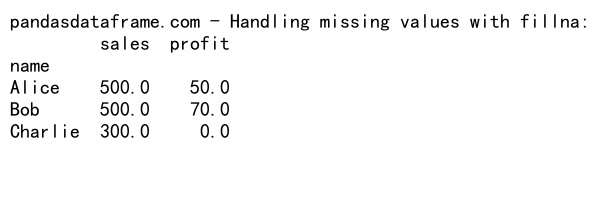

print("pandasdataframe.com - Handling missing values with fillna:")

print(result)

Output:

在这个例子中,我们使用fillna方法将缺失值替换为0,然后进行求和操作。这样可以避免因缺失值而导致的计算错误。

4.2 使用dropna删除包含缺失值的行

有时,我们可能希望在进行groupby操作之前删除包含缺失值的行:

import pandas as pd

import numpy as np

# 创建包含缺失值的示例数据

data = {

'name': ['Alice', 'Bob', 'Charlie', 'Alice', 'Bob'],

'city': ['New York', 'London', 'Paris', 'New York', 'London'],

'sales': [100, np.nan, 300, 400, 500],

'profit': [10, 20, np.nan, 40, 50]

}

df = pd.DataFrame(data)

# 使用dropna删除包含缺失值的行,然后进行groupby操作

result = df.dropna().groupby('name').agg({

'sales': 'sum',

'profit': 'sum'

})

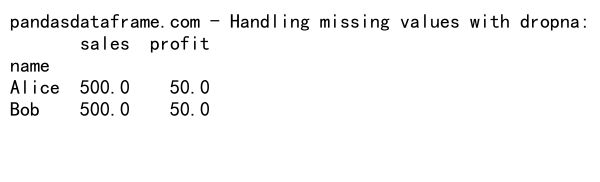

print("pandasdataframe.com - Handling missing values with dropna:")

print(result)

Output:

在这个例子中,我们首先使用dropna方法删除包含缺失值的行,然后再进行groupby操作。这种方法适用于我们不希望缺失值影响结果的情况。

5. 处理大型数据集

当处理大型数据集时,内存使用和计算效率变得尤为重要。Pandas提供了一些技巧来优化大型数据集的groupby操作。

5.1 使用分块处理

对于非常大的数据集,我们可以使用分块处理的方法:

import pandas as pd

# 假设我们有一个大型CSV文件

chunk_size = 1000000 # 每次读取的行数

result = pd.DataFrame()

# 分块读取并处理数据

for chunk in pd.read_csv('pandasdataframe.com_large_dataset.csv', chunksize=chunk_size):

chunk_result = chunk.groupby('name').agg({

'sales': 'sum',

'profit': 'sum'

})

result = result.add(chunk_result, fill_value=0)

print("pandasdataframe.com - Processing large datasets in chunks:")

print(result)

在这个例子中,我们假设有一个大型CSV文件。我们使用pd.read_csv的chunksize参数来分块读取数据,然后对每个块进行groupby操作,最后将结果合并。这种方法可以有效减少内存使用。

5.2 使用categoricals优化内存使用

对于包含重复值的列,我们可以将其转换为categorical类型来优化内存使用:

import pandas as pd

# 创建示例数据

data = {

'name': ['Alice', 'Bob', 'Charlie'] * 1000000,

'city': ['New York', 'London', 'Paris'] * 1000000,

'sales': range(3000000),

'profit': range(0, 30000000, 10)

}

df = pd.DataFrame(data)

# 将name和city列转换为categorical类型

df['name'] = df['name'].astype('category')

df['city'] = df['city'].astype('category')

# 进行groupby操作

result = df.groupby(['name', 'city']).agg({

'sales': 'sum',

'profit': 'sum'

})

print("pandasdataframe.com - Optimizing memory usage with categoricals:")

print(result)

在这个例子中,我们将’name’和’city’列转换为categorical类型。对于包含大量重复值的列,这种方法可以显著减少内存使用。

6. 高级数据分析技巧

除了基本的groupby和合并操作,Pandas还提供了一些高级技巧,可以帮助我们进行更复杂的数据分析。

6.1 使用rolling window计算

rolling window计算允许我们在分组数据上执行滑动窗口操作:

import pandas as pd

# 创建示例数据

data = {

'date': pd.date_range(start='2023-01-01', periods=10),

'sales': [100, 150, 200, 180, 220, 250, 300, 280, 320, 350]

}

df = pd.DataFrame(data)

# 计算3天滑动平均销售额

df['rolling_avg'] = df.groupby(df['date'].dt.month)['sales'].rolling(window=3).mean().reset_index(level=0, drop=True)

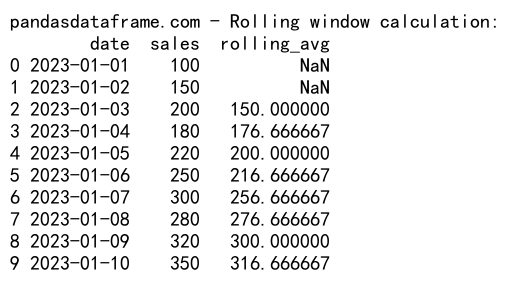

print("pandasdataframe.com - Rolling window calculation:")

print(df)

Output:

在这个例子中,我们首先按月份分组,然后计算每个月内的3天滑动平均销售额。这种技术在时间序列分析中特别有用。

6.2 使用pivot_table进行多维分析

pivot_table函数允许我们轻松地创建交叉表,进行多维数据分析:

import pandas as pd

# 创建示例数据

data = {

'date': pd.date_range(start='2023-01-01', periods=20),

'product': ['A', 'B'] * 10,

'region': ['East', 'West', 'North', 'South'] * 5,

'sales': range(100, 2100, 100)

}

df = pd.DataFrame(data)

# 创建pivot table

result = pd.pivot_table(df, values='sales', index=['date'],

columns=['product', 'region'], aggfunc='sum')

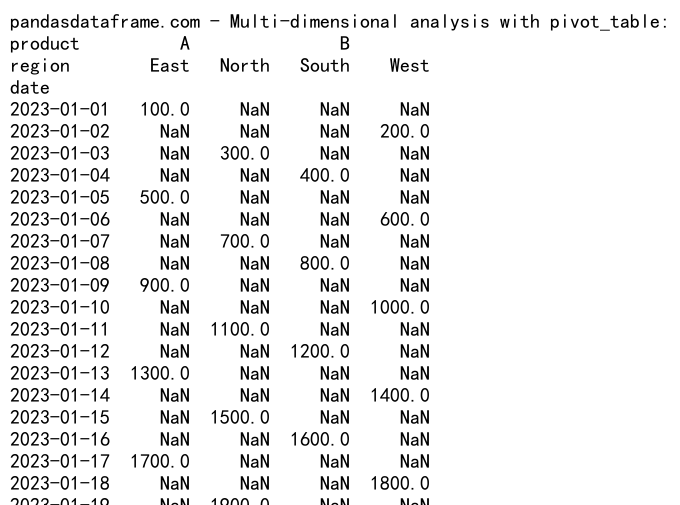

print("pandasdataframe.com - Multi-dimensional analysis with pivot_table:")

print(result)

Output:

在这个例子中,我们创建了一个包含日期、产品、地区和销售额的DataFrame,然后使用pivot_table函数创建了一个多维交叉表。这种方法可以帮助我们快速了解不同产品在不同地区的销售情况。

7. 数据可视化

数据分析的一个重要步骤是数据可视化。Pandas与matplotlib等可视化库集成得很好,可以轻松创建各种图表。

7.1 使用plot方法创建图表

import pandas as pd

import matplotlib.pyplot as plt

# 创建示例数据

data = {

'date': pd.date_range(start='2023-01-01', periods=30),

'sales': range(100, 3100, 100)

}

df = pd.DataFrame(data)

# 按周分组并计算平均销售额

weekly_sales = df.groupby(df['date'].dt.isocalendar().week)['sales'].mean()

# 创建折线图

plt.figure(figsize=(10, 6))

weekly_sales.plot(kind='line', marker='o')

plt.title('Average Weekly Sales')

plt.xlabel('Week')

plt.ylabel('Average Sales')

plt.grid(True)

plt.savefig('pandasdataframe.com_weekly_sales.png')

plt.close()

print("pandasdataframe.com - Line plot of weekly sales has been saved.")

在这个例子中,我们首先按周分组并计算平均销售额,然后使用Pandas的plot方法创建了一个折线图。这种方法可以直观地展示销售趋势。

7.2 使用seaborn创建高级图表

对于更复杂的可视化需求,我们可以使用seaborn库:

import pandas as pd

import seaborn as sns

import matplotlib.pyplot as plt

# 创建示例数据

data = {

'date': pd.date_range(start='2023-01-01', periods=60),

'product': ['A', 'B', 'C'] * 20,

'sales': range(100, 6100, 100)

}

df = pd.DataFrame(data)

# 按月和产品分组

monthly_sales = df.groupby([df['date'].dt.month, 'product'])['sales'].sum().unstack()

# 创建热力图

plt.figure(figsize=(12, 8))

sns.heatmap(monthly_sales, annot=True, fmt='g', cmap='YlOrRd')

plt.title('Monthly Sales by Product')

plt.xlabel('Product')

plt.ylabel('Month')

plt.savefig('pandasdataframe.com_monthly_sales_heatmap.png')

plt.close()

print("pandasdataframe.com - Heatmap of monthly sales by product has been saved.")

在这个例子中,我们使用seaborn创建了一个热力图,展示了不同产品在不同月份的销售情况。这种可视化方法可以帮助我们快速识别销售模式和趋势。

8. 性能优化技巧

当处理大型数据集时,性能优化变得尤为重要。以下是一些可以提高Pandas groupby操作性能的技巧。

8.1 使用numba加速

对于某些计算密集型操作,我们可以使用numba库来加速:

import pandas as pd

import numpy as np

from numba import jit

# 创建大型示例数据

n = 1000000

data = {

'group': np.random.choice(['A', 'B', 'C'], n),

'value1': np.random.rand(n),

'value2': np.random.rand(n)

}

df = pd.DataFrame(data)

# 定义numba加速的函数

@jit(nopython=True)

def custom_agg(values1, values2):

return np.sum(values1 * values2)

# 使用numba加速的函数进行groupby操作

result = df.groupby('group').apply(lambda x: custom_agg(x['value1'].values, x['value2'].values))

print("pandasdataframe.com - Accelerated groupby operation using numba:")

print(result)

在这个例子中,我们使用numba的@jit装饰器来加速自定义聚合函数。这种方法对于需要大量数值计算的操作特别有效。

8.2 使用swifter并行处理

对于某些可以并行化的操作,我们可以使用swifter库来加速:

import pandas as pd

import numpy as np

import swifter

# 创建大型示例数据

n = 1000000

data = {

'group': np.random.choice(['A', 'B', 'C'], n),

'value': np.random.rand(n)

}

df = pd.DataFrame(data)

# 定义复杂的自定义函数

def complex_operation(x):

return np.sum(np.exp(x) * np.log(x + 1))

# 使用swifter并行处理

result = df.groupby('group')['value'].swifter.apply(complex_operation)

print("pandasdataframe.com - Parallel processing using swifter:")

print(result)

在这个例子中,我们使用swifter库来并行化apply操作。这种方法可以显著提高复杂操作的处理速度,特别是在多核系统上。

9. 处理时间序列数据

Pandas提供了强大的时间序列处理功能,这在金融分析、销售预测等领域非常有用。

9.1 重采样时间序列数据

import pandas as pd

import numpy as np

# 创建时间序列数据

dates = pd.date_range(start='2023-01-01', end='2023-12-31', freq='D')

data = {

'date': dates,

'sales': np.random.randint(100, 1000, size=len(dates))

}

df = pd.DataFrame(data)

df.set_index('date', inplace=True)

# 按月重采样并计算平均销售额

monthly_sales = df.resample('M')['sales'].mean()

print("pandasdataframe.com - Resampled monthly sales:")

print(monthly_sales)

在这个例子中,我们创建了一个每日销售数据的时间序列,然后使用resample方法将其转换为月度平均销售额。这种技术在分析长期趋势时非常有用。

9.2 时间序列的移动窗口计算

import pandas as pd

import numpy as np

# 创建时间序列数据

dates = pd.date_range(start='2023-01-01', end='2023-12-31', freq='D')

data = {

'date': dates,

'sales': np.random.randint(100, 1000, size=len(dates))

}

df = pd.DataFrame(data)

df.set_index('date', inplace=True)

# 计算30天移动平均

df['30d_ma'] = df['sales'].rolling(window=30).mean()

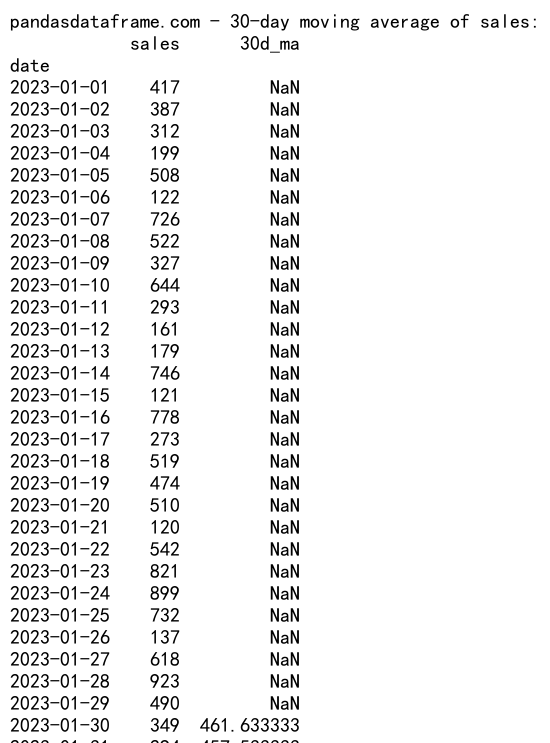

print("pandasdataframe.com - 30-day moving average of sales:")

print(df.head(35))

Output:

在这个例子中,我们计算了销售数据的30天移动平均。这种技术可以帮助我们平滑短期波动,更好地观察长期趋势。

10. 高级groupby技巧

除了基本的groupby操作,Pandas还提供了一些高级技巧,可以帮助我们更灵活地处理复杂的数据分析任务。

10.1 使用groupby和transform进行复杂计算

import pandas as pd

import numpy as np

# 创建示例数据

data = {

'date': pd.date_range(start='2023-01-01', periods=100),

'product': np.random.choice(['A', 'B', 'C'], 100),

'sales': np.random.randint(100, 1000, 100)

}

df = pd.DataFrame(data)

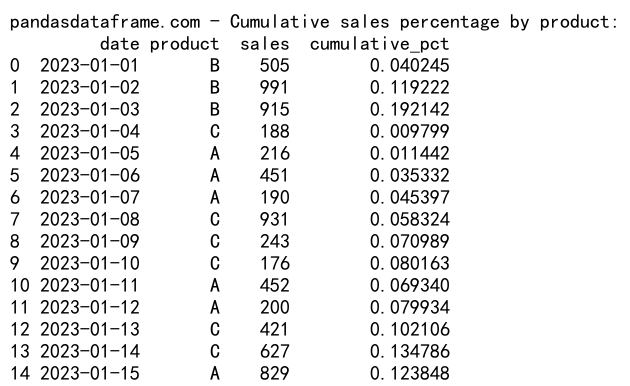

# 计算每个产品的累计销售百分比

df['cumulative_pct'] = df.groupby('product')['sales'].transform(

lambda x: x.cumsum() / x.sum()

)

print("pandasdataframe.com - Cumulative sales percentage by product:")

print(df.head(15))

Output:

在这个例子中,我们使用groupby和transform来计算每个产品的累计销售百分比。这种方法可以帮助我们了解每个产品的销售进度。

10.2 使用groupby和agg进行多列操作

import pandas as pd

import numpy as np

# 创建示例数据

data = {

'date': pd.date_range(start='2023-01-01', periods=100),

'product': np.random.choice(['A', 'B', 'C'], 100),

'sales': np.random.randint(100, 1000, 100),

'cost': np.random.randint(50, 500, 100)

}

df = pd.DataFrame(data)

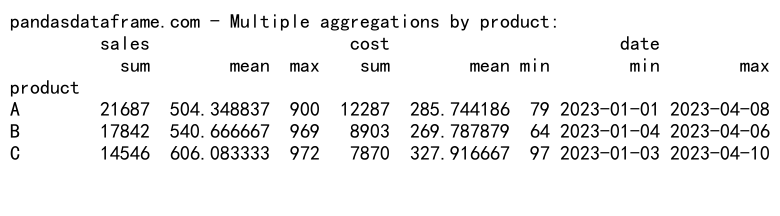

# 使用agg进行多列操作

result = df.groupby('product').agg({

'sales': ['sum', 'mean', 'max'],

'cost': ['sum', 'mean', 'min'],

'date': ['min', 'max']

})

print("pandasdataframe.com - Multiple aggregations by product:")

print(result)

Output:

在这个例子中,我们使用groupby和agg对多个列进行不同的聚合操作。这种方法可以帮助我们一次性获得多个统计指标。

结论

Pandas的groupby功能是一个强大的数据分析工具,特别是在处理和合并多列数据时。通过本文介绍的各种技巧和方法,我们可以更加灵活和高效地处理复杂的数据分析任务。从基本的分组操作到高级的时间序列分析,从处理缺失值到优化大型数据集的性能,Pandas都提供了丰富的功能和灵活的API。

在实际应用中,选择合适的方法取决于具体的数据结构和分析需求。通过不断实践和探索,我们可以充分发挥Pandas的潜力,提高数据分析的效率和质量。希望本文能为读者提供有价值的参考,帮助大家在日常工作中更好地利用Pandas进行数据分析。

极客笔记

极客笔记