Pandas GroupBy和Bins:高效数据分组与区间划分技巧

Pandas是Python中强大的数据处理库,其中GroupBy和Bins功能为数据分析提供了强大的工具。本文将深入探讨Pandas中GroupBy和Bins的使用方法、应用场景以及实际示例,帮助您更好地理解和运用这些功能来处理和分析数据。

1. Pandas GroupBy简介

GroupBy是Pandas中用于数据分组的重要功能。它允许我们根据一个或多个列的值将数据分成不同的组,然后对每个组应用聚合函数或其他操作。

1.1 基本用法

以下是一个简单的GroupBy示例:

import pandas as pd

# 创建示例数据

data = {

'name': ['Alice', 'Bob', 'Charlie', 'David', 'Eve'],

'age': [25, 30, 35, 28, 32],

'city': ['New York', 'London', 'Paris', 'New York', 'London'],

'salary': [50000, 60000, 70000, 55000, 65000]

}

df = pd.DataFrame(data)

# 按城市分组并计算平均工资

grouped = df.groupby('city')['salary'].mean()

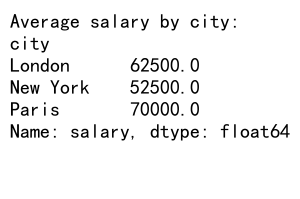

print("Average salary by city:")

print(grouped)

Output:

在这个例子中,我们创建了一个包含姓名、年龄、城市和工资信息的DataFrame。然后,我们使用groupby()方法按城市分组,并计算每个城市的平均工资。

1.2 多列分组

GroupBy还支持多列分组:

import pandas as pd

# 创建示例数据

data = {

'name': ['Alice', 'Bob', 'Charlie', 'David', 'Eve', 'Frank'],

'department': ['HR', 'IT', 'Finance', 'HR', 'IT', 'Finance'],

'experience': ['Junior', 'Senior', 'Senior', 'Junior', 'Senior', 'Junior'],

'salary': [50000, 80000, 75000, 52000, 85000, 60000]

}

df = pd.DataFrame(data)

# 按部门和经验级别分组,计算平均工资

grouped = df.groupby(['department', 'experience'])['salary'].mean()

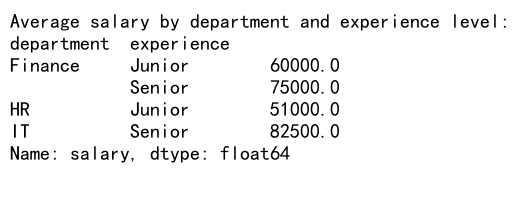

print("Average salary by department and experience level:")

print(grouped)

Output:

这个例子展示了如何按多个列(部门和经验级别)进行分组,并计算每个组合的平均工资。

2. Pandas Bins简介

Bins是Pandas中用于将连续数据划分为离散区间的功能。它在数据分析中非常有用,特别是在处理连续变量时。

2.1 使用cut()函数

pd.cut()函数是创建bins的主要方法:

import pandas as pd

import numpy as np

# 创建示例数据

np.random.seed(0)

data = {

'score': np.random.randint(0, 101, 100),

'name': [f'Student_{i}' for i in range(100)]

}

df = pd.DataFrame(data)

# 使用cut()函数创建分数区间

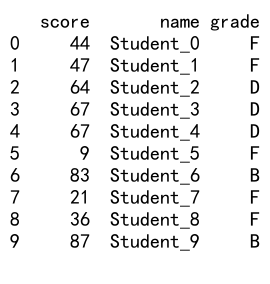

df['grade'] = pd.cut(df['score'], bins=[0, 60, 70, 80, 90, 100], labels=['F', 'D', 'C', 'B', 'A'])

print(df.head(10))

Output:

在这个例子中,我们创建了一个包含100名学生分数的DataFrame。然后,我们使用pd.cut()函数将分数划分为5个等级(A、B、C、D、F)。

2.2 使用qcut()函数

pd.qcut()函数用于创建基于分位数的bins:

import pandas as pd

import numpy as np

# 创建示例数据

np.random.seed(0)

data = {

'salary': np.random.randint(30000, 100001, 1000),

'employee_id': [f'EMP_{i}' for i in range(1000)]

}

df = pd.DataFrame(data)

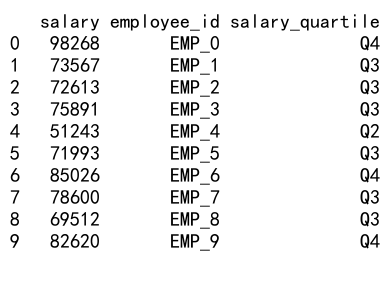

# 使用qcut()函数创建工资四分位数

df['salary_quartile'] = pd.qcut(df['salary'], q=4, labels=['Q1', 'Q2', 'Q3', 'Q4'])

print(df.head(10))

Output:

这个例子展示了如何使用pd.qcut()函数将工资数据划分为四个等大小的区间(四分位数)。

3. GroupBy和Bins的结合使用

GroupBy和Bins的结合使用可以帮助我们更深入地分析数据。以下是一些实际应用的例子:

3.1 年龄组分析

import pandas as pd

import numpy as np

# 创建示例数据

np.random.seed(0)

data = {

'age': np.random.randint(18, 81, 1000),

'income': np.random.randint(20000, 100001, 1000),

'education': np.random.choice(['High School', 'Bachelor', 'Master', 'PhD'], 1000)

}

df = pd.DataFrame(data)

# 创建年龄组

df['age_group'] = pd.cut(df['age'], bins=[0, 25, 35, 45, 55, 65, 100], labels=['18-25', '26-35', '36-45', '46-55', '56-65', '65+'])

# 按年龄组和教育程度分组,计算平均收入

grouped = df.groupby(['age_group', 'education'])['income'].mean().unstack()

print("Average income by age group and education level:")

print(grouped)

这个例子展示了如何将年龄数据划分为不同的年龄组,然后按年龄组和教育程度分组计算平均收入。这种分析可以帮助我们了解不同年龄段和教育背景的人群的收入情况。

3.2 销售数据分析

import pandas as pd

import numpy as np

# 创建示例数据

np.random.seed(0)

data = {

'date': pd.date_range(start='2023-01-01', end='2023-12-31', freq='D'),

'sales': np.random.randint(1000, 10001, 365),

'product': np.random.choice(['A', 'B', 'C'], 365)

}

df = pd.DataFrame(data)

# 创建月份和季度

df['month'] = df['date'].dt.month

df['quarter'] = df['date'].dt.quarter

# 按产品和季度分组,计算总销售额

quarterly_sales = df.groupby(['product', 'quarter'])['sales'].sum().unstack()

# 创建销售额区间

df['sales_category'] = pd.cut(df['sales'], bins=[0, 3000, 6000, 10000], labels=['Low', 'Medium', 'High'])

# 按销售额类别和产品分组,计算天数

sales_distribution = df.groupby(['sales_category', 'product']).size().unstack()

print("Quarterly sales by product:")

print(quarterly_sales)

print("\nSales distribution by category and product:")

print(sales_distribution)

这个例子展示了如何分析销售数据。我们首先按产品和季度分组计算总销售额,然后将销售额划分为不同的类别(低、中、高),并统计每个类别和产品组合的天数。这种分析可以帮助我们了解不同产品在不同季度的销售表现,以及销售额的分布情况。

4. GroupBy的高级用法

除了基本的分组和聚合操作,GroupBy还提供了许多高级功能,可以帮助我们更深入地分析数据。

4.1 自定义聚合函数

我们可以使用自定义函数进行聚合操作:

import pandas as pd

import numpy as np

# 创建示例数据

data = {

'name': ['Alice', 'Bob', 'Charlie', 'David', 'Eve'] * 2,

'department': ['HR', 'IT', 'Finance', 'HR', 'IT'] * 2,

'salary': [50000, 60000, 70000, 55000, 65000, 52000, 62000, 72000, 57000, 67000]

}

df = pd.DataFrame(data)

# 自定义聚合函数

def salary_range(x):

return pd.Series({'min': x.min(), 'max': x.max(), 'range': x.max() - x.min()})

# 按部门分组并应用自定义聚合函数

result = df.groupby('department')['salary'].apply(salary_range)

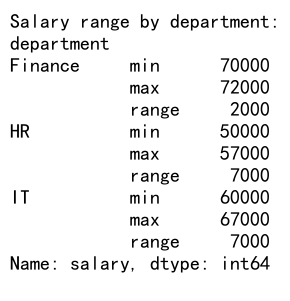

print("Salary range by department:")

print(result)

Output:

在这个例子中,我们定义了一个自定义函数salary_range,它计算每个部门的最低工资、最高工资和工资范围。然后,我们使用apply()方法将这个函数应用到每个分组。

4.2 多列聚合

我们可以同时对多个列进行不同的聚合操作:

import pandas as pd

import numpy as np

# 创建示例数据

np.random.seed(0)

data = {

'name': [f'Employee_{i}' for i in range(100)],

'department': np.random.choice(['HR', 'IT', 'Finance', 'Marketing'], 100),

'salary': np.random.randint(30000, 100001, 100),

'age': np.random.randint(22, 61, 100),

'years_of_service': np.random.randint(0, 31, 100)

}

df = pd.DataFrame(data)

# 多列聚合

result = df.groupby('department').agg({

'salary': ['mean', 'median', 'std'],

'age': ['min', 'max', 'mean'],

'years_of_service': ['mean', 'max']

})

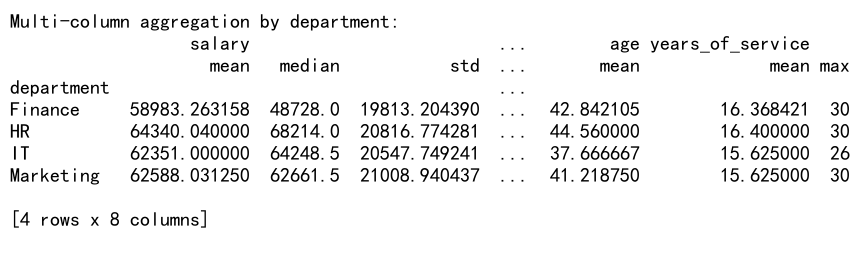

print("Multi-column aggregation by department:")

print(result)

Output:

这个例子展示了如何对不同的列应用不同的聚合函数。我们计算了每个部门的平均工资、中位数工资、工资标准差、最小年龄、最大年龄、平均年龄、平均服务年限和最长服务年限。

4.3 分组转换

GroupBy还支持转换操作,可以将聚合结果应用回原始数据:

import pandas as pd

import numpy as np

# 创建示例数据

np.random.seed(0)

data = {

'name': [f'Student_{i}' for i in range(100)],

'class': np.random.choice(['A', 'B', 'C'], 100),

'score': np.random.randint(60, 101, 100)

}

df = pd.DataFrame(data)

# 计算每个班级的平均分数,并添加到原始数据中

df['class_avg'] = df.groupby('class')['score'].transform('mean')

# 计算每个学生相对于班级平均分数的差异

df['score_diff'] = df['score'] - df['class_avg']

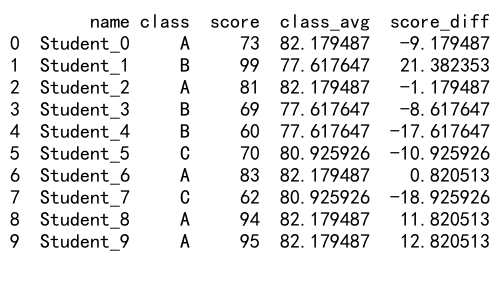

print(df.head(10))

Output:

在这个例子中,我们首先计算了每个班级的平均分数,并使用transform()方法将结果应用回原始数据。然后,我们计算了每个学生的分数与班级平均分数的差异。这种方法可以帮助我们识别在各自班级中表现突出或落后的学生。

5. Bins的高级用法

Bins不仅可以用于简单的数据分类,还可以用于更复杂的数据分析任务。

5.1 自定义区间标签

我们可以为bins指定自定义的标签:

import pandas as pd

import numpy as np

# 创建示例数据

np.random.seed(0)

data = {

'name': [f'Product_{i}' for i in range(100)],

'price': np.random.uniform(10, 1000, 100)

}

df = pd.DataFrame(data)

# 创建自定义价格区间

bins = [0, 50, 100, 250, 500, 1000]

labels = ['Budget', 'Economy', 'Mid-range', 'Premium', 'Luxury']

df['price_category'] = pd.cut(df['price'], bins=bins, labels=labels, include_lowest=True)

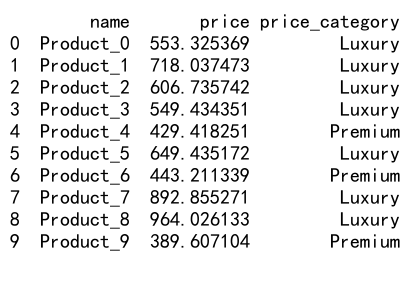

print(df.head(10))

Output:

在这个例子中,我们为产品价格创建了自定义的区间和标签,将产品分类为预算型、经济型、中档、高档和奢侈品。

5.2 使用qcut()进行等频分箱

qcut()函数可以用于创建等频区间:

import pandas as pd

import numpy as np

# 创建示例数据

np.random.seed(0)

data = {

'name': [f'Customer_{i}' for i in range(1000)],

'spending': np.random.exponential(scale=500, size=1000)

}

df = pd.DataFrame(data)

# 创建等频区间

df['spending_quintile'] = pd.qcut(df['spending'], q=5, labels=['Q1', 'Q2', 'Q3', 'Q4', 'Q5'])

# 计算每个分位数的统计信息

quintile_stats = df.groupby('spending_quintile')['spending'].agg(['min', 'max', 'mean', 'median'])

print("Spending quintile statistics:")

print(quintile_stats)

这个例子展示了如何使用qcut()函数将客户支出数据划分为五个等频区间(五分位数),并计算每个区间的统计信息。这种方法可以帮助我们了解客户支出的分布情况。

5.3 动态确定bin的数量

有时我们可能需要根据数据的分布动态确定bin的数量:

import pandas as pd

import numpy as np

from scipy import stats

# 创建示例数据

np.random.seed(0)

data = {

'value': np.concatenate([

np.random.normal(0, 1, 1000),

np.random.normal(5, 1, 500),

np.random.normal(-5, 1, 500)

])

}

df = pd.DataFrame(data)

# 使用Freedman-Diaconis规则确定bin的数量

iqr = stats.iqr(df['value'])

bin_width = 2 * iqr / (len(df) ** (1/3))

bin_count = int((df['value'].max() - df['value'].min()) / bin_width)

# 创建动态bins

df['bin'] = pd.cut(df['value'], bins=bin_count)

# 计算每个bin的频率

bin_freq = df['bin'].value_counts().sort_index()

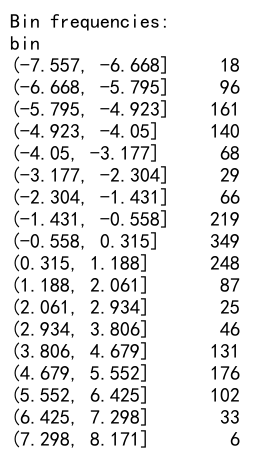

print("Bin frequencies:")

print(bin_freq)

Output:

在这个例子中,我们使用Freedman-Diaconis规则来动态确定bin的数量。这种方法考虑了数据的分布特征,可以更好地反映数据的真实分布情况。

6. GroupBy和Bins在数据分析中的应用

GroupBy和Bins是数据分析中非常有用的工具,它们可以帮助我们发现数据中的模式和趋势。以下是一些实际应用的例子:

6.1 客户分群分析

import pandas as pd

import numpy as np

# 创建示例数据

np.random.seed(0)

data = {

'customer_id': [f'CUST_{i}' for i in range(1000)],

'age': np.random.randint(18, 81, 1000),

'income': np.random.randint(20000, 200001, 1000),

'spending': np.random.randint(1000, 50001, 1000)

}

df = pd.DataFrame(data)

# 创建年龄组和收入组

df['age_group'] = pd.cut(df['age'], bins=[0, 30, 45, 60, 100], labels=['Young', 'Middle-aged', 'Senior', 'Elderly'])

df['income_group'] = pd.qcut(df['income'], q=3, labels=['Low', 'Medium', 'High'])

# 按年龄组和收入组分组,计算平均支出

grouped = df.groupby(['age_group', 'income_group'])['spending'].mean().unstack()

print("Average spending by age group and income group:")

print(grouped)

# 计算每个客户群的大小

group_size = df.groupby(['age_group', 'income_group']).size().unstack()

print("\nCustomer group sizes:")

print(group_size)

这个例子展示了如何使用GroupBy和Bins进行客户分群分析。我们将客户按年龄和收入分组,然后计算每个群体的平均支出和群体大小。这种分析可以帮助我们了解不同年龄和收入水平的客户的消费行为,从而制定针对性的营销策略。

6.2 时间序列数据分析

import pandas as pd

import numpy as np

# 创建示例数据

np.random.seed(0)

date_range = pd.date_range(start='2023-01-01', end='2023-12-31', freq='D')

data = {

'date': date_range,

'sales': np.random.randint(1000, 10001, len(date_range))

}

df = pd.DataFrame(data)

# 提取月份和季度

df['month'] = df['date'].dt.month

df['quarter'] = df['date'].dt.quarter

# 按月份分组计算总销售额

monthly_sales = df.groupby('month')['sales'].sum()

# 创建销售额区间

df['sales_category'] = pd.cut(df['sales'], bins=[0, 3000, 6000, 10000], labels=['Low', 'Medium', 'High'])

# 计算每个季度各销售类别的天数

quarterly_sales_distribution = df.groupby(['quarter', 'sales_category']).size().unstack()

print("Monthly sales:")

print(monthly_sales)

print("\nQuarterly sales distribution:")

print(quarterly_sales_distribution)

这个例子展示了如何使用GroupBy和Bins分析时间序列数据。我们首先按月份分组计算总销售额,然后将每日销售额划分为不同的类别,并统计每个季度各销售类别的天数。这种分析可以帮助我们了解销售的季节性模式和整体趋势。

6.3 产品性能分析

import pandas as pd

import numpy as np

# 创建示例数据

np.random.seed(0)

products = ['A', 'B', 'C', 'D', 'E']

data = {

'product': np.random.choice(products, 1000),

'sales': np.random.randint(100, 1001, 1000),

'customer_rating': np.random.uniform(1, 5, 1000)

}

df = pd.DataFrame(data)

# 计算每个产品的总销售额和平均评分

product_performance = df.groupby('product').agg({

'sales': 'sum',

'customer_rating': 'mean'

})

# 创建销售额和评分的区间

product_performance['sales_category'] = pd.qcut(product_performance['sales'], q=3, labels=['Low', 'Medium', 'High'])

product_performance['rating_category'] = pd.cut(product_performance['customer_rating'], bins=[0, 2, 3.5, 5], labels=['Poor', 'Average', 'Good'])

print("Product performance analysis:")

print(product_performance)

# 计算每个销售类别和评分类别的产品数量

performance_distribution = product_performance.groupby(['sales_category', 'rating_category']).size().unstack()

print("\nProduct performance distribution:")

print(performance_distribution)

这个例子展示了如何使用GroupBy和Bins分析产品性能。我们首先计算每个产品的总销售额和平均客户评分,然后将产品按销售额和评分分类。最后,我们统计了每个类别组合的产品数量。这种分析可以帮助我们识别表现优秀和需要改进的产品。

7. GroupBy和Bins的性能优化

在处理大型数据集时,GroupBy和Bins操作可能会变得耗时。以下是一些优化性能的技巧:

7.1 使用分类数据类型

对于分组键,使用分类数据类型可以显著提高性能:

import pandas as pd

import numpy as np

# 创建大型示例数据

np.random.seed(0)

n = 1000000

data = {

'id': range(n),

'category': np.random.choice(['A', 'B', 'C', 'D', 'E'], n),

'value': np.random.randn(n)

}

df = pd.DataFrame(data)

# 将category列转换为分类类型

df['category'] = df['category'].astype('category')

# 使用分类类型进行分组操作

result = df.groupby('category')['value'].mean()

print("Group means:")

print(result)

在这个例子中,我们将’category’列转换为分类类型。这可以减少内存使用并提高GroupBy操作的速度,特别是对于具有有限数量唯一值的列。

7.2 使用numba加速自定义聚合函数

对于复杂的自定义聚合函数,可以使用numba进行加速:

import pandas as pd

import numpy as np

from numba import jit

# 创建示例数据

np.random.seed(0)

n = 1000000

data = {

'group': np.random.choice(['A', 'B', 'C', 'D', 'E'], n),

'value': np.random.randn(n)

}

df = pd.DataFrame(data)

# 使用numba加速的自定义聚合函数

@jit(nopython=True)

def custom_agg(values):

return np.mean(values) / np.std(values)

# 应用加速后的聚合函数

result = df.groupby('group')['value'].agg(custom_agg)

print("Custom aggregation result:")

print(result)

在这个例子中,我们使用numba的@jit装饰器来编译自定义聚合函数。这可以显著提高复杂计算的速度,特别是对于大型数据集。

7.3 使用pandas_groupby_parallel进行并行处理

对于非常大的数据集,可以考虑使用并行处理来加速GroupBy操作:

import pandas as pd

import numpy as np

from pandas_groupby_parallel import apply_parallel

# 创建大型示例数据

np.random.seed(0)

n = 10000000

data = {

'id': range(n),

'group': np.random.choice(['A', 'B', 'C', 'D', 'E'], n),

'value': np.random.randn(n)

}

df = pd.DataFrame(data)

# 定义要并行应用的函数

def custom_agg(group):

return pd.Series({

'mean': group['value'].mean(),

'std': group['value'].std()

})

# 使用并行处理进行GroupBy操作

result = apply_parallel(df.groupby('group'), custom_agg)

print("Parallel GroupBy result:")

print(result)

这个例子展示了如何使用pandas_groupby_parallel库进行并行GroupBy操作。这可以显著提高大型数据集的处理速度,特别是在多核处理器上。

8. 结论

Pandas的GroupBy和Bins功能为数据分析提供了强大而灵活的工具。通过合理使用这些功能,我们可以有效地对数据进行分组、聚合和分类,从而发现数据中的模式和趋势。

本文详细介绍了GroupBy和Bins的基本用法、高级技巧以及在实际数据分析中的应用。我们还讨论了一些性能优化的方法,以应对大型数据集的挑战。

在实际工作中,熟练运用GroupBy和Bins可以帮助我们更好地理解和分析数据,为决策提供有力支持。无论是客户分群、时间序列分析还是产品性能评估,这些工具都能发挥重要作用。

随着数据规模的不断增长和分析需求的日益复杂,掌握这些技能将成为数据分析师和数据科学家的重要竞争力。通过不断实践和探索,我们可以更好地利用Pandas的这些强大功能,从数据中挖掘出有价值的洞察。

极客笔记

极客笔记