Pandas中强大的数据分组与聚合:GroupBy和Agg函数详解

Pandas是Python中最流行的数据处理库之一,它提供了强大的数据操作和分析工具。在处理大型数据集时,我们经常需要对数据进行分组和聚合操作,以便更好地理解和分析数据。Pandas的GroupBy和Agg函数就是为此而生的,它们能够帮助我们轻松地对数据进行分组、聚合和统计分析。本文将深入探讨Pandas中GroupBy和Agg函数的使用方法、常见应用场景以及一些高级技巧。

1. GroupBy函数简介

GroupBy函数是Pandas中用于数据分组的核心功能。它允许我们根据一个或多个列的值将数据分成不同的组,然后对每个组进行单独的操作或分析。GroupBy的基本语法如下:

import pandas as pd

# 创建示例数据

data = {

'name': ['Alice', 'Bob', 'Charlie', 'David', 'Eve'],

'age': [25, 30, 35, 28, 32],

'city': ['New York', 'London', 'Paris', 'New York', 'London'],

'salary': [50000, 60000, 70000, 55000, 65000]

}

df = pd.DataFrame(data)

# 按城市分组

grouped = df.groupby('city')

在这个例子中,我们创建了一个包含姓名、年龄、城市和薪资信息的DataFrame,然后使用groupby('city')按城市对数据进行分组。这个操作会返回一个GroupBy对象,我们可以在这个对象上进行进一步的操作。

2. 基本的GroupBy操作

2.1 计算组内统计量

GroupBy对象支持多种统计操作,如计算平均值、总和、最大值、最小值等。以下是一些常见的统计操作示例:

import pandas as pd

# 创建示例数据

data = {

'name': ['Alice', 'Bob', 'Charlie', 'David', 'Eve'],

'age': [25, 30, 35, 28, 32],

'city': ['New York', 'London', 'Paris', 'New York', 'London'],

'salary': [50000, 60000, 70000, 55000, 65000]

}

df = pd.DataFrame(data)

# 计算每个城市的平均薪资

avg_salary = df.groupby('city')['salary'].mean()

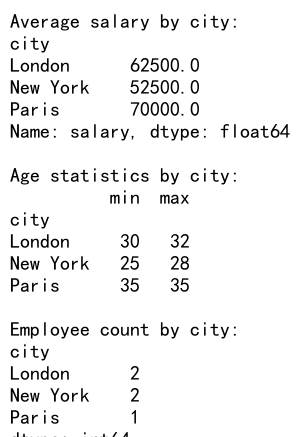

print("Average salary by city:")

print(avg_salary)

# 计算每个城市的最高和最低年龄

age_stats = df.groupby('city')['age'].agg(['min', 'max'])

print("\nAge statistics by city:")

print(age_stats)

# 计算每个城市的员工数量

employee_count = df.groupby('city').size()

print("\nEmployee count by city:")

print(employee_count)

Output:

在这个例子中,我们展示了如何计算每个城市的平均薪资、最高和最低年龄,以及员工数量。这些操作可以帮助我们快速了解不同城市之间的差异。

2.2 多列分组

GroupBy不仅支持单列分组,还可以根据多个列进行分组。这在处理复杂的数据结构时非常有用。

import pandas as pd

# 创建示例数据

data = {

'name': ['Alice', 'Bob', 'Charlie', 'David', 'Eve', 'Frank'],

'department': ['HR', 'IT', 'Finance', 'HR', 'IT', 'Finance'],

'city': ['New York', 'London', 'Paris', 'New York', 'London', 'Paris'],

'salary': [50000, 60000, 70000, 55000, 65000, 75000]

}

df = pd.DataFrame(data)

# 按部门和城市分组,计算平均薪资

avg_salary = df.groupby(['department', 'city'])['salary'].mean()

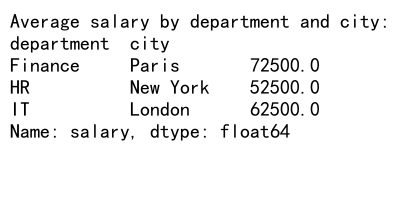

print("Average salary by department and city:")

print(avg_salary)

Output:

在这个例子中,我们按照部门和城市两个维度对数据进行分组,然后计算每个组的平均薪资。这样可以帮助我们了解不同部门在不同城市的薪资水平。

2.3 遍历分组

有时我们需要对每个分组进行自定义操作。GroupBy对象支持遍历,让我们可以访问每个分组的数据。

import pandas as pd

# 创建示例数据

data = {

'name': ['Alice', 'Bob', 'Charlie', 'David', 'Eve'],

'department': ['HR', 'IT', 'Finance', 'HR', 'IT'],

'salary': [50000, 60000, 70000, 55000, 65000]

}

df = pd.DataFrame(data)

# 遍历每个部门的数据

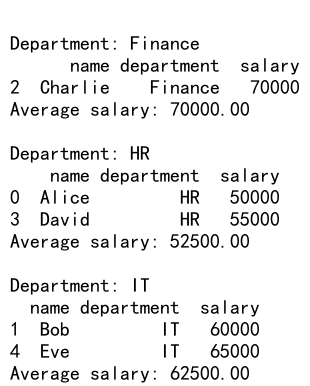

for department, group in df.groupby('department'):

print(f"\nDepartment: {department}")

print(group)

print(f"Average salary: {group['salary'].mean():.2f}")

Output:

这个例子展示了如何遍历按部门分组的数据。对于每个部门,我们打印出该部门的所有员工信息以及平均薪资。这种方法允许我们对每个分组进行更复杂的自定义操作。

3. Agg函数:强大的聚合工具

Agg函数是Pandas中用于数据聚合的高级工具。它允许我们在一次操作中对多个列应用不同的聚合函数,大大提高了数据处理的效率和灵活性。

3.1 基本用法

Agg函数可以接受一个函数、函数列表或者一个字典作为参数,用于指定要应用的聚合操作。

import pandas as pd

# 创建示例数据

data = {

'name': ['Alice', 'Bob', 'Charlie', 'David', 'Eve'],

'age': [25, 30, 35, 28, 32],

'city': ['New York', 'London', 'Paris', 'New York', 'London'],

'salary': [50000, 60000, 70000, 55000, 65000]

}

df = pd.DataFrame(data)

# 使用agg函数进行多种聚合操作

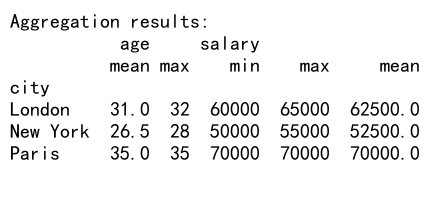

result = df.groupby('city').agg({

'age': ['mean', 'max'],

'salary': ['min', 'max', 'mean']

})

print("Aggregation results:")

print(result)

Output:

在这个例子中,我们对年龄列计算了平均值和最大值,对薪资列计算了最小值、最大值和平均值。Agg函数允许我们在一次操作中完成这些复杂的聚合任务。

3.2 自定义聚合函数

除了使用内置的聚合函数,我们还可以定义自己的聚合函数并在agg中使用。

import pandas as pd

import numpy as np

# 创建示例数据

data = {

'name': ['Alice', 'Bob', 'Charlie', 'David', 'Eve'],

'age': [25, 30, 35, 28, 32],

'city': ['New York', 'London', 'Paris', 'New York', 'London'],

'salary': [50000, 60000, 70000, 55000, 65000]

}

df = pd.DataFrame(data)

# 定义自定义聚合函数

def salary_range(x):

return x.max() - x.min()

# 使用自定义函数和内置函数

result = df.groupby('city').agg({

'age': ['mean', np.median],

'salary': ['mean', salary_range]

})

print("Custom aggregation results:")

print(result)

在这个例子中,我们定义了一个salary_range函数来计算薪资范围,并将其与内置的平均值函数一起使用。这展示了agg函数的灵活性,允许我们结合使用自定义函数和内置函数。

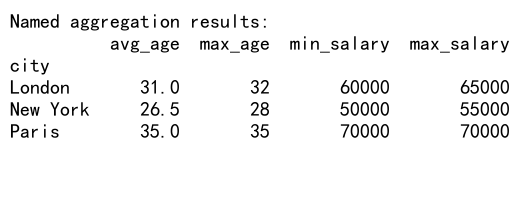

3.3 命名聚合结果

当使用多个聚合函数时,结果的列名可能会变得复杂。我们可以通过给聚合操作命名来使结果更易读。

import pandas as pd

# 创建示例数据

data = {

'name': ['Alice', 'Bob', 'Charlie', 'David', 'Eve'],

'age': [25, 30, 35, 28, 32],

'city': ['New York', 'London', 'Paris', 'New York', 'London'],

'salary': [50000, 60000, 70000, 55000, 65000]

}

df = pd.DataFrame(data)

# 使用命名聚合

result = df.groupby('city').agg(

avg_age=('age', 'mean'),

max_age=('age', 'max'),

min_salary=('salary', 'min'),

max_salary=('salary', 'max')

)

print("Named aggregation results:")

print(result)

Output:

在这个例子中,我们为每个聚合操作指定了一个名称,使得结果更加清晰易读。这种方法特别适用于需要生成报告或者与其他系统集成的场景。

4. 高级GroupBy和Agg技巧

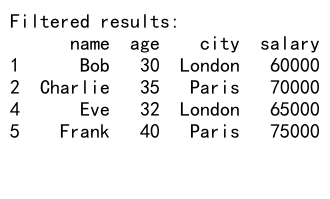

4.1 过滤分组

有时我们可能只对满足某些条件的分组感兴趣。Pandas提供了filter方法来实现这一功能。

import pandas as pd

# 创建示例数据

data = {

'name': ['Alice', 'Bob', 'Charlie', 'David', 'Eve', 'Frank'],

'age': [25, 30, 35, 28, 32, 40],

'city': ['New York', 'London', 'Paris', 'New York', 'London', 'Paris'],

'salary': [50000, 60000, 70000, 55000, 65000, 75000]

}

df = pd.DataFrame(data)

# 过滤出平均年龄大于30的城市

filtered = df.groupby('city').filter(lambda x: x['age'].mean() > 30)

print("Filtered results:")

print(filtered)

Output:

这个例子展示了如何使用filter方法来选择平均年龄大于30岁的城市。这种方法可以帮助我们在分组操作中应用复杂的过滤条件。

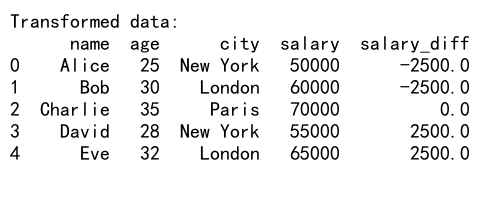

4.2 转换操作

除了聚合,GroupBy还支持转换操作,这允许我们对每个组内的数据进行修改而不改变数据的形状。

import pandas as pd

# 创建示例数据

data = {

'name': ['Alice', 'Bob', 'Charlie', 'David', 'Eve'],

'age': [25, 30, 35, 28, 32],

'city': ['New York', 'London', 'Paris', 'New York', 'London'],

'salary': [50000, 60000, 70000, 55000, 65000]

}

df = pd.DataFrame(data)

# 计算每个城市的薪资差异

def salary_diff(x):

return x - x.mean()

result = df.groupby('city')['salary'].transform(salary_diff)

df['salary_diff'] = result

print("Transformed data:")

print(df)

Output:

在这个例子中,我们使用transform方法计算了每个员工的薪资与所在城市平均薪资的差异。这种操作可以帮助我们了解每个员工在其所在城市的薪资水平。

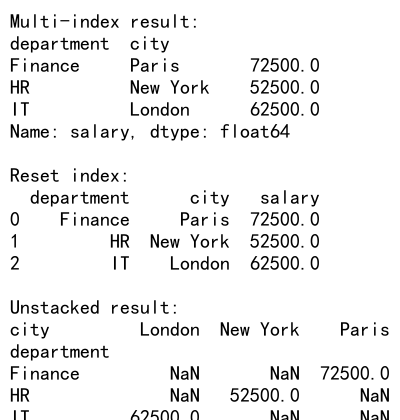

4.3 多索引结果的处理

使用多列进行分组时,结果通常会是一个多索引(MultiIndex)的DataFrame。处理这种结果需要一些特殊技巧。

import pandas as pd

# 创建示例数据

data = {

'name': ['Alice', 'Bob', 'Charlie', 'David', 'Eve', 'Frank'],

'department': ['HR', 'IT', 'Finance', 'HR', 'IT', 'Finance'],

'city': ['New York', 'London', 'Paris', 'New York', 'London', 'Paris'],

'salary': [50000, 60000, 70000, 55000, 65000, 75000]

}

df = pd.DataFrame(data)

# 按部门和城市分组,计算平均薪资

result = df.groupby(['department', 'city'])['salary'].mean()

print("Multi-index result:")

print(result)

# 重置索引,将多索引转换为列

result_reset = result.reset_index()

print("\nReset index:")

print(result_reset)

# 使用unstack()方法重塑数据

result_unstacked = result.unstack()

print("\nUnstacked result:")

print(result_unstacked)

Output:

这个例子展示了如何处理多索引结果。我们可以使用reset_index()将多索引转换为普通列,或者使用unstack()方法来重塑数据,使其更易于分析和可视化。

4.4 应用窗口函数

Pandas的GroupBy操作还支持窗口函数,这允许我们在分组内执行滑动计算。

import pandas as pd

# 创建示例数据

data = {

'date': pd.date_range(start='2023-01-01', periods=10),

'sales': [100, 150, 200, 180, 220, 250, 300, 280, 320, 350],

'product': ['A', 'B', 'A', 'B', 'A', 'B', 'A', 'B', 'A', 'B']

}

df = pd.DataFrame(data)

# 计算每个产品的3天滑动平均销售额

result = df.groupby('product')['sales'].rolling(window=3).mean()

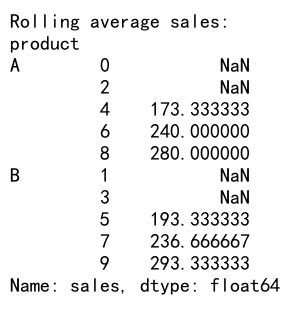

print("Rolling average sales:")

print(result)

Output:

这个例子展示了如何使用rolling()函数计算每个产品的3天滑动平均销售额。这种技术在分析时间序列数据时特别有用,可以帮助我们识别趋势和模式。

5. 实际应用场景

5.1 金融数据分析

在金融领域,GroupBy和Agg函数可以用于分析股票数据、计算投资组合表现等。

import pandas as pd

import numpy as np

# 创建示例股票数据

data = {

'date': pd.date_range(start='2023-01-01', periods=100),

'stock': np.random.choice(['AAPL', 'GOOGL', 'MSFT', 'AMZN'], 100),

'price': np.random.randint(100, 200, 100),

'volume': np.random.randint(1000, 10000, 100)

}

df = pd.DataFrame(data)

# 计算每只股票的平均价格、总交易量和价格波动

result = df.groupby('stock').agg({

'price': ['mean', lambda x: x.max() - x.min()],

'volume': 'sum'

})

result.columns = ['avg_price', 'price_range', 'total_volume']

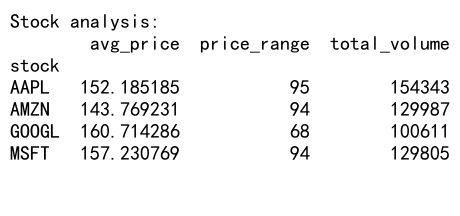

print("Stock analysis:")

print(result)

Output:

这个例子展示了如何使用GroupBy和Agg函数分析股票数据,计算每只股票的平均价格、价格波动范围和总交易量。这种分析可以帮助投资者了解不同股票的表现和风险特征。

5.2 客户行为分析

在电子商务和营销领域,GroupBy和Agg函数可以用于分析客户行为和购买模式。

import pandas as pd

import numpy as np

# 创建示例客户购买数据

data = {

'customer_id': np.random.randint(1, 101, 1000),

'purchase_date': pd.date_range(start='2023-01-01', periods=1000),

'product_category': np.random.choice(['Electronics', 'Clothing', 'Books', 'Home'], 1000),

'purchase_amount': np.random.randint(10, 500, 1000)

}

df = pd.DataFrame(data)

# 分析客户购买行为

result = df.groupby('customer_id').agg({

'purchase_amount': ['sum', 'mean', 'count'],

'product_category': lambda x: x.value_counts().index[0]

})

result.columns = ['total_spent', 'avg_purchase', 'purchase_count', 'favorite_category']

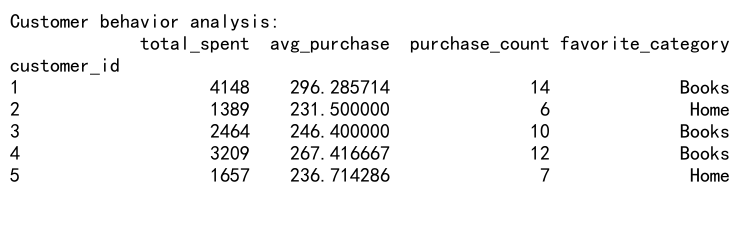

print("Customer behavior analysis:")

print(result.head())

Output:

这个例子展示了如何分析客户的购买行为,包括总消费金额、平均购买金额、购买次数和最喜爱的产品类别。这种分析可以帮助企业了解客户偏好,制定个性化营销策略。

5.3 时间序列数据分析

GroupBy和Agg函数在处理时间序列数据时也非常有用,例如分析网站流量或传感器数据。

import pandas as pd

import numpy as np

# 创建示例网站流量数据

data = {

'timestamp': pd.date_range(start='2023-01-01', periods=1000, freq='H'),

'page_views': np.random.randint(100, 1000, 1000),

'user_type': np.random.choice(['New', 'Returning'], 1000)

}

df = pd.DataFrame(data)

# 分析每天的流量情况

daily_traffic = df.groupby([df['timestamp'].dt.date, 'user_type']).agg({

'page_views': ['sum', 'mean']

})

daily_traffic.columns = ['total_views', 'avg_views']

print("Daily website traffic analysis:")

print(daily_traffic.head())

这个例子展示了如何分析每天的网站流量,包括新用户和回访用户的总浏览量和平均浏览量。这种分析可以帮助网站管理员了解流量模式和用户行为。

6. 性能优化技巧

在处理大型数据集时,GroupBy和Agg操作可能会变得很慢。以下是一些提高性能的技巧:

6.1 使用分类数据类型

对于分组列,将其转换为分类数据类型可以显著提高性能。

import pandas as pd

import numpy as np

# 创建大型示例数据集

data = {

'category': np.random.choice(['A', 'B', 'C', 'D', 'E'], 1000000),

'value': np.random.randn(1000000)

}

df = pd.DataFrame(data)

# 将category列转换为分类类型

df['category'] = df['category'].astype('category')

# 执行分组操作

result = df.groupby('category')['value'].mean()

print("Result using categorical data:")

print(result)

这个例子展示了如何将分组列转换为分类类型。对于包含有限且重复值的列,这种方法可以显著提高GroupBy操作的性能。

6.2 使用numba加速

对于自定义聚合函数,可以使用numba库来加速计算。

import pandas as pd

import numpy as np

from numba import jit

# 创建示例数据

data = {

'group': np.random.choice(['A', 'B', 'C'], 1000000),

'value': np.random.randn(1000000)

}

df = pd.DataFrame(data)

# 定义numba加速的自定义函数

@jit(nopython=True)

def custom_agg(values):

return np.mean(values) * np.std(values)

# 使用numba加速的函数进行聚合

result = df.groupby('group')['value'].agg(custom_agg)

print("Result using numba-accelerated function:")

print(result)

这个例子展示了如何使用numba库来加速自定义聚合函数。对于计算密集型的操作,这种方法可以显著提高性能。

7. 常见陷阱和注意事项

在使用GroupBy和Agg函数时,有一些常见的陷阱需要注意:

7.1 处理缺失值

GroupBy操作默认会排除缺失值,这可能会导致意外的结果。

import pandas as pd

import numpy as np

# 创建包含缺失值的示例数据

data = {

'group': ['A', 'A', 'B', 'B', 'C'],

'value': [1, np.nan, 3, 4, 5]

}

df = pd.DataFrame(data)

# 默认行为

result_default = df.groupby('group')['value'].mean()

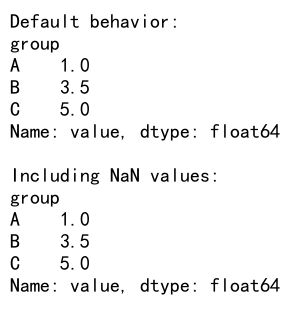

print("Default behavior:")

print(result_default)

# 包含缺失值

result_with_na = df.groupby('group', dropna=False)['value'].mean()

print("\nIncluding NaN values:")

print(result_with_na)

Output:

这个例子展示了GroupBy操作处理缺失值的默认行为,以及如何通过设置dropna=False来包含缺失值。

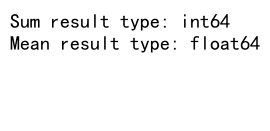

7.2 聚合结果的数据类型

某些聚合操作可能会改变结果的数据类型,这可能会影响后续的操作。

import pandas as pd

# 创建示例数据

data = {

'group': ['A', 'A', 'B', 'B', 'C'],

'value': [1, 2, 3, 4, 5]

}

df = pd.DataFrame(data)

# 不同聚合操作的结果类型

result_sum = df.groupby('group')['value'].sum()

result_mean = df.groupby('group')['value'].mean()

print("Sum result type:", result_sum.dtype)

print("Mean result type:", result_mean.dtype)

Output:

这个例子展示了不同聚合操作可能产生不同数据类型的结果。在进行后续操作时,需要注意这些类型差异。

8. 结论

Pandas的GroupBy和Agg函数是数据分析中不可或缺的工具。它们提供了强大而灵活的方法来分组、聚合和转换数据,使得复杂的数据分析任务变得简单和高效。通过本文的详细介绍和丰富的示例,我们深入探讨了这些函数的使用方法、应用场景和注意事项。

掌握这些技能将使你能够更有效地处理和分析各种类型的数据,从金融分析到客户行为研究,从时间序列数据处理到大规模数据集的性能优化。随着数据在现代商业和科研中的重要性不断增加,这些技能将成为数据科学家和分析师工具箱中的重要组成部分。

通过不断实践和探索,你将能够充分利用Pandas的GroupBy和Agg函数的潜力,为你的数据分析项目带来更深入的洞察和更高的效率。记住,数据分析是一个不断学习和创新的过程,保持好奇心和实验精神将帮助你在这个领域不断进步。

极客笔记

极客笔记