Pandas GroupBy加权平均:高效数据分析的关键技巧

参考:pandas groupby weighted average

在数据分析和处理中,Pandas库是Python生态系统中不可或缺的工具。其中,GroupBy操作和加权平均计算是两个强大的功能,当它们结合使用时,可以帮助我们更深入地理解和分析数据。本文将详细介绍Pandas中GroupBy加权平均的概念、实现方法以及实际应用场景,帮助读者掌握这一重要的数据分析技巧。

1. GroupBy操作简介

GroupBy操作是Pandas中一个非常重要的功能,它允许我们将数据按照某个或某些列的值进行分组,然后对每个分组进行各种计算和操作。这种操作类似于SQL中的GROUP BY子句,但在Pandas中更加灵活和强大。

让我们从一个简单的例子开始:

import pandas as pd

# 创建示例数据

data = {

'website': ['pandasdataframe.com', 'pandasdataframe.com', 'pandasdataframe.com', 'pandasdataframe.com'],

'category': ['A', 'B', 'A', 'B'],

'value': [10, 20, 15, 25]

}

df = pd.DataFrame(data)

# 使用GroupBy按category分组并计算平均值

grouped = df.groupby('category')['value'].mean()

print(grouped)

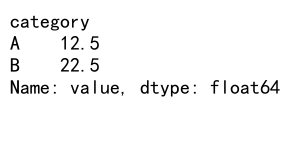

Output:

在这个例子中,我们创建了一个包含网站、类别和值的DataFrame,然后使用groupby()方法按类别分组,并计算每个类别的平均值。这个简单的操作展示了GroupBy的基本用法。

2. 加权平均的概念

加权平均是一种特殊的平均值计算方法,它考虑了每个数据点的相对重要性或权重。在普通的算术平均中,每个数据点的权重是相等的,而在加权平均中,不同的数据点可能有不同的权重。

加权平均的计算公式如下:

加权平均 = (∑(值 * 权重)) / (∑权重)

这种计算方法在许多实际场景中非常有用,例如计算学生的总成绩(不同科目有不同的学分权重),或者计算投资组合的平均回报率(不同投资有不同的资金权重)。

3. 在Pandas中实现简单的加权平均

在Pandas中,我们可以使用DataFrame的算术运算和聚合函数来实现加权平均。下面是一个简单的例子:

import pandas as pd

# 创建示例数据

data = {

'website': ['pandasdataframe.com', 'pandasdataframe.com', 'pandasdataframe.com'],

'value': [10, 20, 30],

'weight': [1, 2, 3]

}

df = pd.DataFrame(data)

# 计算加权平均

weighted_avg = (df['value'] * df['weight']).sum() / df['weight'].sum()

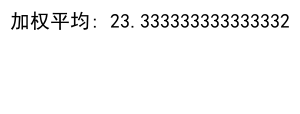

print(f"加权平均: {weighted_avg}")

Output:

在这个例子中,我们创建了一个包含值和对应权重的DataFrame。然后,我们使用Pandas的向量化操作来计算加权平均:首先将值和权重相乘,然后求和,最后除以权重的总和。

4. GroupBy与加权平均的结合

现在,让我们将GroupBy操作和加权平均计算结合起来。这种组合在处理复杂的数据集时特别有用,例如当我们需要按照某些类别分组,并计算每个组的加权平均值时。

以下是一个更复杂的例子:

import pandas as pd

# 创建示例数据

data = {

'website': ['pandasdataframe.com'] * 8,

'category': ['A', 'A', 'A', 'A', 'B', 'B', 'B', 'B'],

'subcategory': ['X', 'X', 'Y', 'Y', 'X', 'X', 'Y', 'Y'],

'value': [10, 15, 20, 25, 30, 35, 40, 45],

'weight': [1, 2, 3, 4, 5, 6, 7, 8]

}

df = pd.DataFrame(data)

# 使用GroupBy和加权平均

grouped_weighted_avg = df.groupby('category').apply(lambda x: np.average(x['value'], weights=x['weight']))

print(grouped_weighted_avg)

在这个例子中,我们创建了一个更复杂的DataFrame,包含类别、子类别、值和权重。然后,我们使用groupby()方法按类别分组,并应用一个lambda函数来计算每个组的加权平均。这个lambda函数使用NumPy的average()函数,它可以直接计算加权平均。

5. 使用agg方法进行多重计算

Pandas的agg方法允许我们在GroupBy对象上同时执行多个聚合操作。这在需要计算多个统计量时非常有用。下面是一个例子,展示如何同时计算普通平均值和加权平均值:

import pandas as pd

import numpy as np

# 创建示例数据

data = {

'website': ['pandasdataframe.com'] * 6,

'category': ['A', 'A', 'A', 'B', 'B', 'B'],

'value': [10, 20, 30, 40, 50, 60],

'weight': [1, 2, 3, 4, 5, 6]

}

df = pd.DataFrame(data)

# 定义加权平均函数

def weighted_average(group):

return np.average(group['value'], weights=group['weight'])

# 使用agg方法进行多重计算

result = df.groupby('category').agg({

'value': ['mean', weighted_average],

'weight': 'sum'

})

print(result)

在这个例子中,我们定义了一个weighted_average函数来计算加权平均,然后在agg方法中同时计算了普通平均值、加权平均值和权重总和。这种方法可以让我们在一次操作中获得多个有用的统计量。

6. 处理缺失值

在实际数据处理中,我们经常会遇到缺失值的情况。Pandas提供了多种方法来处理缺失值,在进行GroupBy加权平均计算时,我们也需要考虑这个问题。

以下是一个处理缺失值的例子:

import pandas as pd

import numpy as np

# 创建包含缺失值的示例数据

data = {

'website': ['pandasdataframe.com'] * 6,

'category': ['A', 'A', 'A', 'B', 'B', 'B'],

'value': [10, 20, np.nan, 40, 50, 60],

'weight': [1, 2, 3, 4, np.nan, 6]

}

df = pd.DataFrame(data)

# 定义处理缺失值的加权平均函数

def weighted_average_with_na(group):

return np.average(group['value'].dropna(), weights=group['weight'].dropna())

# 使用处理缺失值的函数进行GroupBy加权平均

result = df.groupby('category').apply(weighted_average_with_na)

print(result)

在这个例子中,我们创建了一个包含缺失值(NaN)的DataFrame。然后,我们定义了一个weighted_average_with_na函数,该函数在计算加权平均之前先删除了值和权重中的缺失值。这确保了我们只使用有效的数据进行计算。

7. 多级索引的GroupBy加权平均

在某些情况下,我们可能需要按多个列进行分组,并计算加权平均。这时,我们可以使用多级索引的GroupBy操作。以下是一个例子:

import pandas as pd

import numpy as np

# 创建多级索引的示例数据

data = {

'website': ['pandasdataframe.com'] * 8,

'category': ['A', 'A', 'A', 'A', 'B', 'B', 'B', 'B'],

'subcategory': ['X', 'X', 'Y', 'Y', 'X', 'X', 'Y', 'Y'],

'value': [10, 15, 20, 25, 30, 35, 40, 45],

'weight': [1, 2, 3, 4, 5, 6, 7, 8]

}

df = pd.DataFrame(data)

# 定义加权平均函数

def weighted_average(group):

return np.average(group['value'], weights=group['weight'])

# 使用多级索引的GroupBy加权平均

result = df.groupby(['category', 'subcategory']).apply(weighted_average)

print(result)

在这个例子中,我们按照’category’和’subcategory’两列进行分组,然后计算每个组的加权平均。这种方法允许我们在更细粒度的级别上分析数据。

8. 使用transform方法进行GroupBy加权平均

Pandas的transform方法允许我们对GroupBy对象应用一个函数,并返回与原始DataFrame相同形状的结果。这在我们需要保留原始数据结构的同时添加新的计算结果时非常有用。

以下是一个使用transform方法进行GroupBy加权平均的例子:

import pandas as pd

import numpy as np

# 创建示例数据

data = {

'website': ['pandasdataframe.com'] * 6,

'category': ['A', 'A', 'A', 'B', 'B', 'B'],

'value': [10, 20, 30, 40, 50, 60],

'weight': [1, 2, 3, 4, 5, 6]

}

df = pd.DataFrame(data)

# 定义加权平均函数

def weighted_average(group):

return np.average(group['value'], weights=group['weight'])

# 使用transform方法进行GroupBy加权平均

df['weighted_avg'] = df.groupby('category').transform(weighted_average)

print(df)

在这个例子中,我们使用transform方法计算了每个类别的加权平均,并将结果添加为DataFrame的一个新列。这种方法的优点是它保留了原始的数据结构,同时为每一行添加了相应组的加权平均值。

9. 处理大型数据集的GroupBy加权平均

当处理大型数据集时,内存使用和计算效率变得尤为重要。虽然Pandas在处理中等大小的数据集时表现良好,但对于非常大的数据集,我们可能需要采用一些优化策略。

以下是一个处理大型数据集的例子,我们使用分块处理的方法:

import pandas as pd

import numpy as np

# 假设我们有一个非常大的CSV文件

filename = 'pandasdataframe_large_dataset.csv'

# 定义加权平均函数

def weighted_average(group):

return np.average(group['value'], weights=group['weight'])

# 使用分块读取和处理数据

chunk_size = 10000 # 根据可用内存调整这个值

results = []

for chunk in pd.read_csv(filename, chunksize=chunk_size):

# 对每个分块进行GroupBy加权平均计算

chunk_result = chunk.groupby('category').apply(weighted_average)

results.append(chunk_result)

# 合并所有分块的结果

final_result = pd.concat(results).groupby(level=0).mean()

print(final_result)

在这个例子中,我们假设有一个非常大的CSV文件。我们使用Pandas的read_csv函数的chunksize参数来分块读取数据。对每个分块,我们计算GroupBy加权平均,然后将结果存储在一个列表中。最后,我们将所有分块的结果合并,并计算最终的平均值。

这种方法允许我们处理超出内存容量的大型数据集,同时仍然能够执行复杂的GroupBy加权平均计算。

10. 使用rolling和expanding窗口的加权平均

除了静态的GroupBy加权平均,Pandas还提供了动态窗口计算的功能,如滚动窗口(rolling)和扩展窗口(expanding)。这些功能在时间序列分析中特别有用。

以下是一个使用滚动窗口计算加权平均的例子:

import pandas as pd

import numpy as np

# 创建时间序列数据

dates = pd.date_range('2023-01-01', periods=10)

data = {

'website': ['pandasdataframe.com'] * 10,

'value': np.random.rand(10) * 100,

'weight': np.random.rand(10)

}

df = pd.DataFrame(data, index=dates)

# 定义加权平均函数

def weighted_average(group):

return np.average(group['value'], weights=group['weight'])

# 使用3天的滚动窗口计算加权平均

df['rolling_weighted_avg'] = df.rolling(window=3).apply(weighted_average)

print(df)

在这个例子中,我们创建了一个时间序列数据集,然后使用3天的滚动窗口计算加权平均。rolling方法创建了一个滚动窗口对象,我们可以在这个对象上应用自定义的加权平均函数。这种方法可以帮助我们观察数据的短期趋势和变化。

11. 使用自定义聚合函数

有时,内置的聚合函数可能无法满足我们的特定需求。在这种情况下,我们可以定义自己的聚合函数,并在GroupBy操作中使用它。以下是一个例子,展示如何创建和使用自定义的加权中位数函数:

import pandas as pd

import numpy as np

# 创建示例数据

data = {

'website': ['pandasdataframe.com'] * 8,

'category': ['A', 'A', 'A', 'A', 'B', 'B', 'B', 'B'],

'value': [10, 20, 30, 40, 50, 60, 70, 80],

'weight': [1, 2, 3, 4, 5, 6, 7, 8]

}

df = pd.DataFrame(data)

# 定义加权中位数函数

def weighted_median(group):

sorted_data = group.sort_values('value')

cumsum = sorted_data['weight'].cumsum()

cutoff = sorted_data['weight'].sum() / 2

return sorted_data['value'][cumsum >= cutoff].iloc[0]

# 使用自定义函数进行GroupBy操作

result = df.groupby('category').apply(weighted_median)

print(result)

在这个例子中,我们定义了一个weighted_median函数来计算加权中位数。这个函数首先按值排序数据,然后计算权重的累积和,最后找到超过总权重一半的第一个值作为加权中位数。通过使用apply方法,我们可以将这个自定义函数应用到GroupBy对象上。

12. 处理多列加权平均

在某些情况下,我们可能需要同时计算多个列的加权平均。Pandas提供了灵活的方法来处理这种情况。以下是一个例子:

import pandas as pd

import numpy as np

# 创建示例数据

data = {

'website': ['pandasdataframe.com'] * 6,

'category': ['A', 'A', 'A', 'B', 'B', 'B'],

'value1': [10, 20, 30, 40, 50, 60],

'value2': [15, 25, 35, 45, 55, 65],

'weight': [1, 2, 3, 4, 5, 6]

}

df = pd.DataFrame(data)

# 定义多列加权平均函数

def multi_weighted_average(group):

weights = group['weight']

return pd.Series({

'weighted_avg1': np.average(group['value1'], weights=weights),

'weighted_avg2': np.average(group['value2'], weights=weights)

})

# 使用自定义函数进行GroupBy操作

result = df.groupby('category').apply(multi_weighted_average)

print(result)

在这个例子中,我们定义了一个multi_weighted_average函数,它同时计算两个值列的加权平均。这个函数返回一个包含两个加权平均结果的Series。通过使用apply方法,我们可以将这个函数应用到GroupBy对象上,得到每个类别的多列加权平均结果。

13. 使用分类数据进行GroupBy加权平均

Pandas的分类数据类型可以提高内存效率和计算速度,特别是在处理具有有限且已知的唯一值集合的列时。以下是一个使用分类数据进行GroupBy加权平均的例子:

import pandas as pd

import numpy as np

# 创建示例数据

data = {

'website': ['pandasdataframe.com'] * 1000,

'category': np.random.choice(['A', 'B', 'C', 'D'], 1000),

'value': np.random.rand(1000) * 100,

'weight': np.random.rand(1000)

}

df = pd.DataFrame(data)

# 将category列转换为分类类型

df['category'] = df['category'].astype('category')

# 定义加权平均函数

def weighted_average(group):

return np.average(group['value'], weights=group['weight'])

# 使用分类数据进行GroupBy加权平均

result = df.groupby('category').apply(weighted_average)

print(result)

在这个例子中,我们首先创建了一个包含1000行的DataFrame,其中’category’列有4个唯一值。然后,我们将’category’列转换为分类类型。这种转换可以显著减少内存使用,特别是在处理大型数据集时。最后,我们使用这个分类列进行GroupBy加权平均计算。

14. 使用MultiIndex进行复杂的GroupBy加权平均

在某些情况下,我们可能需要处理具有多级索引的DataFrame,并在多个级别上进行GroupBy加权平均计算。以下是一个例子:

import pandas as pd

import numpy as np

# 创建多级索引的示例数据

index = pd.MultiIndex.from_product([['A', 'B'], ['X', 'Y', 'Z'], [1, 2]],

names=['category', 'subcategory', 'id'])

data = {

'website': ['pandasdataframe.com'] * 12,

'value': np.random.rand(12) * 100,

'weight': np.random.rand(12)

}

df = pd.DataFrame(data, index=index)

# 定义加权平均函数

def weighted_average(group):

return np.average(group['value'], weights=group['weight'])

# 在不同级别上进行GroupBy加权平均

result_level0 = df.groupby(level=0).apply(weighted_average)

result_level01 = df.groupby(level=[0, 1]).apply(weighted_average)

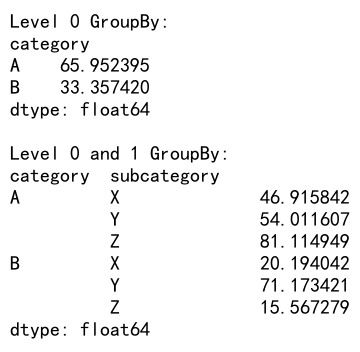

print("Level 0 GroupBy:")

print(result_level0)

print("\nLevel 0 and 1 GroupBy:")

print(result_level01)

Output:

在这个例子中,我们创建了一个具有三级索引的DataFrame。然后,我们展示了如何在不同的索引级别上进行GroupBy加权平均计算。首先,我们只按第一级(’category’)进行分组,然后我们按前两级(’category’和’subcategory’)进行分组。这种方法允许我们在不同的粒度级别上分析数据。

15. 使用query方法进行条件GroupBy加权平均

Pandas的query方法提供了一种简洁的方式来过滤DataFrame。我们可以将它与GroupBy加权平均结合使用,以执行条件分组计算。以下是一个例子:

import pandas as pd

import numpy as np

# 创建示例数据

data = {

'website': ['pandasdataframe.com'] * 1000,

'category': np.random.choice(['A', 'B', 'C', 'D'], 1000),

'value': np.random.rand(1000) * 100,

'weight': np.random.rand(1000)

}

df = pd.DataFrame(data)

# 定义加权平均函数

def weighted_average(group):

return np.average(group['value'], weights=group['weight'])

# 使用query方法过滤数据,然后进行GroupBy加权平均

result = df.query('value > 50').groupby('category').apply(weighted_average)

print(result)

在这个例子中,我们首先使用query方法过滤出’value’大于50的行,然后对过滤后的数据进行GroupBy加权平均计算。这种方法允许我们在进行分组计算之前应用复杂的过滤条件,从而更灵活地分析数据。

16. 使用pipe方法进行链式操作

Pandas的pipe方法允许我们以一种更加可读和可维护的方式链接多个操作。这在进行复杂的数据处理和分析时特别有用。以下是一个使用pipe方法进行GroupBy加权平均的例子:

import pandas as pd

import numpy as np

# 创建示例数据

data = {

'website': ['pandasdataframe.com'] * 1000,

'category': np.random.choice(['A', 'B', 'C', 'D'], 1000),

'value': np.random.rand(1000) * 100,

'weight': np.random.rand(1000)

}

df = pd.DataFrame(data)

# 定义数据处理函数

def preprocess(df):

return df[df['value'] > df['value'].mean()]

def group_and_weight(df, group_col, value_col, weight_col):

return df.groupby(group_col).apply(lambda x: np.average(x[value_col], weights=x[weight_col]))

# 使用pipe方法进行链式操作

result = (df

.pipe(preprocess)

.pipe(group_and_weight, 'category', 'value', 'weight'))

print(result)

在这个例子中,我们定义了两个函数:preprocess用于数据预处理,group_and_weight用于执行GroupBy加权平均。然后,我们使用pipe方法将这些操作链接起来。这种方法使得代码更加模块化和易于理解,特别是在处理复杂的数据分析流程时。

17. 处理时间序列数据的GroupBy加权平均

在处理时间序列数据时,我们经常需要按时间间隔进行分组并计算加权平均。Pandas提供了强大的时间序列功能,可以很容易地实现这一点。以下是一个例子:

import pandas as pd

import numpy as np

# 创建时间序列数据

dates = pd.date_range('2023-01-01', periods=1000, freq='H')

data = {

'website': ['pandasdataframe.com'] * 1000,

'value': np.random.rand(1000) * 100,

'weight': np.random.rand(1000)

}

df = pd.DataFrame(data, index=dates)

# 定义加权平均函数

def weighted_average(group):

return np.average(group['value'], weights=group['weight'])

# 按天进行GroupBy加权平均

result = df.groupby(df.index.date).apply(weighted_average)

print(result)

在这个例子中,我们创建了一个包含1000个小时数据点的时间序列DataFrame。然后,我们使用groupby方法按天进行分组,并计算每天的加权平均值。这种方法在分析日常、周度或月度趋势时非常有用。

18. 使用numba加速GroupBy加权平均计算

对于大型数据集,GroupBy加权平均的计算可能会变得很慢。在这种情况下,我们可以使用numba库来加速计算。Numba是一个即时编译器,可以将Python函数编译成机器代码,从而显著提高性能。以下是一个使用numba加速GroupBy加权平均计算的例子:

import pandas as pd

import numpy as np

from numba import jit

# 创建大型示例数据

data = {

'website': ['pandasdataframe.com'] * 1000000,

'category': np.random.choice(['A', 'B', 'C', 'D'], 1000000),

'value': np.random.rand(1000000) * 100,

'weight': np.random.rand(1000000)

}

df = pd.DataFrame(data)

# 使用numba定义加速的加权平均函数

@jit(nopython=True)

def fast_weighted_average(values, weights):

return np.sum(values * weights) / np.sum(weights)

# 使用加速函数进行GroupBy加权平均

result = df.groupby('category').apply(lambda x: fast_weighted_average(x['value'].values, x['weight'].values))

print(result)

在这个例子中,我们使用@jit装饰器来编译fast_weighted_average函数。这个函数接受NumPy数组作为输入,这样可以避免Pandas数据结构的开销。然后,我们在GroupBy操作中使用这个编译后的函数。对于大型数据集,这种方法可以显著提高计算速度。

结论

本文详细介绍了Pandas中GroupBy加权平均的概念、实现方法以及实际应用场景。我们探讨了从基本的GroupBy操作到复杂的多级索引和时间序列分析,以及如何处理大型数据集和提高计算效率。通过掌握这些技巧,数据分析师和科学家可以更有效地处理和分析复杂的数据集,从而得出更深入的洞察。

GroupBy加权平均是一个强大的工具,它允许我们考虑数据点的相对重要性,从而得到更准确和有意义的结果。无论是在金融分析、市场研究、还是科学实验中,这种技术都有广泛的应用。

随着数据规模的不断增长和分析需求的日益复杂,掌握高效的数据处理技巧变得越来越重要。Pandas提供的灵活性和强大功能,结合如numba等性能优化工具,使得我们能够应对各种数据分析挑战。

通过不断实践和探索,我们可以进一步提高使用Pandas进行数据分析的技能,为决策制定提供更有价值的支持。希望本文能为读者在使用Pandas进行GroupBy加权平均计算时提供有用的指导和启发。

极客笔记

极客笔记