Pandas GroupBy 和 Mean 操作:数据分组与均值计算详解

Pandas是Python中强大的数据处理库,其中GroupBy和Mean操作是进行数据分析时常用的功能。本文将深入探讨如何使用Pandas的GroupBy功能对数据进行分组,然后使用Mean方法计算均值,以及这些操作在实际应用中的各种场景和技巧。

1. GroupBy基础

GroupBy操作允许我们将数据按照一个或多个列进行分组,这是数据分析中的一个关键步骤。

1.1 单列分组

import pandas as pd

# 创建示例数据框

df = pd.DataFrame({

'name': ['Alice', 'Bob', 'Charlie', 'Alice', 'Bob'],

'age': [25, 30, 35, 25, 31],

'score': [85, 92, 78, 88, 95]

})

# 按name列分组并计算平均分数

result = df.groupby('name')['score'].mean()

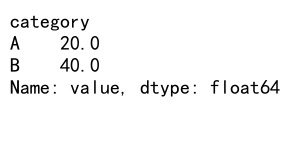

print(result)

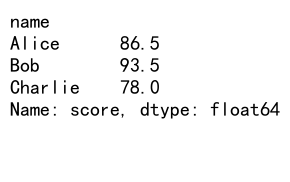

Output:

在这个例子中,我们首先创建了一个包含姓名、年龄和分数的数据框。然后,我们使用groupby('name')按姓名分组,并计算每个人的平均分数。这个操作会返回一个Series,其中索引是不同的姓名,值是对应的平均分数。

1.2 多列分组

import pandas as pd

# 创建示例数据框

df = pd.DataFrame({

'category': ['A', 'B', 'A', 'B', 'A'],

'subcategory': ['X', 'X', 'Y', 'Y', 'X'],

'value': [10, 20, 30, 40, 50]

})

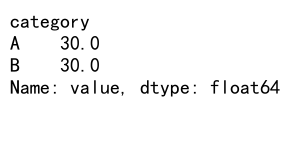

# 按多列分组并计算平均值

result = df.groupby(['category', 'subcategory'])['value'].mean()

print(result)

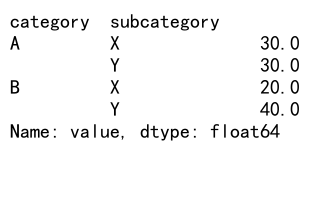

Output:

这个例子展示了如何按多个列进行分组。我们按’category’和’subcategory’两列进行分组,然后计算每个组合的平均值。结果是一个多级索引的Series。

2. Mean操作详解

Mean操作用于计算数值的平均值,是数据分析中常用的统计方法之一。

2.1 基本使用

import pandas as pd

# 创建示例数据框

df = pd.DataFrame({

'A': [1, 2, 3, 4, 5],

'B': [10, 20, 30, 40, 50],

'C': ['pandasdataframe.com', 'example', 'test', 'data', 'frame']

})

# 计算数值列的平均值

mean_values = df.mean()

print(mean_values)

这个例子展示了如何使用mean()方法计算数据框中所有数值列的平均值。注意,非数值列(如字符串列)会被自动忽略。

2.2 指定轴计算均值

import pandas as pd

# 创建示例数据框

df = pd.DataFrame({

'A': [1, 2, 3],

'B': [4, 5, 6],

'C': [7, 8, 9]

})

# 计算每行的平均值

row_means = df.mean(axis=1)

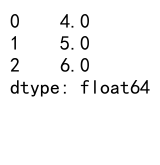

print(row_means)

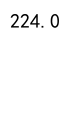

Output:

通过指定axis=1,我们可以计算每行的平均值,而不是每列的平均值。

3. GroupBy和Mean结合使用

将GroupBy和Mean操作结合使用是数据分析中的常见模式,可以帮助我们快速获取分组数据的平均值。

3.1 基本用法

import pandas as pd

# 创建示例数据框

df = pd.DataFrame({

'category': ['A', 'B', 'A', 'B', 'A'],

'value1': [10, 20, 30, 40, 50],

'value2': [100, 200, 300, 400, 500]

})

# 按category分组并计算平均值

result = df.groupby('category').mean()

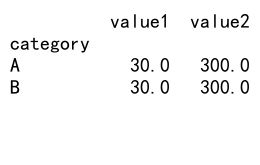

print(result)

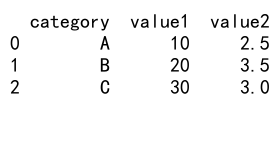

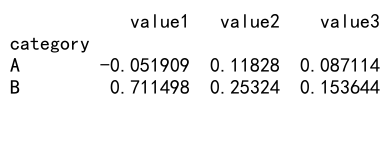

Output:

这个例子展示了如何按’category’列分组,然后计算每个分组中’value1’和’value2’列的平均值。

3.2 选择特定列计算均值

import pandas as pd

# 创建示例数据框

df = pd.DataFrame({

'category': ['A', 'B', 'A', 'B', 'A'],

'value1': [10, 20, 30, 40, 50],

'value2': [100, 200, 300, 400, 500],

'text': ['pandasdataframe.com', 'example', 'test', 'data', 'frame']

})

# 按category分组并只计算value1的平均值

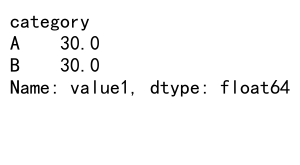

result = df.groupby('category')['value1'].mean()

print(result)

Output:

这个例子展示了如何在分组后只计算特定列的平均值。我们只计算了’value1’列的平均值,忽略了其他列。

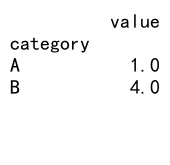

4. 高级GroupBy和Mean技巧

4.1 使用自定义函数

import pandas as pd

# 创建示例数据框

df = pd.DataFrame({

'category': ['A', 'B', 'A', 'B', 'A'],

'value': [10, 20, 30, 40, 50]

})

# 定义自定义函数

def custom_mean(x):

return x.mean() if x.mean() > 25 else 0

# 使用自定义函数进行分组计算

result = df.groupby('category')['value'].agg(custom_mean)

print(result)

Output:

这个例子展示了如何使用自定义函数进行分组计算。我们定义了一个函数,只有当平均值大于25时才返回平均值,否则返回0。

4.2 多列分组和多函数应用

import pandas as pd

# 创建示例数据框

df = pd.DataFrame({

'category1': ['A', 'B', 'A', 'B', 'A'],

'category2': ['X', 'X', 'Y', 'Y', 'X'],

'value': [10, 20, 30, 40, 50]

})

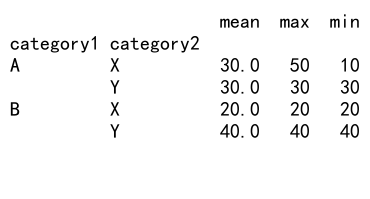

# 多列分组和多函数应用

result = df.groupby(['category1', 'category2'])['value'].agg(['mean', 'max', 'min'])

print(result)

Output:

这个例子展示了如何按多个列进行分组,并同时应用多个聚合函数。我们计算了每个组合的平均值、最大值和最小值。

4.3 处理缺失值

import pandas as pd

import numpy as np

# 创建包含缺失值的示例数据框

df = pd.DataFrame({

'category': ['A', 'B', 'A', 'B', 'A'],

'value': [10, np.nan, 30, 40, 50]

})

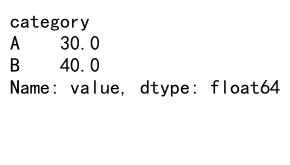

# 忽略缺失值计算平均值

result = df.groupby('category')['value'].mean()

print(result)

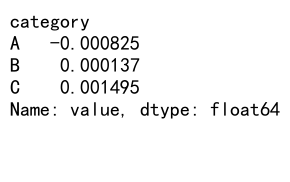

Output:

这个例子展示了如何处理包含缺失值的数据。默认情况下,mean()方法会忽略缺失值(NaN)进行计算。

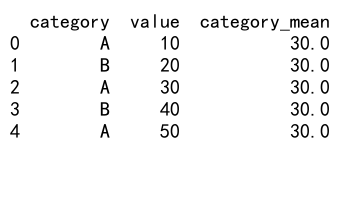

4.4 使用transform方法

import pandas as pd

# 创建示例数据框

df = pd.DataFrame({

'category': ['A', 'B', 'A', 'B', 'A'],

'value': [10, 20, 30, 40, 50]

})

# 使用transform计算每个类别的平均值

df['category_mean'] = df.groupby('category')['value'].transform('mean')

print(df)

Output:

transform方法允许我们将聚合结果广播回原始数据框的形状。这个例子展示了如何为每个类别计算平均值,并将结果添加为新列。

5. 实际应用场景

5.1 销售数据分析

import pandas as pd

# 创建销售数据示例

sales_data = pd.DataFrame({

'date': pd.date_range(start='2023-01-01', periods=100),

'product': ['A', 'B', 'C'] * 33 + ['A'],

'sales': np.random.randint(100, 1000, 100),

'region': ['North', 'South', 'East', 'West'] * 25

})

# 按产品和地区分组计算平均销售额

avg_sales = sales_data.groupby(['product', 'region'])['sales'].mean()

print(avg_sales)

这个例子模拟了一个销售数据分析场景。我们按产品和地区分组,计算每种组合的平均销售额。这种分析可以帮助识别不同产品在不同地区的表现。

5.2 时间序列数据分析

import pandas as pd

# 创建时间序列数据示例

time_series_data = pd.DataFrame({

'date': pd.date_range(start='2023-01-01', periods=365),

'value': np.random.randn(365)

})

# 按月份分组计算平均值

monthly_avg = time_series_data.groupby(time_series_data['date'].dt.month)['value'].mean()

print(monthly_avg)

这个例子展示了如何处理时间序列数据。我们按月份分组,计算每个月的平均值。这种分析对于识别季节性趋势非常有用。

5.3 学生成绩分析

import pandas as pd

# 创建学生成绩数据示例

student_data = pd.DataFrame({

'student_id': range(1, 101),

'class': ['A', 'B', 'C'] * 33 + ['A'],

'subject': ['Math', 'Science', 'English'] * 33 + ['Math'],

'score': np.random.randint(60, 100, 100)

})

# 按班级和科目分组计算平均分

class_subject_avg = student_data.groupby(['class', 'subject'])['score'].mean()

print(class_subject_avg)

这个例子模拟了学生成绩分析。我们按班级和科目分组,计算每个组合的平均分数。这种分析可以帮助教育工作者了解不同班级在不同科目上的整体表现。

6. 性能优化技巧

6.1 使用分类数据类型

import pandas as pd

# 创建大型数据集

df = pd.DataFrame({

'category': ['A', 'B', 'C'] * 1000000,

'value': np.random.randn(3000000)

})

# 将category列转换为分类类型

df['category'] = df['category'].astype('category')

# 分组计算平均值

result = df.groupby('category')['value'].mean()

print(result)

对于大型数据集,将分组列转换为分类类型可以显著提高性能。这个例子展示了如何使用分类数据类型进行优化。

6.2 使用numba加速

import pandas as pd

import numpy as np

from numba import jit

@jit(nopython=True)

def fast_mean(values):

return np.mean(values)

# 创建示例数据

df = pd.DataFrame({

'category': ['A', 'B', 'C'] * 1000000,

'value': np.random.randn(3000000)

})

# 使用numba加速的函数进行分组计算

result = df.groupby('category')['value'].agg(fast_mean)

print(result)

对于计算密集型操作,可以使用numba库进行加速。这个例子展示了如何使用numba加速均值计算。

7. 处理复杂数据结构

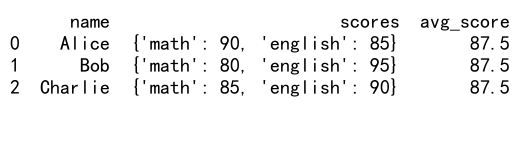

7.1 处理嵌套数据

import pandas as pd

# 创建包含嵌套数据的DataFrame

df = pd.DataFrame({

'name': ['Alice', 'Bob', 'Charlie'],

'scores': [{'math': 90, 'english': 85}, {'math': 80, 'english': 95}, {'math': 85, 'english': 90}]

})

# 提取嵌套数据并计算平均值

df['avg_score'] = df['scores'].apply(lambda x: pd.Series(x).mean())

print(df)

Output:

这个例子展示了如何处理包含嵌套字典的数据框。我们使用apply方法和lambda函数来计算每个学生的平均分数。

7.2 处理多级索引

import pandas as pd

# 创建多级索引的DataFrame

index = pd.MultiIndex.from_product([['A', 'B'], ['X', 'Y', 'Z']], names=['category', 'subcategory'])

df = pd.DataFrame({'value': range(6)}, index=index)

# 按第一级索引分组并计算平均值

result = df.groupby(level='category').mean()

print(result)

Output:

这个例子展示了如何处理具有多级索引的数据框。我们按第一级索引(category)分组并计算平均值。

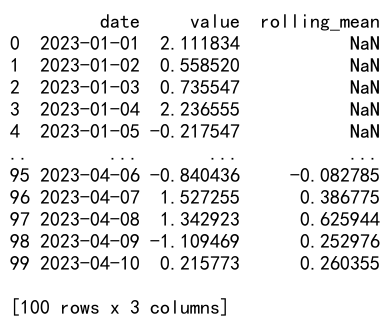

8. 高级数据分析技巧

8.1 滚动平均

import pandas as pd

import numpy as np

# 创建时间序列数据

dates = pd.date_range(start='2023-01-01', periods=100)

df = pd.DataFrame({'date': dates, 'value': np.random.randn(100)})

# 计算7天滚动平均

df['rolling_mean'] = df['value'].rolling(window=7).mean()

print(df)

Output:

这个例子展示了如何计算滚动平均。我们使用rolling方法来计算7天的滚动平均值,这在时间序列分析中非常有用。

8.2 分组累积统计

import pandas as pd

# 创建示例数据

df = pd.DataFrame({

'category': ['A', 'B', 'A', 'B', 'A', 'B'],

'value': [10, 20, 30, 40, 50, 60]

})

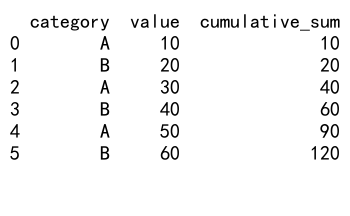

# 计算每个类别的累积和

df['cumulative_sum'] = df.groupby('category')['value'].cumsum()

print(df)

Output:

这个例子展示了如何计算分组累积统计。我们使用cumsum方法计算每个类别内的累积和,这对于跟踪随时间变化的趋势很有用。

8.3 分组排序

import pandas as pd

# 创建示例数据

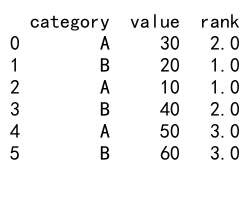

df = pd.DataFrame({

'category': ['A', 'B', 'A', 'B', 'A', 'B'],

'value': [30, 20, 10, 40, 50, 60]

})

# 在每个类别内按值排序

df['rank'] = df.groupby('category')['value'].rank(method='dense')

print(df)

Output:

这个例子展示了如何在每个分组内进行排序。我们使用rank方法为每个类别内的值分配排名,这对于识别每个类别中的top N项很有用。

9. 数据可视化

虽然本文主要关注Pandas的GroupBy和Mean操作,但将这些操作的结果可视化也是数据分析中的重要步骤。

9.1 使用Matplotlib绘制分组均值

import pandas as pd

import matplotlib.pyplot as plt

# 创建示例数据

df = pd.DataFrame({

'category': ['A', 'B', 'C'] * 10,

'value': np.random.randint(1, 100, 30)

})

# 计算每个类别的平均值

mean_values = df.groupby('category')['value'].mean()

# 绘制条形图

plt.figure(figsize=(10, 6))

mean_values.plot(kind='bar')

plt.title('Average Values by Category')

plt.xlabel('Category')

plt.ylabel('Average Value')

plt.savefig('pandasdataframe.com_groupby_mean.png')

plt.close()

这个例子展示了如何使用Matplotlib将GroupBy和Mean操作的结果可视化。我们创建了一个条形图来显示每个类别的平均值。

9.2 使用Seaborn进行高级可视化

import pandas as pd

import seaborn as sns

import matplotlib.pyplot as plt

# 创建示例数据

df = pd.DataFrame({

'category': ['A', 'B', 'C'] * 30,

'subcategory': ['X', 'Y', 'Z'] * 30,

'value': np.random.randint(1, 100, 90)

})

# 使用Seaborn创建箱线图

plt.figure(figsize=(12, 6))

sns.boxplot(x='category', y='value', hue='subcategory', data=df)

plt.title('Value Distribution by Category and Subcategory')

plt.savefig('pandasdataframe.com_groupby_boxplot.png')

plt.close()

这个例子展示了如何使用Seaborn创建更复杂的可视化。我们创建了一个箱线图,显示了不同类别和子类别的值分布。

10. 处理大规模数据

当处理大规模数据时,内存管理和性能优化变得尤为重要。以下是一些处理大规模数据时的技巧:

10.1 使用分块处理

import pandas as pd

# 假设我们有一个大文件 'large_file.csv'

chunk_size = 10000

result = pd.DataFrame()

for chunk in pd.read_csv('large_file.csv', chunksize=chunk_size):

# 对每个分块进行处理

chunk_result = chunk.groupby('category')['value'].mean()

result = pd.concat([result, chunk_result])

# 合并所有分块的结果

final_result = result.groupby(level=0).mean()

print(final_result)

这个例子展示了如何使用分块处理来处理大型CSV文件。我们逐块读取文件,对每个块进行GroupBy和Mean操作,然后合并结果。

10.2 使用Dask进行并行处理

import dask.dataframe as dd

# 读取大型CSV文件

ddf = dd.read_csv('large_file.csv')

# 进行GroupBy和Mean操作

result = ddf.groupby('category')['value'].mean().compute()

print(result)

这个例子展示了如何使用Dask库来处理大规模数据。Dask提供了与Pandas类似的API,但可以处理超出内存大小的数据集,并支持并行计算。

11. 高级GroupBy技巧

11.1 使用自定义聚合函数

import pandas as pd

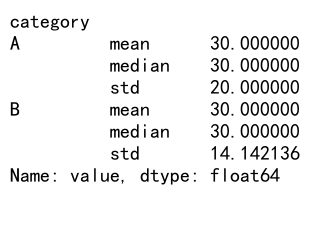

def custom_agg(x):

return pd.Series({

'mean': x.mean(),

'median': x.median(),

'std': x.std()

})

# 创建示例数据

df = pd.DataFrame({

'category': ['A', 'B', 'A', 'B', 'A'],

'value': [10, 20, 30, 40, 50]

})

# 使用自定义聚合函数

result = df.groupby('category')['value'].apply(custom_agg)

print(result)

Output:

这个例子展示了如何创建和使用自定义聚合函数。我们定义了一个函数,同时计算平均值、中位数和标准差。

11.2 使用多列聚合

import pandas as pd

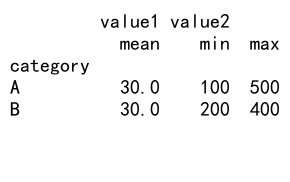

# 创建示例数据

df = pd.DataFrame({

'category': ['A', 'B', 'A', 'B', 'A'],

'value1': [10, 20, 30, 40, 50],

'value2': [100, 200, 300, 400, 500]

})

# 对不同列应用不同的聚合函数

result = df.groupby('category').agg({

'value1': 'mean',

'value2': ['min', 'max']

})

print(result)

Output:

这个例子展示了如何对不同的列应用不同的聚合函数。我们对’value1’列计算平均值,对’value2’列计算最小值和最大值。

12. 处理时间序列数据

Pandas在处理时间序列数据方面非常强大,特别是在与GroupBy和Mean操作结合使用时。

12.1 按时间间隔重采样

import pandas as pd

# 创建时间序列数据

dates = pd.date_range('2023-01-01', periods=100, freq='D')

df = pd.DataFrame({'date': dates, 'value': np.random.randn(100)})

df.set_index('date', inplace=True)

# 按周重采样并计算平均值

weekly_mean = df.resample('W').mean()

print(weekly_mean)

这个例子展示了如何使用resample方法按周重采样时间序列数据,并计算每周的平均值。

12.2 滚动窗口计算

import pandas as pd

# 创建时间序列数据

dates = pd.date_range('2023-01-01', periods=100, freq='D')

df = pd.DataFrame({'date': dates, 'value': np.random.randn(100)})

df.set_index('date', inplace=True)

# 计算30天滚动平均

rolling_mean = df.rolling(window='30D').mean()

print(rolling_mean)

这个例子展示了如何使用rolling方法计算30天的滚动平均值。这对于平滑时间序列数据和识别长期趋势非常有用。

13. 处理分类数据

在进行GroupBy和Mean操作时,处理分类数据需要特别注意。

13.1 使用分类数据类型

import pandas as pd

# 创建包含分类数据的DataFrame

df = pd.DataFrame({

'category': pd.Categorical(['A', 'B', 'C', 'A', 'B']),

'value': [10, 20, 30, 40, 50]

})

# 按分类进行分组和计算平均值

result = df.groupby('category')['value'].mean()

print(result)

这个例子展示了如何使用Pandas的分类数据类型。使用分类数据类型可以提高内存效率和计算速度,特别是对于大型数据集。

13.2 处理有序分类

import pandas as pd

# 创建有序分类数据

df = pd.DataFrame({

'grade': pd.Categorical(['A', 'B', 'C', 'A', 'B'], categories=['C', 'B', 'A'], ordered=True),

'score': [85, 92, 78, 88, 95]

})

# 按有序分类进行分组和计算平均值

result = df.groupby('grade')['score'].mean().sort_index()

print(result)

这个例子展示了如何处理有序分类数据。我们创建了一个有序的成绩分类,然后按这个分类进行分组和排序。

14. 高级数据清洗技巧

在进行GroupBy和Mean操作之前,通常需要对数据进行清洗和预处理。

14.1 处理缺失值

import pandas as pd

import numpy as np

# 创建包含缺失值的DataFrame

df = pd.DataFrame({

'category': ['A', 'B', 'A', 'B', 'A'],

'value': [10, np.nan, 30, 40, np.nan]

})

# 填充缺失值后进行分组和平均值计算

df['value'] = df['value'].fillna(df.groupby('category')['value'].transform('mean'))

result = df.groupby('category')['value'].mean()

print(result)

Output:

这个例子展示了如何在进行GroupBy和Mean操作之前处理缺失值。我们使用每个类别的平均值来填充缺失值。

14.2 处理异常值

import pandas as pd

import numpy as np

# 创建包含异常值的DataFrame

df = pd.DataFrame({

'category': ['A', 'B', 'A', 'B', 'A'],

'value': [10, 20, 1000, 40, 50]

})

# 使用Z-score方法识别和处理异常值

def remove_outliers(group):

z_scores = np.abs((group - group.mean()) / group.std())

return group[z_scores < 3]

result = df.groupby('category')['value'].apply(remove_outliers).mean()

print(result)

Output:

这个例子展示了如何在进行GroupBy和Mean操作之前处理异常值。我们使用Z-score方法来识别和移除异常值。

15. 结合其他Pandas功能

GroupBy和Mean操作可以与其他Pandas功能结合使用,以进行更复杂的数据分析。

15.1 结合merge操作

import pandas as pd

# 创建两个DataFrame

df1 = pd.DataFrame({

'category': ['A', 'B', 'C'],

'value1': [10, 20, 30]

})

df2 = pd.DataFrame({

'category': ['A', 'B', 'C', 'A', 'B'],

'value2': [1, 2, 3, 4, 5]

})

# 计算df2中每个类别的平均值

df2_mean = df2.groupby('category')['value2'].mean().reset_index()

# 将结果与df1合并

result = pd.merge(df1, df2_mean, on='category')

print(result)

Output:

这个例子展示了如何将GroupBy和Mean操作的结果与另一个DataFrame合并。我们首先计算df2中每个类别的平均值,然后将结果与df1合并。

15.2 结合pivot操作

import pandas as pd

# 创建示例数据

df = pd.DataFrame({

'date': pd.date_range('2023-01-01', periods=12),

'category': ['A', 'B', 'C'] * 4,

'value': np.random.randint(1, 100, 12)

})

# 使用pivot_table进行分组和平均值计算

result = pd.pivot_table(df, values='value', index='date', columns='category', aggfunc='mean')

print(result)

这个例子展示了如何使用pivot_table函数来同时进行分组、平均值计算和数据重塑。我们创建了一个以日期为索引、类别为列的表格,显示每个日期每个类别的平均值。

16. 性能优化和最佳实践

在处理大型数据集时,优化GroupBy和Mean操作的性能变得尤为重要。以下是一些性能优化技巧和最佳实践:

16.1 使用索引进行分组

import pandas as pd

import numpy as np

# 创建大型DataFrame

df = pd.DataFrame({

'category': np.random.choice(['A', 'B', 'C'], 1000000),

'value': np.random.randn(1000000)

})

# 设置category为索引

df.set_index('category', inplace=True)

# 使用索引进行分组和平均值计算

result = df.groupby(level=0)['value'].mean()

print(result)

Output:

使用索引进行分组通常比使用列进行分组更快,特别是对于大型数据集。

16.2 使用Categoricals

“`pythonimport pandas as pd

import numpy as np

<h1>创建大型DataFrame</h1>

df = pd.DataFrame({

'category': np.random.choice(['A', 'B', 'C'], 1000000),

'value': np.random.randn(1000000)

})

<h1>将category列转换为Categorical类型</h1>

df['category'] = pd.Categorical(df['category'])

<h1>进行分组和平均值计算</h1>

result = df.groupby('category')['value'].mean()

print(result)

<pre><code class="line-numbers">将分组列转换为Categorical类型可以显著提高GroupBy操作的性能,特别是当分组的唯一值数量相对较少时。

### 16.3 使用numba加速自定义函数

“`python

import pandas as pd

import numpy as np

from numba import jit

@jit(nopython=True)

def fast_mean(values):

return np.mean(values)

# 创建示例数据

df = pd.DataFrame({

‘category’: np.random.choice([‘A’, ‘B’, ‘C’], 1000000),

‘value’: np.random.randn(1000000)

})

# 使用numba加速的函数进行分组计算

result = df.groupby(‘category’)[‘value’].agg(fast_mean)

print(result)

对于复杂的自定义聚合函数,使用numba进行即时编译可以显著提高性能。

17. 处理多维数据

GroupBy和Mean操作不仅限于二维数据,也可以应用于多维数据。

17.1 处理Panel数据

import pandas as pd

import numpy as np

# 创建一个简单的Panel数据结构

panel = pd.Panel({

'Item1': pd.DataFrame(np.random.randn(4, 3), columns=['A', 'B', 'C']),

'Item2': pd.DataFrame(np.random.randn(4, 3), columns=['A', 'B', 'C'])

})

# 对Panel数据进行GroupBy和Mean操作

result = panel.mean(axis='items')

print(result)

这个例子展示了如何对Panel数据(三维数据结构)进行平均值计算。注意,从Pandas 0.25.0版本开始,Panel已被弃用,建议使用MultiIndex DataFrame代替。

17.2 使用MultiIndex DataFrame

import pandas as pd

import numpy as np

# 创建MultiIndex DataFrame

index = pd.MultiIndex.from_product([['A', 'B'], ['X', 'Y', 'Z']], names=['category', 'subcategory'])

df = pd.DataFrame(np.random.randn(6, 3), index=index, columns=['value1', 'value2', 'value3'])

# 按第一级索引分组并计算平均值

result = df.groupby(level='category').mean()

print(result)

Output:

这个例子展示了如何使用MultiIndex DataFrame来处理多维数据,并进行分组和平均值计算。

18. 高级数据分析应用

GroupBy和Mean操作在高级数据分析中有广泛的应用。以下是一些实际应用场景:

18.1 金融数据分析

import pandas as pd

import numpy as np

# 创建模拟的股票数据

dates = pd.date_range('2023-01-01', periods=100)

stocks = ['AAPL', 'GOOGL', 'MSFT', 'AMZN']

df = pd.DataFrame({

'date': np.repeat(dates, len(stocks)),

'stock': stocks * 100,

'price': np.random.randint(100, 200, 400),

'volume': np.random.randint(1000000, 5000000, 400)

})

# 计算每只股票的平均价格和总交易量

result = df.groupby('stock').agg({

'price': 'mean',

'volume': 'sum'

})

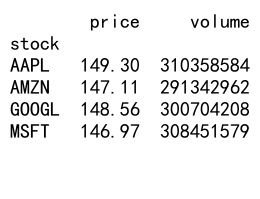

print(result)

Output:

这个例子展示了如何使用GroupBy和Mean操作分析股票数据,计算每只股票的平均价格和总交易量。

18.2 客户行为分析

import pandas as pd

import numpy as np

# 创建模拟的客户购买数据

customers = ['C1', 'C2', 'C3', 'C4', 'C5']

products = ['P1', 'P2', 'P3']

df = pd.DataFrame({

'customer': np.repeat(customers, 20),

'product': np.random.choice(products, 100),

'amount': np.random.randint(10, 100, 100)

})

# 分析每个客户的平均购买金额和购买频率

result = df.groupby('customer').agg({

'amount': 'mean',

'product': 'count'

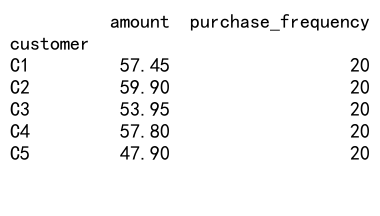

}).rename(columns={'product': 'purchase_frequency'})

print(result)

Output:

这个例子展示了如何使用GroupBy和Mean操作分析客户购买行为,计算每个客户的平均购买金额和购买频率。

19. 结合机器学习

GroupBy和Mean操作也可以在机器学习的数据预处理阶段发挥重要作用。

19.1 特征工程

import pandas as pd

import numpy as np

from sklearn.model_selection import train_test_split

from sklearn.preprocessing import StandardScaler

from sklearn.ensemble import RandomForestClassifier

# 创建模拟数据

df = pd.DataFrame({

'user_id': np.repeat(range(1000), 10),

'product_category': np.random.choice(['A', 'B', 'C'], 10000),

'purchase_amount': np.random.randint(10, 200, 10000),

'is_fraud': np.random.choice([0, 1], 10000, p=[0.99, 0.01])

})

# 使用GroupBy和Mean创建新特征

user_features = df.groupby('user_id').agg({

'purchase_amount': ['mean', 'std'],

'is_fraud': 'mean'

}).reset_index()

user_features.columns = ['user_id', 'avg_purchase', 'std_purchase', 'fraud_rate']

# 准备机器学习数据

X = user_features[['avg_purchase', 'std_purchase', 'fraud_rate']]

y = (user_features['fraud_rate'] > 0).astype(int)

# 分割数据集

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)

# 标准化特征

scaler = StandardScaler()

X_train_scaled = scaler.fit_transform(X_train)

X_test_scaled = scaler.transform(X_test)

# 训练随机森林分类器

clf = RandomForestClassifier(n_estimators=100, random_state=42)

clf.fit(X_train_scaled, y_train)

# 评估模型

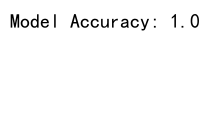

print("Model Accuracy:", clf.score(X_test_scaled, y_test))

Output:

这个例子展示了如何使用GroupBy和Mean操作进行特征工程,创建新的特征用于机器学习模型。我们计算了每个用户的平均购买金额、购买金额标准差和欺诈率,然后使用这些特征训练了一个随机森林分类器来预测用户是否有欺诈倾向。

20. 总结

Pandas的GroupBy和Mean操作是数据分析中非常强大和灵活的工具。它们允许我们快速高效地对数据进行分组和聚合,从而揭示数据中的模式和趋势。本文详细介绍了这些操作的基本用法、高级技巧、性能优化方法以及在实际应用中的各种场景。

关键要点包括:

1. GroupBy操作允许我们按一个或多个列对数据进行分组。

2. Mean操作可以单独使用,也可以与GroupBy结合使用来计算分组的平均值。

3. 这些操作可以与其他Pandas功能(如merge、pivot等)结合使用,以进行更复杂的数据分析。

4. 对于大型数据集,使用适当的优化技巧(如使用分类数据类型、索引等)可以显著提高性能。

5. GroupBy和Mean操作在金融分析、客户行为分析、时间序列数据处理等多个领域有广泛应用。

6. 在机器学习的特征工程阶段,这些操作也可以用来创建有意义的新特征。

通过掌握这些技巧和方法,数据分析师和科学家可以更有效地处理和分析复杂的数据集,从而做出更好的数据驱动决策。随着数据规模和复杂性的不断增加,熟练运用这些工具将变得越来越重要。

最后,建议读者在实际项目中多加练习和应用这些技巧,并始终关注Pandas库的最新更新,以便利用新的功能和性能改进。

极客笔记

极客笔记