Pandas GroupBy Size:高效统计和分析数据的利器

Pandas是Python中最流行的数据处理库之一,而GroupBy操作是数据分析中常用的技术。本文将深入探讨Pandas中的GroupBy Size功能,这是一个强大的工具,用于快速统计和分析分组数据的大小。我们将详细介绍其用法、特点和应用场景,并提供多个实用的示例代码,帮助您更好地掌握这一功能。

1. GroupBy Size的基本概念

GroupBy Size是Pandas中GroupBy对象的一个方法,用于计算每个分组中的元素数量。它返回一个Series对象,其中索引是分组的键,值是每个分组的大小。这个方法非常适合快速了解数据集中各个类别的分布情况。

让我们从一个简单的例子开始:

import pandas as pd

# 创建示例数据

data = {

'category': ['A', 'B', 'A', 'C', 'B', 'A', 'C'],

'value': [1, 2, 3, 4, 5, 6, 7]

}

df = pd.DataFrame(data)

# 使用GroupBy Size

result = df.groupby('category').size()

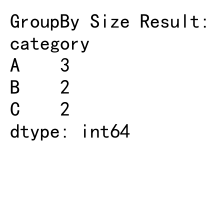

print("GroupBy Size Result:")

print(result)

Output:

在这个例子中,我们创建了一个包含’category’和’value’两列的DataFrame。通过groupby('category').size(),我们可以快速得到每个类别的出现次数。这个操作等同于计算每个类别的行数。

2. GroupBy Size vs. Count

虽然GroupBy Size和Count方法看起来很相似,但它们之间存在一些重要的区别:

- Size总是返回组中的项目数,包括NaN值。

- Count默认会排除NaN值,除非指定

dropna=False。

让我们通过一个例子来说明这一点:

import pandas as pd

import numpy as np

# 创建包含NaN值的数据

data = {

'category': ['A', 'B', 'A', 'C', 'B', 'A', 'C'],

'value': [1, np.nan, 3, np.nan, 5, 6, 7]

}

df = pd.DataFrame(data)

# 使用Size

size_result = df.groupby('category').size()

# 使用Count

count_result = df.groupby('category').count()

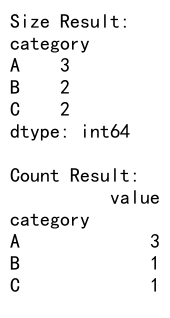

print("Size Result:")

print(size_result)

print("\nCount Result:")

print(count_result)

Output:

在这个例子中,我们可以看到Size方法会包括所有的行,而Count方法默认会排除包含NaN值的行。这个区别在处理包含缺失值的数据时尤为重要。

3. GroupBy Size的高级用法

3.1 多列分组

GroupBy Size不仅可以对单列进行分组,还可以同时对多列进行分组。这在分析多维度数据时非常有用。

import pandas as pd

# 创建多维度数据

data = {

'category': ['A', 'B', 'A', 'C', 'B', 'A', 'C'],

'subcategory': ['X', 'Y', 'X', 'Z', 'Y', 'Z', 'X'],

'value': [1, 2, 3, 4, 5, 6, 7]

}

df = pd.DataFrame(data)

# 对多列进行分组

result = df.groupby(['category', 'subcategory']).size()

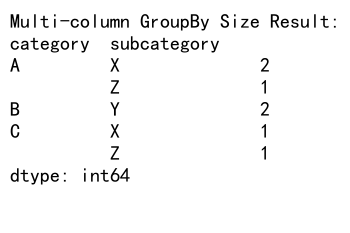

print("Multi-column GroupBy Size Result:")

print(result)

Output:

这个例子展示了如何同时按’category’和’subcategory’进行分组,并计算每个组合的大小。

3.2 结合reset_index()

有时,我们可能希望将GroupBy Size的结果转换为DataFrame格式,以便进行进一步的操作。这可以通过reset_index()方法实现:

import pandas as pd

# 创建示例数据

data = {

'category': ['A', 'B', 'A', 'C', 'B', 'A', 'C'],

'value': [1, 2, 3, 4, 5, 6, 7]

}

df = pd.DataFrame(data)

# 使用GroupBy Size并重置索引

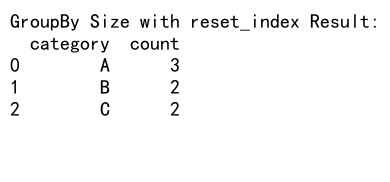

result = df.groupby('category').size().reset_index(name='count')

print("GroupBy Size with reset_index Result:")

print(result)

Output:

这个操作将结果转换为一个包含’category’和’count’两列的DataFrame,使得后续的数据处理更加方便。

3.3 使用自定义函数

GroupBy Size还可以与自定义函数结合使用,以实现更复杂的统计操作:

import pandas as pd

# 创建示例数据

data = {

'category': ['A', 'B', 'A', 'C', 'B', 'A', 'C'],

'value': [1, 2, 3, 4, 5, 6, 7]

}

df = pd.DataFrame(data)

# 定义自定义函数

def custom_size(group):

return pd.Series({'size': len(group), 'custom_metric': len(group) * 2})

# 使用自定义函数

result = df.groupby('category').apply(custom_size)

print("Custom Function Result:")

print(result)

在这个例子中,我们定义了一个自定义函数,不仅计算组的大小,还计算了一个自定义指标。这展示了GroupBy操作的灵活性。

4. GroupBy Size在数据分析中的应用

4.1 频率分析

GroupBy Size非常适合进行频率分析,例如分析客户购买行为:

import pandas as pd

# 创建购买数据

data = {

'customer_id': [1, 2, 1, 3, 2, 1, 3, 4, 5],

'product': ['A', 'B', 'C', 'A', 'A', 'B', 'C', 'B', 'A']

}

df = pd.DataFrame(data)

# 分析每个客户的购买频率

purchase_frequency = df.groupby('customer_id').size().sort_values(ascending=False)

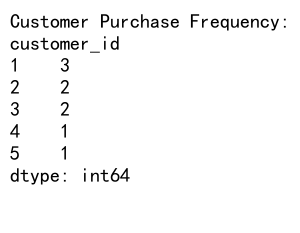

print("Customer Purchase Frequency:")

print(purchase_frequency)

Output:

这个例子展示了如何使用GroupBy Size来分析每个客户的购买次数,并按购买频率降序排列。

4.2 异常检测

GroupBy Size也可以用于异常检测,例如识别不寻常的数据分布:

import pandas as pd

import numpy as np

# 创建包含异常值的数据

np.random.seed(0)

data = {

'category': np.random.choice(['A', 'B', 'C', 'D'], 1000),

'value': np.random.randn(1000)

}

df = pd.DataFrame(data)

# 添加一些异常值

df.loc[1000] = ['E', 0]

df.loc[1001] = ['E', 0]

# 使用GroupBy Size检测异常

category_counts = df.groupby('category').size()

mean_count = category_counts.mean()

std_count = category_counts.std()

# 定义异常阈值(例如:小于平均值减两倍标准差)

threshold = mean_count - 2 * std_count

anomalies = category_counts[category_counts < threshold]

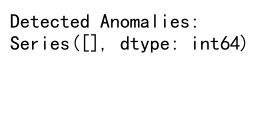

print("Detected Anomalies:")

print(anomalies)

Output:

这个例子展示了如何使用GroupBy Size来检测数据集中的异常类别,即出现次数明显少于其他类别的情况。

4.3 数据质量检查

GroupBy Size还可以用于数据质量检查,例如检查是否存在重复记录:

import pandas as pd

# 创建包含重复记录的数据

data = {

'id': [1, 2, 3, 4, 5, 1, 2],

'name': ['Alice', 'Bob', 'Charlie', 'David', 'Eve', 'Alice', 'Bob'],

'value': [100, 200, 300, 400, 500, 100, 200]

}

df = pd.DataFrame(data)

# 使用GroupBy Size检查重复记录

duplicates = df.groupby('id').size()

duplicates = duplicates[duplicates > 1]

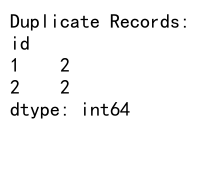

print("Duplicate Records:")

print(duplicates)

Output:

这个例子展示了如何使用GroupBy Size来识别数据集中的重复记录,这在数据清洗和预处理阶段非常有用。

5. GroupBy Size的性能优化

在处理大型数据集时,GroupBy Size的性能可能会成为一个问题。以下是一些优化建议:

5.1 使用分类数据类型

对于包含有限且重复值的列,使用分类数据类型可以显著提高性能:

import pandas as pd

# 创建大型数据集

data = {

'category': ['A', 'B', 'C'] * 1000000,

'value': range(3000000)

}

df = pd.DataFrame(data)

# 将category列转换为分类类型

df['category'] = df['category'].astype('category')

# 使用GroupBy Size

result = df.groupby('category').size()

print("GroupBy Size Result with Categorical Data:")

print(result)

这个例子展示了如何将分组列转换为分类类型,这可以在大型数据集上提高GroupBy操作的性能。

5.2 使用Numba加速

对于更复杂的自定义聚合函数,可以考虑使用Numba来加速计算:

import pandas as pd

import numpy as np

from numba import jit

# 创建大型数据集

data = {

'category': np.random.choice(['A', 'B', 'C'], 1000000),

'value': np.random.randn(1000000)

}

df = pd.DataFrame(data)

@jit(nopython=True)

def custom_size(values):

return len(values)

# 使用Numba加速的自定义函数

result = df.groupby('category')['value'].agg(custom_size)

print("GroupBy Size Result with Numba:")

print(result)

这个例子展示了如何使用Numba来加速自定义的GroupBy操作,这在处理大型数据集时特别有用。

6. GroupBy Size的实际应用案例

6.1 客户细分分析

在市场营销中,GroupBy Size可以用于客户细分分析:

import pandas as pd

import numpy as np

# 创建客户数据

np.random.seed(0)

data = {

'customer_id': range(1000),

'age_group': np.random.choice(['18-25', '26-35', '36-45', '46+'], 1000),

'gender': np.random.choice(['Male', 'Female'], 1000),

'purchase_amount': np.random.randint(10, 1000, 1000)

}

df = pd.DataFrame(data)

# 使用GroupBy Size进行客户细分

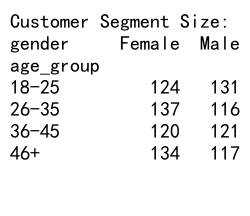

segment_size = df.groupby(['age_group', 'gender']).size().unstack()

print("Customer Segment Size:")

print(segment_size)

Output:

这个例子展示了如何使用GroupBy Size来分析不同年龄组和性别的客户数量,这对于制定针对性的营销策略非常有用。

6.2 时间序列数据分析

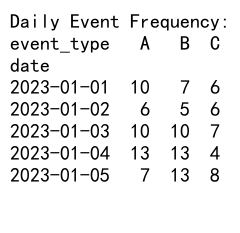

GroupBy Size也可以用于时间序列数据分析,例如分析每日事件频率:

import pandas as pd

import numpy as np

# 创建时间序列数据

dates = pd.date_range(start='2023-01-01', end='2023-12-31', freq='D')

data = {

'date': np.random.choice(dates, 10000),

'event_type': np.random.choice(['A', 'B', 'C'], 10000)

}

df = pd.DataFrame(data)

# 分析每日事件频率

daily_events = df.groupby([df['date'].dt.date, 'event_type']).size().unstack(fill_value=0)

print("Daily Event Frequency:")

print(daily_events.head())

Output:

这个例子展示了如何使用GroupBy Size来分析每天不同类型事件的发生频率,这在日志分析和用户行为研究中非常有用。

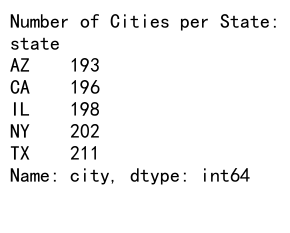

6.3 地理数据分析

GroupBy Size还可以用于地理数据分析,例如分析不同地区的数据分布:

import pandas as pd

import numpy as np

# 创建地理数据

data = {

'city': np.random.choice(['New York', 'Los Angeles', 'Chicago', 'Houston', 'Phoenix'], 1000),

'state': np.random.choice(['NY', 'CA', 'IL', 'TX', 'AZ'], 1000),

'population': np.random.randint(100000, 1000000, 1000)

}

df = pd.DataFrame(data)

# 分析每个州的城市数量

cities_per_state = df.groupby('state')['city'].size()

print("Number of Cities per State:")

print(cities_per_state)

Output:

这个例子展示了如何使用GroupBy Size来分析每个州包含的城市数量,这在地理信息系统(GIS)和人口统计分析中非常有用。

7. GroupBy Size的注意事项和最佳实践

7.1 处理大型数据集

当处理大型数据集时,内存使用可能成为一个问题。在这种情况下,可以考虑使用分块处理:

import pandas as pd

# 假设我们有一个大型CSV文件

chunk_size = 100000

result = pd.Series(dtype=int)

for chunk in pd.read_csv('large_file.csv', chunksize=chunk_size):

chunk_result = chunk.groupby('category').size```

result = result.add(chunk_result, fill_value=0)

print("GroupBy Size Result for Large Dataset:")

print(result)

这个例子展示了如何使用分块读取和处理大型CSV文件,逐步累加GroupBy Size的结果。这种方法可以有效减少内存使用,使得处理超大数据集成为可能。

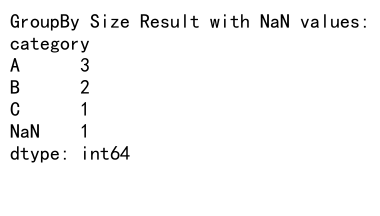

7.2 处理缺失值

在使用GroupBy Size时,需要注意缺失值的处理:

import pandas as pd

import numpy as np

# 创建包含缺失值的数据

data = {

'category': ['A', 'B', 'A', np.nan, 'B', 'A', 'C'],

'value': [1, 2, 3, 4, 5, 6, 7]

}

df = pd.DataFrame(data)

# 使用GroupBy Size

result = df.groupby('category', dropna=False).size()

print("GroupBy Size Result with NaN values:")

print(result)

Output:

在这个例子中,我们使用dropna=False参数来包括缺失值在内。这对于了解数据集中缺失值的分布非常有用。

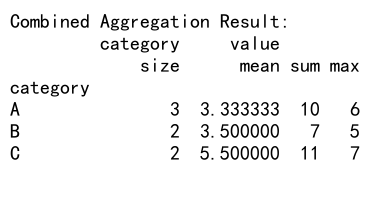

7.3 结合其他聚合函数

GroupBy Size通常与其他聚合函数结合使用,以获得更全面的数据洞察:

import pandas as pd

# 创建示例数据

data = {

'category': ['A', 'B', 'A', 'C', 'B', 'A', 'C'],

'value': [1, 2, 3, 4, 5, 6, 7]

}

df = pd.DataFrame(data)

# 结合多个聚合函数

result = df.groupby('category').agg({

'category': 'size',

'value': ['mean', 'sum', 'max']

})

print("Combined Aggregation Result:")

print(result)

Output:

这个例子展示了如何将GroupBy Size与其他聚合函数(如平均值、总和、最大值)结合使用,以获得更全面的统计信息。

8. GroupBy Size在数据可视化中的应用

GroupBy Size的结果非常适合用于数据可视化,特别是在展示类别分布时:

import pandas as pd

import matplotlib.pyplot as plt

# 创建示例数据

data = {

'category': ['A', 'B', 'A', 'C', 'B', 'A', 'C', 'D', 'D', 'E'],

'value': [1, 2, 3, 4, 5, 6, 7, 8, 9, 10]

}

df = pd.DataFrame(data)

# 使用GroupBy Size

result = df.groupby('category').size()

# 创建柱状图

plt.figure(figsize=(10, 6))

result.plot(kind='bar')

plt.title('Category Distribution')

plt.xlabel('Category')

plt.ylabel('Count')

plt.savefig('category_distribution.png')

plt.close()

print("Bar chart saved as 'category_distribution.png'")

这个例子展示了如何使用matplotlib将GroupBy Size的结果可视化为柱状图,直观地展示各个类别的分布情况。

9. GroupBy Size在机器学习中的应用

在机器学习中,GroupBy Size可以用于特征工程,例如创建频率编码特征:

import pandas as pd

import numpy as np

from sklearn.model_selection import train_test_split

from sklearn.ensemble import RandomForestClassifier

# 创建示例数据

np.random.seed(0)

data = {

'category': np.random.choice(['A', 'B', 'C', 'D'], 1000),

'value': np.random.randn(1000),

'target': np.random.choice([0, 1], 1000)

}

df = pd.DataFrame(data)

# 创建频率编码特征

frequency_encoding = df.groupby('category').size() / len(df)

df['category_freq'] = df['category'].map(frequency_encoding)

# 准备特征和目标变量

X = df[['value', 'category_freq']]

y = df['target']

# 分割数据集

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)

# 训练随机森林模型

model = RandomForestClassifier(random_state=42)

model.fit(X_train, y_train)

# 评估模型

score = model.score(X_test, y_test)

print(f"Model accuracy: {score:.2f}")

Output:

这个例子展示了如何使用GroupBy Size创建频率编码特征,并将其用于训练机器学习模型。频率编码可以捕捉类别变量的重要信息,有助于提高模型性能。

10. GroupBy Size的高级技巧

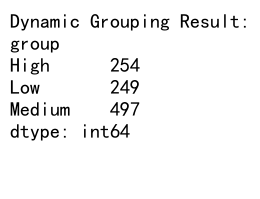

10.1 动态分组

有时我们需要根据数据的特征动态创建分组:

import pandas as pd

import numpy as np

# 创建示例数据

np.random.seed(0)

data = {

'value': np.random.randint(0, 100, 1000)

}

df = pd.DataFrame(data)

# 定义动态分组函数

def group_function(x):

if x < 25:

return 'Low'

elif x < 75:

return 'Medium'

else:

return 'High'

# 应用动态分组

df['group'] = df['value'].apply(group_function)

# 使用GroupBy Size

result = df.groupby('group').size()

print("Dynamic Grouping Result:")

print(result)

Output:

这个例子展示了如何使用自定义函数创建动态分组,然后应用GroupBy Size来分析结果。

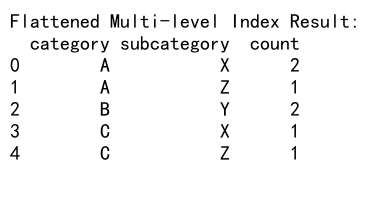

10.2 多级索引结果的处理

当使用多列进行分组时,GroupBy Size会返回一个多级索引的Series。处理这种结果需要特别注意:

import pandas as pd

# 创建多维度数据

data = {

'category': ['A', 'B', 'A', 'C', 'B', 'A', 'C'],

'subcategory': ['X', 'Y', 'X', 'Z', 'Y', 'Z', 'X'],

'value': [1, 2, 3, 4, 5, 6, 7]

}

df = pd.DataFrame(data)

# 多列分组

result = df.groupby(['category', 'subcategory']).size()

# 展平多级索引

flat_result = result.reset_index(name='count')

print("Flattened Multi-level Index Result:")

print(flat_result)

Output:

这个例子展示了如何处理多级索引的GroupBy Size结果,将其转换为更易于处理的扁平化DataFrame。

结论

Pandas的GroupBy Size功能是一个强大而灵活的工具,适用于各种数据分析场景。从基本的频率统计到高级的数据挖掘和机器学习应用,GroupBy Size都能发挥重要作用。通过本文的详细介绍和丰富的示例,我们深入探讨了GroupBy Size的使用方法、注意事项和最佳实践。

无论是进行简单的数据汇总,还是复杂的多维度分析,GroupBy Size都能提供快速而准确的结果。在处理大型数据集时,合理使用分类数据类型和分块处理等技巧可以显著提高性能。结合其他Pandas功能和数据可视化工具,GroupBy Size可以帮助数据分析师和科学家更好地理解和挖掘数据中的价值。

在实际应用中,GroupBy Size的灵活性使其成为数据预处理、特征工程和异常检测等任务中不可或缺的工具。通过掌握本文介绍的各种技巧和应用场景,读者可以更加得心应手地使用GroupBy Size,提高数据分析的效率和质量。

随着数据分析领域的不断发展,GroupBy Size及其相关功能也在不断更新和改进。持续关注Pandas的最新发展,并结合实际项目经验,将有助于更好地利用这一强大工具,在数据分析和机器学习领域取得更大的成功。

极客笔记

极客笔记