Pandas GroupBy 操作:高效处理列表数据的全面指南

Pandas是Python中强大的数据处理库,其中GroupBy操作是一个非常实用的功能,特别是在处理包含列表数据的DataFrame时。本文将全面介绍如何在Pandas中使用GroupBy操作处理列表数据,包括基本概念、常用方法、高级技巧以及实际应用场景。

1. GroupBy基础概念

在Pandas中,GroupBy操作允许我们将数据按照某个或某些列进行分组,然后对每个分组应用特定的操作。当处理包含列表的DataFrame时,GroupBy操作变得尤为重要,因为它可以帮助我们更有效地处理和分析复杂的嵌套数据结构。

让我们从一个简单的例子开始:

import pandas as pd

# 创建一个包含列表的DataFrame

df = pd.DataFrame({

'name': ['Alice', 'Bob', 'Charlie', 'David'],

'scores': [[85, 90, 78], [92, 88, 95], [75, 80, 82], [88, 91, 87]],

'website': ['pandasdataframe.com'] * 4

})

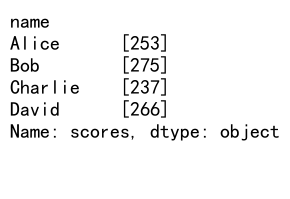

# 使用GroupBy对scores列进行操作

result = df.groupby('name')['scores'].apply(lambda x: [sum(scores) for scores in x])

print(result)

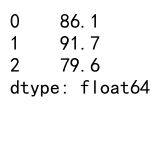

Output:

在这个例子中,我们创建了一个DataFrame,其中’scores’列包含列表数据。我们使用GroupBy按’name’列分组,然后对每个分组的’scores’列应用一个lambda函数,计算每个学生的总分。

2. GroupBy与列表数据的常用操作

2.1 列表展开与聚合

当处理包含列表的DataFrame时,我们经常需要展开列表并进行聚合操作。以下是一个示例:

import pandas as pd

df = pd.DataFrame({

'category': ['A', 'A', 'B', 'B', 'C'],

'items': [['apple', 'banana'], ['orange'], ['grape', 'melon'], ['pear'], ['kiwi', 'mango']],

'website': ['pandasdataframe.com'] * 5

})

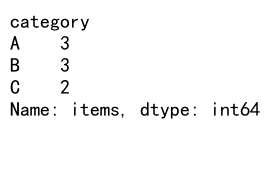

# 展开列表并计算每个类别的项目数量

result = df.explode('items').groupby('category')['items'].count()

print(result)

Output:

在这个例子中,我们首先使用explode()方法展开’items’列,然后按’category’分组并计算每个类别的项目数量。这种方法在处理嵌套数据结构时非常有用。

2.2 列表元素的统计操作

GroupBy操作还允许我们对列表中的元素进行各种统计操作。例如:

import pandas as pd

import numpy as np

df = pd.DataFrame({

'team': ['A', 'A', 'B', 'B', 'C'],

'scores': [[85, 90, 78], [92, 88, 95], [75, 80, 82], [88, 91, 87], [79, 83, 86]],

'website': ['pandasdataframe.com'] * 5

})

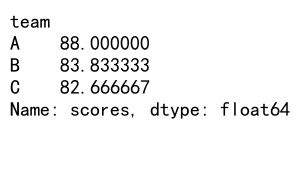

# 计算每个团队的平均分数

result = df.groupby('team')['scores'].apply(lambda x: np.mean([np.mean(scores) for scores in x]))

print(result)

Output:

这个例子展示了如何计算每个团队的平均分数。我们使用lambda函数和NumPy的mean函数来计算每个列表的平均值,然后再计算每个团队的平均分数。

3. 高级GroupBy技巧

3.1 多列GroupBy

有时我们需要根据多个列进行分组操作。以下是一个示例:

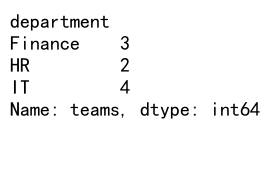

import pandas as pd

df = pd.DataFrame({

'department': ['IT', 'IT', 'HR', 'HR', 'Finance'],

'team': ['A', 'B', 'A', 'B', 'A'],

'projects': [['web', 'mobile'], ['data', 'cloud'], ['recruit', 'train'], ['policy'], ['budget', 'audit']],

'website': ['pandasdataframe.com'] * 5

})

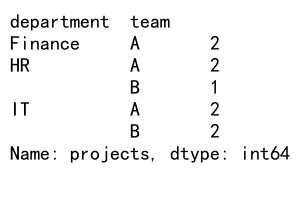

# 按部门和团队分组,计算项目数量

result = df.groupby(['department', 'team'])['projects'].apply(lambda x: sum(len(projects) for projects in x))

print(result)

Output:

这个例子展示了如何按多个列(’department’和’team’)进行分组,然后计算每个组的项目总数。

3.2 自定义聚合函数

Pandas允许我们定义自己的聚合函数来处理列表数据。例如:

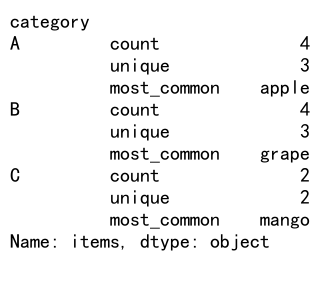

import pandas as pd

def list_stats(x):

flattened = [item for sublist in x for item in sublist]

return pd.Series({

'count': len(flattened),

'unique': len(set(flattened)),

'most_common': max(set(flattened), key=flattened.count)

})

df = pd.DataFrame({

'category': ['A', 'A', 'B', 'B', 'C'],

'items': [['apple', 'banana'], ['apple', 'orange'], ['grape', 'melon'], ['grape', 'pear'], ['kiwi', 'mango']],

'website': ['pandasdataframe.com'] * 5

})

result = df.groupby('category')['items'].apply(list_stats)

print(result)

Output:

在这个例子中,我们定义了一个自定义函数list_stats,它计算列表中元素的总数、唯一元素数量和最常见的元素。然后我们将这个函数应用到GroupBy操作中。

4. 处理复杂的列表结构

4.1 嵌套列表的处理

有时我们可能遇到嵌套列表的情况。以下是一个处理嵌套列表的例子:

import pandas as pd

df = pd.DataFrame({

'department': ['IT', 'HR', 'Finance'],

'teams': [

[['Alice', 'Bob'], ['Charlie', 'David']],

[['Eva', 'Frank']],

[['George', 'Hannah'], ['Ian']]

],

'website': ['pandasdataframe.com'] * 3

})

# 展平嵌套列表并计算每个部门的员工数量

result = df.explode('teams').explode('teams').groupby('department')['teams'].count()

print(result)

Output:

在这个例子中,我们使用了两次explode()方法来展平嵌套的列表结构,然后计算每个部门的员工数量。

4.2 列表元素的条件筛选

我们还可以在GroupBy操作中对列表元素进行条件筛选。例如:

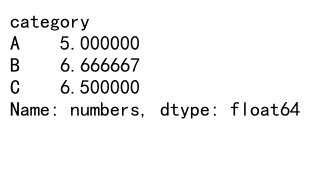

import pandas as pd

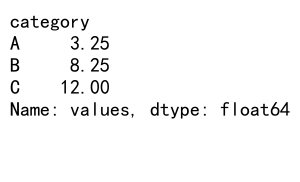

df = pd.DataFrame({

'category': ['A', 'A', 'B', 'B', 'C'],

'numbers': [[1, 5, 3], [2, 4, 6], [7, 3, 1], [5, 2, 8], [9, 4, 2]],

'website': ['pandasdataframe.com'] * 5

})

# 筛选出每个类别中大于3的数字并计算平均值

result = df.groupby('category')['numbers'].apply(lambda x: [num for sublist in x for num in sublist if num > 3]).apply(lambda x: sum(x) / len(x) if x else 0)

print(result)

Output:

这个例子展示了如何在GroupBy操作中筛选出每个类别中大于3的数字,然后计算这些数字的平均值。

5. GroupBy与列表的实际应用场景

5.1 时间序列数据分析

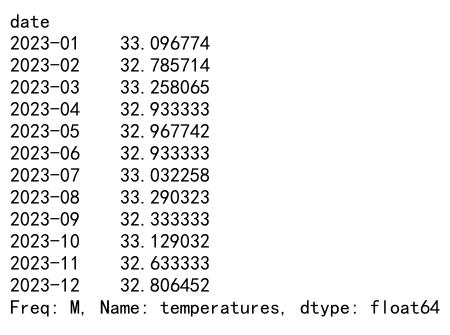

GroupBy操作在处理时间序列数据时非常有用,特别是当数据包含列表时。以下是一个示例:

import pandas as pd

import numpy as np

# 创建一个包含日期和温度列表的DataFrame

dates = pd.date_range(start='2023-01-01', end='2023-12-31', freq='D')

df = pd.DataFrame({

'date': dates,

'temperatures': [np.random.randint(0, 35, 24).tolist() for _ in range(len(dates))],

'website': ['pandasdataframe.com'] * len(dates)

})

# 计算每月的平均最高温度

result = df.groupby(df['date'].dt.to_period('M'))['temperatures'].apply(lambda x: np.mean([max(temps) for temps in x]))

print(result)

Output:

这个例子展示了如何使用GroupBy操作来分析每日温度数据,计算每月的平均最高温度。

5.2 文本数据处理

GroupBy操作也可以用于处理文本数据,特别是当文本被分割成列表时:

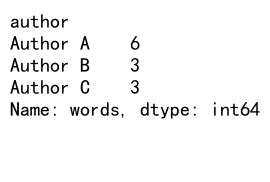

import pandas as pd

df = pd.DataFrame({

'author': ['Author A', 'Author B', 'Author A', 'Author C'],

'words': [['hello', 'world', 'pandas'], ['data', 'science', 'python'], ['groupby', 'list', 'operation'], ['machine', 'learning', 'ai']],

'website': ['pandasdataframe.com'] * 4

})

# 计算每个作者使用的独特单词数量

result = df.groupby('author')['words'].apply(lambda x: len(set([word for sublist in x for word in sublist])))

print(result)

Output:

这个例子展示了如何使用GroupBy操作来分析每个作者使用的独特单词数量。

6. 性能优化技巧

在处理大型数据集时,GroupBy操作可能会变得很慢。以下是一些优化技巧:

6.1 使用agg()方法

agg()方法通常比apply()更快,特别是当你需要执行多个聚合操作时:

import pandas as pd

import numpy as np

df = pd.DataFrame({

'category': ['A', 'A', 'B', 'B', 'C'] * 1000,

'values': [np.random.randint(1, 100, 5).tolist() for _ in range(5000)],

'website': ['pandasdataframe.com'] * 5000

})

# 使用agg()方法执行多个聚合操作

result = df.groupby('category')['values'].agg({

'mean': lambda x: np.mean([np.mean(v) for v in x]),

'max': lambda x: np.max([np.max(v) for v in x]),

'min': lambda x: np.min([np.min(v) for v in x])

})

print(result)

这个例子展示了如何使用agg()方法同时计算多个统计量,这通常比多次使用apply()更高效。

6.2 使用numba加速

对于计算密集型的操作,可以使用numba来加速:

import pandas as pd

import numpy as np

from numba import jit

@jit(nopython=True)

def fast_mean(arr):

return np.mean([np.mean(x) for x in arr])

df = pd.DataFrame({

'category': ['A', 'B', 'C'] * 1000,

'values': [np.random.randint(1, 100, 10).tolist() for _ in range(3000)],

'website': ['pandasdataframe.com'] * 3000

})

result = df.groupby('category')['values'].apply(lambda x: fast_mean(x.values))

print(result)

在这个例子中,我们使用numba的@jit装饰器来编译fast_mean函数,这可以显著提高计算速度,特别是对于大型数据集。

7. 处理缺失值和异常

在实际应用中,我们经常需要处理包含缺失值或异常的数据。以下是一些处理这些情况的方法:

7.1 处理缺失值

import pandas as pd

import numpy as np

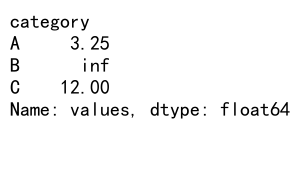

df = pd.DataFrame({

'category': ['A', 'A', 'B', 'B', 'C'],

'values': [[1, 2, 3], [4, 5, np.nan], [6, 7, 8], [np.nan, 9, 10], [11, 12, 13]],

'website': ['pandasdataframe.com'] * 5

})

# 忽略缺失值并计算平均值

result = df.groupby('category')['values'].apply(lambda x: np.nanmean([np.nanmean(v) for v in x]))

print(result)

Output:

这个例子展示了如何在计算平均值时忽略缺失值(NaN)。

7.2 处理异常值

import pandas as pd

import numpy as np

def safe_mean(x):

return np.mean([v for v in x if isinstance(v, (int, float)) and not np.isnan(v)])

df = pd.DataFrame({

'category': ['A', 'A', 'B', 'B', 'C'],

'values': [[1, 2, 'error'], [4, 5, 6], ['invalid', 7, 8], [9, 10, np.inf], [11, 12, 13]],

'website': ['pandasdataframe.com'] * 5

})

# 安全地计算平均值,忽略非数值和无穷大

result = df.groupby('category')['values'].apply(lambda x: safe_mean([safe_mean(v) for v in x]))

print(result)

Output:

这个例子展示了如何安全地处理包含非数值和无穷大的数据。

8. 高级数据转换

GroupBy操作还可以用于执行复杂的数据转换。以下是一些高级示例:

8.1 列表展开和重塑

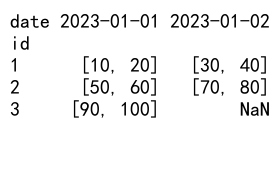

import pandas as pd

df = pd.DataFrame({

'id': [1, 1, 2, 2, 3],

'date': ['2023-01-01', '2023-01-02', '2023-01-01', '2023-01-02', '2023-01-01'],

'values': [[10, 20], [30, 40], [50, 60], [70, 80], [90, 100]],

'website': ['pandasdataframe.com'] * 5

})

# 展开列表并重塑数据

result = df.explode('values').groupby(['id', 'date'])['values'].apply(list).unstack()

print(result)

Output:

这个例子展示了如何展开列表数据,然后重新塑造成一个新的DataFrame结构。

8.2 动态列创建

import pandas as pd

df = pd.DataFrame({

'category': ['A', 'B', 'C', 'A', 'B'],

'subcategories': [['x', 'y'], ['z'], ['x', 'y', 'z'], ['y', 'z'], ['x']],

'values': [[1, 2], [3], [4, 5, 6], [7, 8], [9]],

'website': ['pandasdataframe.com'] * 5

})

def create_columns(group):

result = pd.DataFrame(index=group.index)

for subcat, vals in zip(group['subcategories'], group['values']):

for sc, v in zip(subcat, vals):

result[sc] = result.get(sc, 0) + v

return result

result = df.groupby('category').apply(create_columns).reset_index()

print(result)

这个例子展示了如何根据子类别动态创建新的列,并在这些列中聚合值。

9. 与其他Pandas功能的结合

GroupBy操作可以与Pandas的其他功能结合使用,以实现更复杂的数据处理任务。

9.1 与merge操作结合

import pandas as pd

df1 = pd.DataFrame({

'team': ['A', 'B', 'C'],

'scores': [[85, 90, 78], [92, 88, 95], [75, 80, 82]],

'website': ['pandasdataframe.com'] * 3

})

df2 = pd.DataFrame({

'team': ['A', 'B', 'C'],

'weights': [[0.3, 0.5, 0.2], [0.4, 0.3, 0.3], [0.2, 0.5, 0.3]],

'website': ['pandasdataframe.com'] * 3

})

# 合并数据框并计算加权平均分

merged = pd.merge(df1, df2, on='team')

result = merged.apply(lambda row: sum(s * w for s, w in zip(row['scores'], row['weights'])), axis=1)

print(result)

Output:

这个例子展示了如何合并两个DataFrame,然后使用GroupBy操作计算加权平均分。

9.2 与pivot_table结合

import pandas as pd

import numpy as np

df = pd.DataFrame({

'date': pd.date_range(start='2023-01-01', periods=10),

'category': ['A', 'B'] * 5,

'values': [np.random.randint(1, 100, 3).tolist() for _ in range(10)],

'website': ['pandasdataframe.com'] * 10

})

# 创建透视表并计算每个类别每天的平均值

result = df.pivot_table(

index='date',

columns='category',

values='values',

aggfunc=lambda x: np.mean([np.mean(v) for v in x])

)

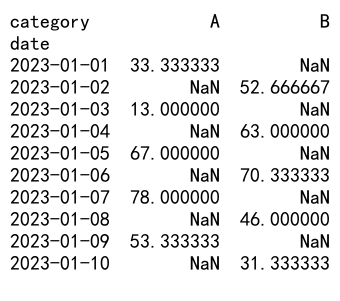

print(result)

Output:

这个例子展示了如何使用pivot_table创建一个透视表,同时处理列表数据。

10. 处理大规模数据集

当处理大规模数据集时,内存管理和性能优化变得尤为重要。以下是一些处理大规模数据的技巧:

10.1 使用chunks处理大文件

import pandas as pd

def process_chunk(chunk):

return chunk.groupby('category')['values'].apply(lambda x: [sum(v) for v in x])

# 假设我们有一个大型CSV文件

reader = pd.read_csv('large_file.csv', chunksize=10000)

results = []

for chunk in reader:

result = process_chunk(chunk)

results.append(result)

final_result = pd.concat(results).groupby(level=0).sum()

print(final_result)

这个例子展示了如何使用chunks来处理大型CSV文件,避免一次性将整个文件加载到内存中。

10.2 使用dask进行并行处理

对于非常大的数据集,可以考虑使用dask库进行并行处理:

import dask.dataframe as dd

# 假设我们有一个大型Parquet文件

ddf = dd.read_parquet('large_file.parquet')

result = ddf.groupby('category')['values'].apply(

lambda x: x.map(sum).sum(),

meta=('values', 'float64')

).compute()

print(result)

这个例子展示了如何使用dask来并行处理大型Parquet文件,这对于处理超出内存容量的数据集特别有用。

结论

Pandas的GroupBy操作是一个强大的工具,特别是在处理包含列表数据的DataFrame时。通过本文介绍的各种技巧和方法,你应该能够更有效地处理复杂的数据结构,执行高级的数据分析任务,并优化大规模数据处理的性能。

记住,选择合适的方法取决于你的具体需求和数据特征。在实际应用中,可能需要结合多种技术来达到最佳效果。持续练习和实验将帮助你更好地掌握这些技能,成为数据处理的专家。

最后,别忘了经常查阅Pandas的官方文档,因为随着新版本的发布,可能会有新的功能和优化方法出现。不断学习和更新你的知识库,将使你在数据分析领域保持竞争力。

极客笔记

极客笔记