Pandas GroupBy 和 Filter 操作:数据分组与筛选的高效技巧

Pandas是Python中最流行的数据处理库之一,它提供了强大的数据操作和分析工具。在处理大型数据集时,GroupBy和Filter操作是两个非常重要的功能,它们可以帮助我们更有效地组织、汇总和筛选数据。本文将深入探讨Pandas中的GroupBy和Filter操作,介绍它们的基本概念、常用方法以及实际应用场景。

1. GroupBy操作简介

GroupBy操作是Pandas中一个强大的功能,它允许我们将数据按照一个或多个列进行分组,然后对每个分组应用聚合函数或其他操作。这种操作在数据分析中非常常见,例如计算每个类别的平均值、找出每个组的最大值等。

1.1 基本GroupBy操作

让我们从一个简单的例子开始,了解GroupBy的基本用法:

import pandas as pd

# 创建示例数据

data = {

'website': ['pandasdataframe.com', 'pandasdataframe.com', 'pandasdataframe.com', 'pandasdataframe.com'],

'category': ['A', 'B', 'A', 'B'],

'value': [10, 20, 15, 25]

}

df = pd.DataFrame(data)

# 按category列进行分组,并计算value列的平均值

grouped = df.groupby('category')['value'].mean()

print(grouped)

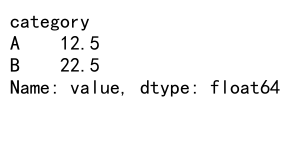

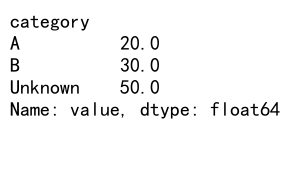

Output:

在这个例子中,我们首先创建了一个包含网站、类别和值的DataFrame。然后,我们使用groupby('category')按类别列进行分组,并计算每个类别的value平均值。这个操作会返回一个Series,其中索引是不同的类别,值是对应的平均值。

1.2 多列分组

GroupBy操作不仅限于单列分组,我们还可以按多个列进行分组:

import pandas as pd

# 创建示例数据

data = {

'website': ['pandasdataframe.com', 'pandasdataframe.com', 'pandasdataframe.com', 'pandasdataframe.com'],

'category': ['A', 'B', 'A', 'B'],

'subcategory': ['X', 'X', 'Y', 'Y'],

'value': [10, 20, 15, 25]

}

df = pd.DataFrame(data)

# 按category和subcategory列进行分组,并计算value列的平均值

grouped = df.groupby(['category', 'subcategory'])['value'].mean()

print(grouped)

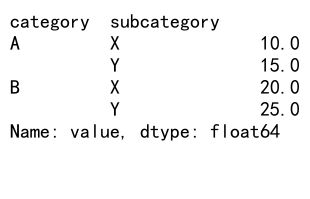

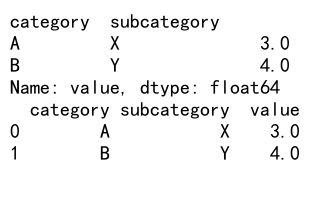

Output:

在这个例子中,我们按照category和subcategory两列进行分组。结果是一个多级索引的Series,其中第一级是category,第二级是subcategory。

1.3 应用多个聚合函数

我们可以同时应用多个聚合函数到分组后的数据:

import pandas as pd

# 创建示例数据

data = {

'website': ['pandasdataframe.com', 'pandasdataframe.com', 'pandasdataframe.com', 'pandasdataframe.com'],

'category': ['A', 'B', 'A', 'B'],

'value': [10, 20, 15, 25]

}

df = pd.DataFrame(data)

# 按category列进行分组,并应用多个聚合函数

grouped = df.groupby('category')['value'].agg(['mean', 'sum', 'count'])

print(grouped)

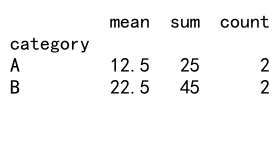

Output:

这个例子展示了如何对分组后的数据同时应用多个聚合函数。我们使用agg()方法并传入一个函数列表,这里计算了每个类别的平均值、总和和计数。

2. GroupBy的高级用法

除了基本的分组和聚合操作,GroupBy还提供了许多高级功能,让我们能够更灵活地处理分组数据。

2.1 自定义聚合函数

有时候,内置的聚合函数可能无法满足我们的需求。这时,我们可以定义自己的聚合函数:

import pandas as pd

import numpy as np

# 创建示例数据

data = {

'website': ['pandasdataframe.com'] * 5,

'category': ['A', 'B', 'A', 'B', 'A'],

'value': [10, 20, 15, 25, 30]

}

df = pd.DataFrame(data)

# 定义自定义聚合函数

def range_diff(x):

return x.max() - x.min()

# 应用自定义聚合函数

grouped = df.groupby('category')['value'].agg(range_diff)

print(grouped)

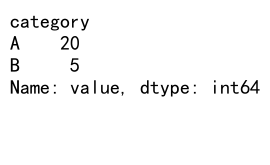

Output:

在这个例子中,我们定义了一个名为range_diff的函数,它计算每个组内最大值和最小值的差。然后,我们将这个函数传递给agg()方法,应用到分组后的数据上。

2.2 转换操作

GroupBy不仅可以用于聚合,还可以用于转换操作。转换操作会为每个组返回与原始数据相同大小的结果:

import pandas as pd

# 创建示例数据

data = {

'website': ['pandasdataframe.com'] * 6,

'category': ['A', 'B', 'A', 'B', 'A', 'B'],

'value': [10, 20, 15, 25, 30, 35]

}

df = pd.DataFrame(data)

# 对每个组应用转换操作

grouped = df.groupby('category')['value'].transform(lambda x: x - x.mean())

df['value_centered'] = grouped

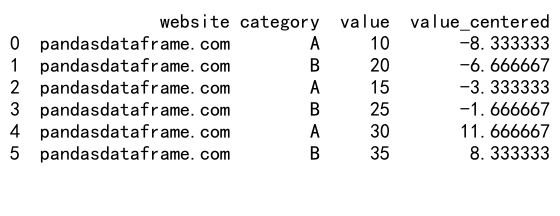

print(df)

Output:

在这个例子中,我们使用transform()方法对每个组的value列进行中心化处理,即减去该组的平均值。结果被添加为一个新列’value_centered’。

2.3 过滤操作

GroupBy还可以用于过滤整个组。例如,我们可能只想保留满足某些条件的组:

import pandas as pd

# 创建示例数据

data = {

'website': ['pandasdataframe.com'] * 6,

'category': ['A', 'B', 'C', 'A', 'B', 'C'],

'value': [10, 20, 5, 15, 25, 8]

}

df = pd.DataFrame(data)

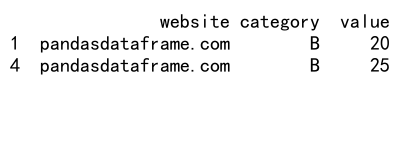

# 过滤出平均value大于15的组

filtered = df.groupby('category').filter(lambda x: x['value'].mean() > 15)

print(filtered)

Output:

在这个例子中,我们使用filter()方法来保留那些平均value大于15的组。注意,这会保留整个组的所有行,而不仅仅是聚合结果。

3. Filter操作详解

虽然我们在GroupBy中已经看到了一些过滤操作,但Pandas还提供了更多强大的过滤功能,可以帮助我们从各个角度筛选数据。

3.1 基于条件的过滤

最简单的过滤操作是基于条件的过滤,我们可以使用布尔索引来实现:

import pandas as pd

# 创建示例数据

data = {

'website': ['pandasdataframe.com'] * 5,

'category': ['A', 'B', 'C', 'A', 'B'],

'value': [10, 20, 30, 40, 50]

}

df = pd.DataFrame(data)

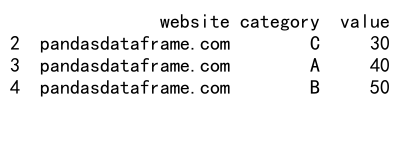

# 过滤出value大于25的行

filtered = df[df['value'] > 25]

print(filtered)

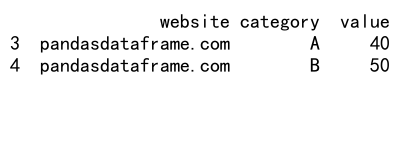

Output:

在这个例子中,我们使用条件df['value'] > 25创建了一个布尔Series,然后用它来索引DataFrame,从而只保留value大于25的行。

3.2 多条件过滤

我们可以组合多个条件来进行更复杂的过滤:

import pandas as pd

# 创建示例数据

data = {

'website': ['pandasdataframe.com'] * 6,

'category': ['A', 'B', 'C', 'A', 'B', 'C'],

'value': [10, 20, 30, 40, 50, 60]

}

df = pd.DataFrame(data)

# 过滤出category为'A'或'B',且value大于25的行

filtered = df[(df['category'].isin(['A', 'B'])) & (df['value'] > 25)]

print(filtered)

Output:

这个例子展示了如何使用&(与)和|(或)运算符来组合多个条件。我们还使用了isin()方法来检查category是否在指定的列表中。

3.3 使用query方法进行过滤

对于更复杂的过滤条件,我们可以使用query()方法,它允许我们使用字符串表达式来定义过滤条件:

import pandas as pd

# 创建示例数据

data = {

'website': ['pandasdataframe.com'] * 6,

'category': ['A', 'B', 'C', 'A', 'B', 'C'],

'value': [10, 20, 30, 40, 50, 60]

}

df = pd.DataFrame(data)

# 使用query方法进行过滤

filtered = df.query("category in ['A', 'B'] and value > 25")

print(filtered)

Output:

query()方法提供了一种更直观的方式来表达复杂的过滤条件,特别是当涉及到多个列和条件时。

3.4 基于索引的过滤

有时我们需要基于索引来过滤数据:

import pandas as pd

# 创建示例数据

data = {

'website': ['pandasdataframe.com'] * 5,

'category': ['A', 'B', 'C', 'D', 'E'],

'value': [10, 20, 30, 40, 50]

}

df = pd.DataFrame(data, index=['a', 'b', 'c', 'd', 'e'])

# 基于索引过滤

filtered = df.loc[['a', 'c', 'e']]

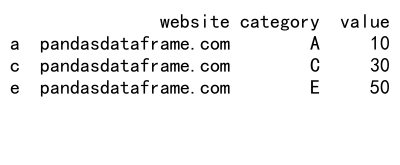

print(filtered)

Output:

在这个例子中,我们使用loc索引器来选择特定的行。这种方法在处理时间序列数据时特别有用,因为我们经常需要选择特定的日期范围。

4. GroupBy和Filter的结合使用

GroupBy和Filter操作可以结合使用,为数据分析提供更强大的功能。

4.1 对分组后的数据进行过滤

我们可以先进行分组,然后对分组后的数据应用过滤条件:

import pandas as pd

# 创建示例数据

data = {

'website': ['pandasdataframe.com'] * 8,

'category': ['A', 'B', 'A', 'B', 'A', 'B', 'A', 'B'],

'value': [10, 20, 15, 25, 30, 35, 40, 45]

}

df = pd.DataFrame(data)

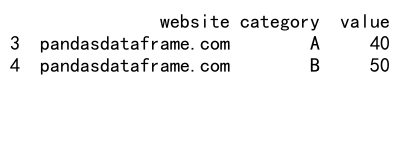

# 对分组后的数据进行过滤

filtered = df.groupby('category').filter(lambda x: x['value'].mean() > 25)

print(filtered)

Output:

这个例子展示了如何使用filter()方法来保留那些平均value大于25的组。这种操作会保留整个组的所有行,而不仅仅是聚合结果。

4.2 分组聚合后的过滤

有时我们可能想先进行分组聚合,然后对聚合结果进行过滤:

import pandas as pd

# 创建示例数据

data = {

'website': ['pandasdataframe.com'] * 8,

'category': ['A', 'B', 'C', 'D', 'A', 'B', 'C', 'D'],

'value': [10, 20, 15, 25, 30, 35, 40, 45]

}

df = pd.DataFrame(data)

# 分组聚合后进行过滤

grouped = df.groupby('category')['value'].mean()

filtered = grouped[grouped > 25]

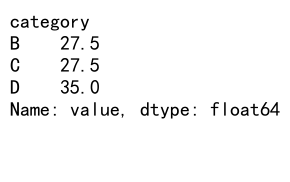

print(filtered)

Output:

在这个例子中,我们首先按category分组并计算value的平均值,然后只保留平均值大于25的类别。

4.3 使用transform进行复杂过滤

transform()方法可以用来创建基于组级别计算的新列,这些新列可以用于更复杂的过滤操作:

import pandas as pd

# 创建示例数据

data = {

'website': ['pandasdataframe.com'] * 8,

'category': ['A', 'B', 'A', 'B', 'A', 'B', 'A', 'B'],

'value': [10, 20, 15, 25, 30, 35, 40, 45]

}

df = pd.DataFrame(data)

# 使用transform创建新列,然后进行过滤

df['group_mean'] = df.groupby('category')['value'].transform('mean')

filtered = df[df['value'] > df['group_mean']]

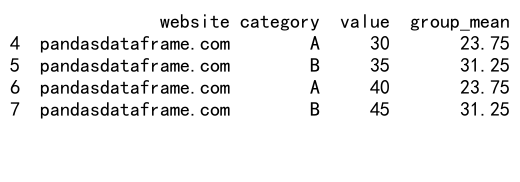

print(filtered)

Output:

在这个例子中,我们首先使用transform()方法为每个组计算平均值,并将结果添加为一个新列。然后,我们过滤出那些value大于其所在组平均值的行。

5. 性能优化技巧

在处理大型数据集时,GroupBy和Filter操作可能会变得很慢。以下是一些提高性能的技巧:

5.1 使用categorical数据类型

对于分组操作中经常使用的列,将其转换为categorical类型可以显著提高性能:

import pandas as pd

# 创建示例数据

data = {

'website': ['pandasdataframe.com'] * 1000,

'category': ['A', 'B', 'C'] * 333 + ['A'],

'value': range(1000)

}

df = pd.DataFrame(data)

# 将category列转换为categorical类型

df['category'] = df['category'].astype('category')

# 进行分组操作

grouped = df.groupby('category')['value'].mean()

print(grouped)

在这个例子中,我们将category列转换为categorical类型。对于包含有限且重复值的列,这种转换可以显著减少内存使用并提高分组操作的速度。

5.2 使用numba加速自定义聚合函数

对于复杂的自定义聚合函数,我们可以使用numba来加速计算:

import pandas as pd

import numpy as np

from numba import jit

# 创建示例数据

data = {

'website': ['pandasdataframe.com'] * 1000,

'category': ['A', 'B', 'C'] * 333 + ['A'],

'value': np.random.randn(1000)

}

df = pd.DataFrame(data)

# 使用numba加速的自定义聚合函数

@jit(nopython=True)

def custom_agg(x):

return np.sum(np.exp(x)) / len(x)

# 应用加速后的聚合函数

grouped = df.groupby('category')['value'].agg(custom_agg)

print(grouped)

在这个例子中,我们定义了一个使用numba加速的自定义聚合函数。对于计算密集型的操作,这种方法可以显著提高性能。

5.3 使用索引进行快速过滤

对于大型数据集,使用索引进行过滤通常比使用条件过滤更快:

import pandas as pd

import numpy as np

# 创建示例数据

n = 1000000

data = {

'website': ['pandasdataframe.com'] * n,

'date': pd.date_range(start='2023-01-01', periods=n),

'value': np.random.randn(n)

}

df = pd.DataFrame(data)

# 将date列设置为索引

df.set_index('date', inplace=True)

# 使用索引进行快速过滤

filtered = df.loc['2023-06-01':'2023-06-30']

print(filtered.head())

在这个例子中,我们首先将date列设置为索引,然后使用loc索引器进行快速的日期范围过滤。这种方法比使用条件过滤(如df[(df['date'] >= '2023-06-01') & (df['date'] <= '2023-06-30')])要快得多。

6. 常见问题和解决方案

在使用GroupBy和Filter操作时,可能会遇到一些常见问题。以下是一些问题及其解决方案:

6.1 处理缺失值

在进行分组操作时,缺失值可能会导致意外的结果:

import pandas as pd

import numpy as np

# 创建包含缺失值的示例数据

data = {

'website': ['pandasdataframe.com'] * 5,

'category': ['A', 'B', 'A', 'B', np.nan],

'value': [10, 20, 30, 40, 50]

}

df = pd.DataFrame(data)

# 处理缺失值

grouped = df.groupby(df['category'].fillna('Unknown'))['value'].mean()

print(grouped)

Output:

在这个例子中,我们使用fillna()方法将缺失的类别值替换为’Unknown’,然后进行分组操作。这样可以确保所有数据都被包含在分组结果中。

6.2 处理大型数据集的内存问题

当处理非常大的数据集时,可能会遇到内存不足的问题。一种解决方案是使用chunksize参数分块读取和处理数据:

import pandas as pd

# 假设我们有一个大型CSV文件

chunk_size = 100000

result = pd.DataFrame()

for chunk in pd.read_csv('large_file.csv', chunksize=chunk_size):

# 对每个chunk进行处理

chunk['website'] = 'pandasdataframe.com' # 添加website列

chunk_result = chunk.groupby('category')['value'].mean()

result = result.add(chunk_result, fill_value=0)

# 计算最终结果

result = result / (len(result) / chunk_size)

print(result)

这个例子展示了如何分块读取大型CSV文件,对每个块进行处理,然后合并结果。这种方法可以有效减少内存使用。

6.3 处理多级索引

GroupBy操作经常会产生多级索引,这可能会使后续的数据处理变得复杂:

import pandas as pd

# 创建示例数据

data = {

'website': ['pandasdataframe.com'] * 8,

'category': ['A', 'B'] * 4,

'subcategory': ['X', 'Y'] * 4,

'value': range(8)

}

df = pd.DataFrame(data)

# 进行多级分组

grouped = df.groupby(['category', 'subcategory'])['value'].mean()

print(grouped)

# 重置索引,将多级索引转换为列

grouped_reset = grouped.reset_index()

print(grouped_reset)

Output:

在这个例子中,我们首先进行了多级分组,然后使用reset_index()方法将多级索引转换为普通的列。这样可以使后续的数据处理更加方便。

7. 实际应用场景

GroupBy和Filter操作在实际数据分析中有广泛的应用。以下是一些常见的应用场景:

7.1 销售数据分析

假设我们有一个电子商务网站的销售数据:

import pandas as pd

import numpy as np

# 创建示例销售数据

np.random.seed(0)

n = 1000

data = {

'website': ['pandasdataframe.com'] * n,

'date': pd.date_range(start='2023-01-01', periods=n),

'product': np.random.choice(['A', 'B', 'C'], n),

'category': np.random.choice(['Electronics', 'Clothing', 'Books'], n),

'sales': np.random.randint(10, 1000, n)

}

df = pd.DataFrame(data)

# 按产品类别分组,计算总销售额

category_sales = df.groupby('category')['sales'].sum().sort_values(ascending=False)

print("Category Sales:")

print(category_sales)

# 找出销售额top 5的日期

top_5_days = df.groupby('date')['sales'].sum().nlargest(5)

print("\nTop 5 Sales Days:")

print(top_5_days)

# 计算每个产品的日均销售额

daily_product_sales = df.groupby(['date', 'product'])['sales'].mean().unstack()

print("\nDaily Product Sales:")

print(daily_product_sales.head())

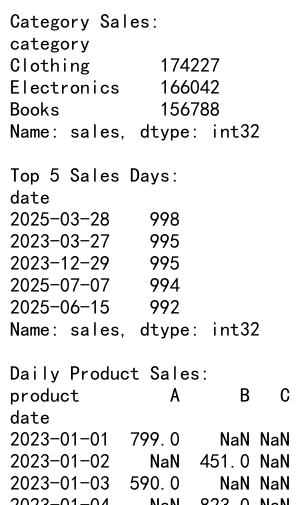

Output:

这个例子展示了如何使用GroupBy操作来分析销售数据,包括计算各类别的总销售额、找出销售最好的日期,以及计算每个产品的日均销售额。

7.2 客户行为分析

假设我们有一个网站的用户行为数据:

import pandas as pd

import numpy as np

# 创建示例用户行为数据

np.random.seed(0)

n = 10000

data = {

'website': ['pandasdataframe.com'] * n,

'user_id': np.random.randint(1, 1001, n),

'date': pd.date_range(start='2023-01-01', periods=n),

'page_views': np.random.randint(1, 20, n),

'session_duration': np.random.randint(10, 3600, n)

}

df = pd.DataFrame(data)

# 计算每个用户的总页面浏览量和平均会话时长

user_metrics = df.groupby('user_id').agg({

'page_views': 'sum',

'session_duration': 'mean'

})

print("User Metrics:")

print(user_metrics.head())

# 找出页面浏览量最多的前10个用户

top_users = user_metrics.nlargest(10, 'page_views')

print("\nTop 10 Users by Page Views:")

print(top_users)

# 计算每日的平均页面浏览量和会话时长

daily_metrics = df.groupby('date').agg({

'page_views': 'mean',

'session_duration': 'mean'

})

print("\nDaily Average Metrics:")

print(daily_metrics.head())

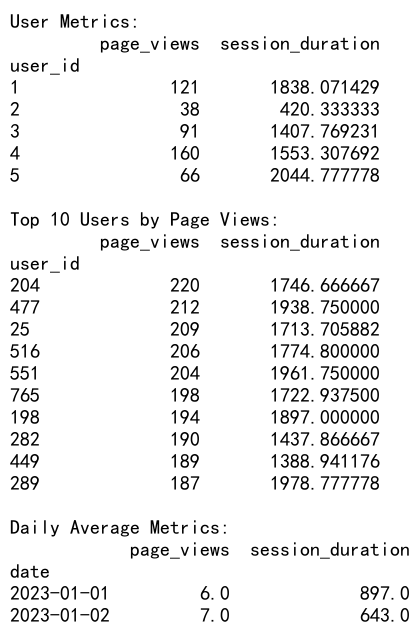

Output:

这个例子展示了如何使用GroupBy和Filter操作来分析用户行为数据,包括计算每个用户的总体指标、找出最活跃的用户,以及计算每日的平均指标。

8. 总结

Pandas的GroupBy和Filter操作是数据分析中非常强大的工具。它们允许我们以灵活和高效的方式对数据进行分组、聚合和筛选。通过本文的详细介绍和实例,我们了解了这些操作的基本用法、高级技巧以及在实际场景中的应用。

关键要点包括:

1. GroupBy操作允许我们按一个或多个列对数据进行分组,并对每个组应用聚合函数。

2. Filter操作可以基于各种条件对数据进行筛选,包括简单的条件过滤和复杂的基于函数的过滤。

3. GroupBy和Filter可以结合使用,提供更强大的数据处理能力。

4. 对于大型数据集,可以使用一些性能优化技巧,如使用categorical数据类型、numba加速和索引过滤。

5. 在实际应用中,这些操作可以用于各种场景,如销售数据分析和用户行为分析。

通过掌握这些技巧,我们可以更有效地处理和分析复杂的数据集,从而获得有价值的洞察。随着数据规模和复杂性的不断增加,熟练运用这些工具将变得越来越重要。

极客笔记

极客笔记