Pandas GroupBy和Count Unique操作:数据分组与唯一值计数的完整指南

参考:pandas groupby count unique

Pandas是Python中最流行的数据处理库之一,它提供了强大的数据操作和分析工具。在处理大型数据集时,我们经常需要对数据进行分组并计算唯一值的数量。本文将深入探讨Pandas中的GroupBy操作和Count Unique功能,帮助您更好地理解和应用这些重要的数据分析技术。

1. Pandas GroupBy简介

GroupBy操作是数据分析中的一个核心概念,它允许我们将数据按照一个或多个列进行分组,然后对每个组应用聚合函数。这种操作对于发现数据中的模式和趋势非常有用。

1.1 基本GroupBy操作

让我们从一个简单的例子开始:

import pandas as pd

# 创建示例数据框

df = pd.DataFrame({

'name': ['Alice', 'Bob', 'Charlie', 'Alice', 'Bob'],

'age': [25, 30, 35, 25, 31],

'city': ['New York', 'London', 'Paris', 'New York', 'London']

})

# 按name列进行分组并计算年龄平均值

grouped = df.groupby('name')['age'].mean()

print(grouped)

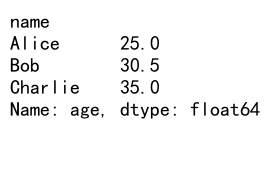

Output:

在这个例子中,我们创建了一个包含姓名、年龄和城市信息的数据框。然后,我们使用groupby('name')按姓名分组,并计算每个人的平均年龄。这个操作会返回一个Series,其中索引是唯一的姓名,值是对应的平均年龄。

1.2 多列分组

Pandas还支持按多个列进行分组:

import pandas as pd

# 创建示例数据框

df = pd.DataFrame({

'category': ['A', 'B', 'A', 'B', 'A'],

'subcategory': ['X', 'X', 'Y', 'Y', 'X'],

'value': [1, 2, 3, 4, 5]

})

# 按category和subcategory列进行分组并计算value的总和

grouped = df.groupby(['category', 'subcategory'])['value'].sum()

print(grouped)

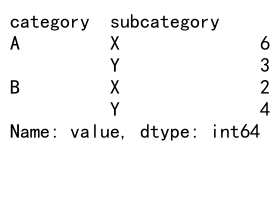

Output:

这个例子展示了如何按多个列(category和subcategory)进行分组,并计算每个组的value总和。结果是一个具有多级索引的Series。

2. Count Unique操作

Count Unique操作用于计算一个列中唯一值的数量。这在数据分析中非常有用,特别是当我们需要了解数据的多样性或重复程度时。

2.1 基本Count Unique操作

以下是一个简单的Count Unique示例:

import pandas as pd

# 创建示例数据框

df = pd.DataFrame({

'fruit': ['apple', 'banana', 'apple', 'cherry', 'banana', 'date'],

'color': ['red', 'yellow', 'green', 'red', 'yellow', 'brown']

})

# 计算fruit列中唯一值的数量

unique_fruits = df['fruit'].nunique()

print(f"Number of unique fruits: {unique_fruits}")

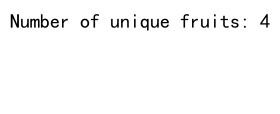

Output:

在这个例子中,我们使用nunique()方法来计算’fruit’列中唯一值的数量。这个方法会返回一个整数,表示不重复的水果种类数量。

2.2 结合GroupBy和Count Unique

GroupBy和Count Unique操作可以结合使用,以获得更深入的数据洞察:

import pandas as pd

# 创建示例数据框

df = pd.DataFrame({

'department': ['Sales', 'IT', 'Sales', 'Marketing', 'IT', 'Sales'],

'employee': ['Alice', 'Bob', 'Charlie', 'David', 'Eve', 'Frank'],

'project': ['A', 'B', 'A', 'C', 'B', 'C']

})

# 按department分组并计算每个部门的唯一项目数量

unique_projects = df.groupby('department')['project'].nunique()

print(unique_projects)

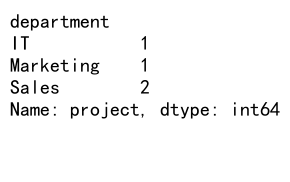

Output:

这个例子展示了如何按部门分组,并计算每个部门参与的唯一项目数量。结果是一个Series,索引是部门名称,值是对应的唯一项目数量。

3. 高级GroupBy技巧

3.1 使用自定义聚合函数

Pandas允许我们使用自定义函数进行聚合操作:

import pandas as pd

# 创建示例数据框

df = pd.DataFrame({

'name': ['Alice', 'Bob', 'Charlie', 'David'],

'score': [85, 92, 78, 95]

})

# 定义自定义函数

def score_category(x):

if x >= 90:

return 'Excellent'

elif x >= 80:

return 'Good'

else:

return 'Average'

# 使用自定义函数进行分组聚合

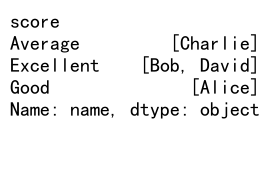

result = df.groupby(df['score'].apply(score_category))['name'].agg(list)

print(result)

Output:

在这个例子中,我们定义了一个score_category函数来将分数分类。然后,我们使用这个函数作为分组的依据,并将每个类别中的名字聚合成一个列表。

3.2 多列聚合

我们可以同时对多个列应用不同的聚合函数:

import pandas as pd

# 创建示例数据框

df = pd.DataFrame({

'category': ['A', 'B', 'A', 'B', 'A'],

'value1': [10, 20, 30, 40, 50],

'value2': [1, 2, 3, 4, 5]

})

# 对多列应用不同的聚合函数

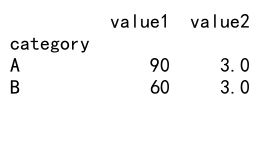

result = df.groupby('category').agg({

'value1': 'sum',

'value2': 'mean'

})

print(result)

Output:

这个例子展示了如何在一个GroupBy操作中对不同的列应用不同的聚合函数。我们对’value1’列求和,对’value2’列求平均值。

4. Count Unique的高级应用

4.1 条件Count Unique

有时我们需要在特定条件下计算唯一值的数量:

import pandas as pd

# 创建示例数据框

df = pd.DataFrame({

'product': ['A', 'B', 'A', 'C', 'B', 'A'],

'category': ['X', 'Y', 'X', 'Z', 'Y', 'Z'],

'sales': [100, 200, 150, 300, 250, 180]

})

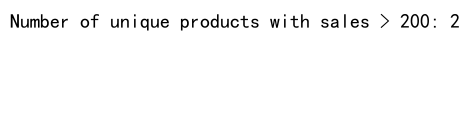

# 计算销售额大于200的唯一产品数量

high_sales_products = df[df['sales'] > 200]['product'].nunique()

print(f"Number of unique products with sales > 200: {high_sales_products}")

Output:

这个例子展示了如何计算满足特定条件(销售额大于200)的唯一产品数量。

4.2 按时间段的唯一值计数

在处理时间序列数据时,我们可能需要按时间段计算唯一值的数量:

import pandas as pd

# 创建示例数据框

df = pd.DataFrame({

'date': pd.date_range(start='2023-01-01', end='2023-12-31', freq='D'),

'user_id': [f'user_{i%100}' for i in range(365)],

'action': ['view', 'click', 'purchase'] * 122

})

# 按月份计算唯一用户数

monthly_unique_users = df.groupby(df['date'].dt.to_period('M'))['user_id'].nunique()

print(monthly_unique_users)

这个例子展示了如何按月份计算唯一用户数。我们首先创建了一个包含全年数据的数据框,然后使用groupby和nunique方法来计算每月的唯一用户数。

5. GroupBy和Count Unique的性能优化

在处理大型数据集时,GroupBy和Count Unique操作可能会变得很慢。以下是一些优化技巧:

5.1 使用categoricals

对于包含重复值的列,将其转换为categorical类型可以显著提高性能:

import pandas as pd

# 创建示例数据框

df = pd.DataFrame({

'category': ['A', 'B', 'C'] * 1000000,

'value': range(3000000)

})

# 将category列转换为categorical类型

df['category'] = df['category'].astype('category')

# 执行GroupBy操作

result = df.groupby('category')['value'].mean()

print(result)

在这个例子中,我们将’category’列转换为categorical类型。这对于包含大量重复值的列特别有效,可以减少内存使用并提高GroupBy操作的速度。

5.2 使用Pandas的query方法

对于大型数据框,使用query方法进行过滤可能比标准的布尔索引更快:

import pandas as pd

# 创建示例数据框

df = pd.DataFrame({

'category': ['A', 'B', 'C'] * 1000000,

'value': range(3000000)

})

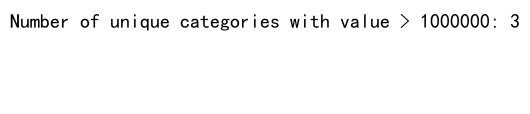

# 使用query方法进行过滤和唯一值计数

unique_count = df.query('value > 1000000')['category'].nunique()

print(f"Number of unique categories with value > 1000000: {unique_count}")

Output:

这个例子展示了如何使用query方法来过滤数据,然后计算唯一值的数量。对于大型数据集,这种方法通常比使用布尔索引更快。

6. 实际应用场景

让我们看一些GroupBy和Count Unique操作在实际数据分析中的应用场景:

6.1 客户购买行为分析

import pandas as pd

# 创建示例购买数据

df = pd.DataFrame({

'customer_id': [f'cust_{i%100}' for i in range(1000)],

'product_id': [f'prod_{i%50}' for i in range(1000)],

'purchase_date': pd.date_range(start='2023-01-01', periods=1000),

'amount': [round(100 * (i % 10 + 1), 2) for i in range(1000)]

})

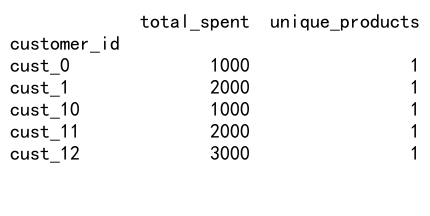

# 计算每个客户的总购买金额和唯一产品数

customer_analysis = df.groupby('customer_id').agg({

'amount': 'sum',

'product_id': 'nunique'

}).rename(columns={'amount': 'total_spent', 'product_id': 'unique_products'})

print(customer_analysis.head())

Output:

这个例子展示了如何分析客户的购买行为。我们计算了每个客户的总消费金额和购买的唯一产品数量。这种分析可以帮助识别高价值客户和多样化购买的客户。

6.2 网站流量分析

import pandas as pd

# 创建示例网站访问数据

df = pd.DataFrame({

'date': pd.date_range(start='2023-01-01', end='2023-12-31', freq='H'),

'user_id': [f'user_{i%1000}' for i in range(8760)],

'page_viewed': ['home', 'product', 'cart', 'checkout'] * 2190

})

# 按日期统计每日独立访客数和浏览页面数

daily_stats = df.groupby(df['date'].dt.date).agg({

'user_id': 'nunique',

'page_viewed': 'count'

}).rename(columns={'user_id': 'unique_visitors', 'page_viewed': 'page_views'})

print(daily_stats.head())

这个例子展示了如何分析网站流量数据。我们计算了每天的独立访客数和总页面浏览量。这种分析可以帮助了解网站的使用情况和流量趋势。

6.3 产品类别分析

import pandas as pd

# 创建示例产品数据

df = pd.DataFrame({

'product_id': [f'prod_{i}' for i in range(1000)],

'category': ['Electronics', 'Clothing', 'Books', 'Home'] * 250,

'subcategory': ['Phones', 'Shirts', 'Fiction', 'Kitchen'] * 250,

'price': [round(100 * (i % 10 + 1), 2) for i in range(1000)],

'stock': [i % 100 for i in range(1000)]

})

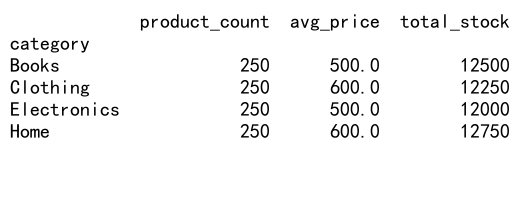

# 分析每个类别的产品数量、平均价格和总库存

category_analysis = df.groupby('category').agg({

'product_id': 'count',

'price': 'mean',

'stock': 'sum'

}).rename(columns={'product_id': 'product_count', 'price': 'avg_price', 'stock': 'total_stock'})

print(category_analysis)

Output:

这个例子展示了如何分析产品类别数据。我们计算了每个类别的产品数量、平均价格和总库存。这种分析可以帮助了解不同产品类别的分布和特征。

7. 处理缺失值

在进行GroupBy和Count Unique操作时,处理缺失值是一个常见的挑战。以下是一些处理缺失值的方法:

7.1 在GroupBy中处理缺失值

import pandas as pd

import numpy as np

# 创建包含缺失值的示例数据框

df = pd.DataFrame({

'category': ['A', 'B', np.nan, 'A', 'B', np.nan],

'value': [1, 2, 3, 4, 5, 6]

})

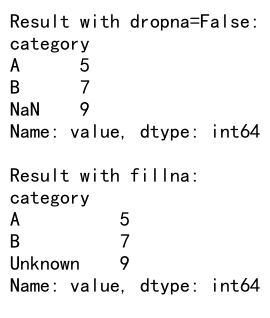

# 使用dropna处理缺失值

result_dropna = df.groupby('category', dropna=False)['value'].sum()

print("Result with dropna=False:")

print(result_dropna)

# 使用fillna处理缺失值

df['category'] = df['category'].fillna('Unknown')

result_fillna = df.groupby('category')['value'].sum()

print("\nResult with fillna:")

print(result_fillna)

Output:

在这个例子中,我们展示了两种处理缺失值的方法。第一种方法使用dropna=False参数,这会将缺失值视为一个单独的组。第二种方法使用fillna将缺失值替换为’Unknown’,然后进行分组。

7.2 在Count Unique中处理缺失值

import pandas as pd

import numpy as np

# 创建包含缺失值的示例数据框

df = pd.DataFrame({

'category': ['A', 'B', 'A', 'B', 'A', 'B'],

'value': [1, 2, np.nan, 4, 5, np.nan]

})

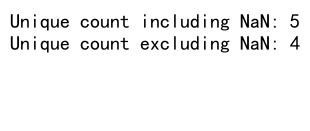

# 计算包括缺失值在内的唯一值数量

unique_count_with_na = df['value'].nunique(dropna=False)

print(f"Unique count including NaN: {unique_count_with_na}")

# 计算不包括缺失值的唯一值数量

unique_count_without_na = df['value'].nunique()

print(f"Unique count excluding NaN: {unique_count_without_na}")

Output:

这个例子展示了如何在计算唯一值数量时处理缺失值。使用nunique(dropna=False)会将NaN视为一个唯一值,而默认的nunique()会忽略NaN。

8. 高级GroupBy技巧

8.1 使用transform方法

transform方法允许我们将聚合结果广播回原始数据框的形状:

import pandas as pd

# 创建示例数据框

df = pd.DataFrame({

'group': ['A', 'B', 'A', 'B', 'A'],

'value': [1, 2, 3, 4, 5]

})

# 使用transform计算每个组的平均值

df['group_mean'] = df.groupby('group')['value'].transform('mean')

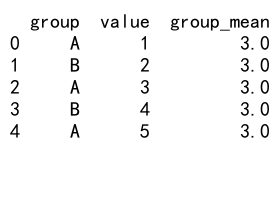

print(df)

Output:

这个例子展示了如何使用transform方法计算每个组的平均值,并将结果添加为新列。这对于计算组内统计量非常有用。

8.2 使用apply方法进行复杂操作

apply方法允许我们对每个组应用自定义函数:

import pandas as pd

# 创建示例数据框

df = pd.DataFrame({

'group': ['A', 'B', 'A', 'B', 'A'],

'value1': [1, 2, 3, 4, 5],

'value2': [10, 20, 30, 40, 50]

})

# 定义自定义函数

def custom_agg(group):

return pd.Series({

'value1_sum': group['value1'].sum(),

'value2_mean': group['value2'].mean(),

'product': group['value1'].sum() * group['value2'].mean()

})

# 使用apply方法应用自定义函数

result = df.groupby('group').apply(custom_agg)

print(result)

这个例子展示了如何使用apply方法对每个组应用复杂的自定义函数。这允许我们执行更灵活的聚合操作。

9. 高效的大数据处理

当处理大型数据集时,效率变得尤为重要。以下是一些处理大数据的技巧:

9.1 使用chunks处理大文件

import pandas as pd

# 假设我们有一个大型CSV文件 'large_file.csv'

chunk_size = 10000

chunks = []

for chunk in pd.read_csv('pandasdataframe.com/large_file.csv', chunksize=chunk_size):

# 对每个chunk进行处理

processed = chunk.groupby('category')['value'].sum()

chunks.append(processed)

# 合并所有处理后的chunks

result = pd.concat(chunks)

result = result.groupby(level=0).sum()

print(result)

这个例子展示了如何使用chunksize参数分块读取大型CSV文件,对每个块进行处理,然后合并结果。这种方法可以有效减少内存使用。

9.2 使用dask进行并行处理

对于非常大的数据集,可以考虑使用dask库进行并行处理:

import dask.dataframe as dd

# 读取大型CSV文件

df = dd.read_csv('pandasdataframe.com/very_large_file.csv')

# 执行GroupBy操作

result = df.groupby('category')['value'].sum().compute()

print(result)

这个例子展示了如何使用dask来处理非常大的数据集。Dask可以自动将操作分解为小块并并行执行,从而提高处理速度。

10. 可视化GroupBy和Count Unique结果

可视化是数据分析的重要组成部分。以下是一些可视化GroupBy和Count Unique结果的方法:

10.1 使用Matplotlib绘制柱状图

import pandas as pd

import matplotlib.pyplot as plt

# 创建示例数据

df = pd.DataFrame({

'category': ['A', 'B', 'C', 'A', 'B', 'C', 'A', 'B', 'C'],

'value': [1, 2, 3, 4, 5, 6, 7, 8, 9]

})

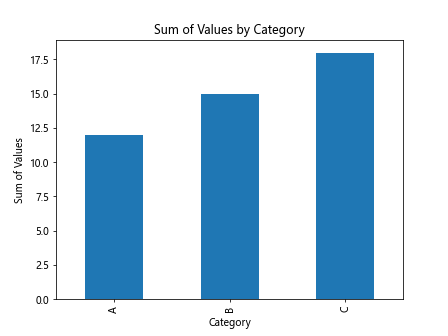

# 执行GroupBy操作

grouped = df.groupby('category')['value'].sum()

# 绘制柱状图

grouped.plot(kind='bar')

plt.title('Sum of Values by Category')

plt.xlabel('Category')

plt.ylabel('Sum of Values')

plt.show()

Output:

这个例子展示了如何使用Matplotlib将GroupBy结果可视化为柱状图。

10.2 使用Seaborn绘制高级图表

import pandas as pd

import seaborn as sns

import matplotlib.pyplot as plt

# 创建示例数据

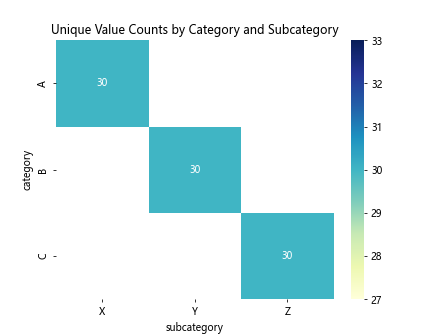

df = pd.DataFrame({

'category': ['A', 'B', 'C'] * 30,

'subcategory': ['X', 'Y', 'Z'] * 30,

'value': [i for i in range(90)]

})

# 计算每个类别和子类别的唯一值数量

unique_counts = df.groupby(['category', 'subcategory'])['value'].nunique().unstack()

# 使用Seaborn绘制热力图

sns.heatmap(unique_counts, annot=True, cmap='YlGnBu')

plt.title('Unique Value Counts by Category and Subcategory')

plt.show()

Output:

这个例子展示了如何使用Seaborn绘制热力图,展示按类别和子类别分组的唯一值数量。

结论

Pandas的GroupBy和Count Unique操作是数据分析中非常强大的工具。它们允许我们深入挖掘数据,发现隐藏的模式和趋势。通过本文介绍的各种技巧和示例,您应该能够更有效地使用这些功能来处理和分析数据。

记住,在处理大型数据集时,性能优化是关键。使用适当的数据类型、利用分块处理和并行计算等技术可以显著提高处理效率。同时,可视化结果对于理解和展示数据分析结果也至关重要。

随着数据量的不断增长和分析需求的日益复杂,掌握这些技能将使您在数据分析领域中脱颖而出。继续探索和实践,您将发现Pandas还有更多强大的功能等待您去发掘!

极客笔记

极客笔记