Pandas中使用groupby、agg和count进行高效数据分析

参考:pandas groupby agg count all

Pandas是Python中最流行的数据处理库之一,它提供了强大的数据操作和分析工具。在处理大型数据集时,我们经常需要对数据进行分组、聚合和计数等操作。本文将详细介绍Pandas中的groupby、agg和count函数,以及如何结合使用这些函数来进行高效的数据分析。

1. Pandas中的groupby操作

groupby是Pandas中非常重要的一个功能,它允许我们按照一个或多个列对数据进行分组,然后对每个分组进行操作。这在数据分析中非常有用,可以帮助我们快速了解数据的结构和特征。

1.1 基本的groupby操作

让我们从一个简单的例子开始:

import pandas as pd

# 创建一个示例DataFrame

df = pd.DataFrame({

'name': ['Alice', 'Bob', 'Charlie', 'Alice', 'Bob'],

'age': [25, 30, 35, 25, 31],

'city': ['New York', 'London', 'Paris', 'New York', 'London'],

'score': [85, 90, 78, 92, 88]

})

# 按name列进行分组,并计算每组的平均分数

grouped = df.groupby('name')['score'].mean()

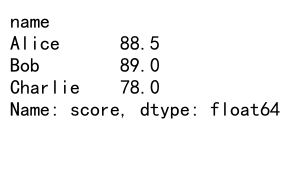

print(grouped)

Output:

在这个例子中,我们首先创建了一个包含姓名、年龄、城市和分数的DataFrame。然后,我们使用groupby(‘name’)按姓名进行分组,并计算每个人的平均分数。这个操作会返回一个Series,其中索引是姓名,值是对应的平均分数。

1.2 多列分组

我们也可以按多个列进行分组:

import pandas as pd

# 创建一个示例DataFrame

df = pd.DataFrame({

'name': ['Alice', 'Bob', 'Charlie', 'Alice', 'Bob'],

'age': [25, 30, 35, 25, 31],

'city': ['New York', 'London', 'Paris', 'New York', 'London'],

'score': [85, 90, 78, 92, 88]

})

# 按name和city列进行分组,并计算每组的平均分数

grouped = df.groupby(['name', 'city'])['score'].mean()

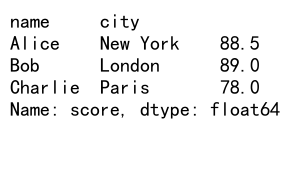

print(grouped)

Output:

在这个例子中,我们按姓名和城市进行分组,然后计算每个组的平均分数。结果是一个多级索引的Series,其中第一级索引是姓名,第二级索引是城市。

1.3 groupby对象的方法

groupby操作返回的是一个GroupBy对象,这个对象有许多有用的方法,如mean()、sum()、count()等。例如:

import pandas as pd

# 创建一个示例DataFrame

df = pd.DataFrame({

'name': ['Alice', 'Bob', 'Charlie', 'Alice', 'Bob'],

'age': [25, 30, 35, 25, 31],

'city': ['New York', 'London', 'Paris', 'New York', 'London'],

'score': [85, 90, 78, 92, 88]

})

# 按name列进行分组,并计算每组的各种统计量

grouped = df.groupby('name').agg({

'age': 'mean',

'score': ['min', 'max', 'mean']

})

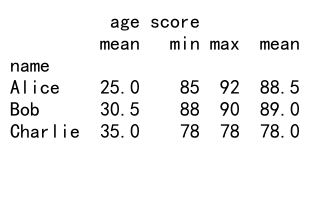

print(grouped)

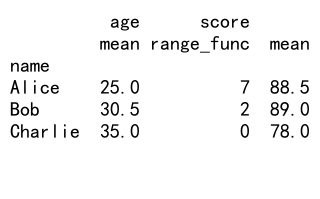

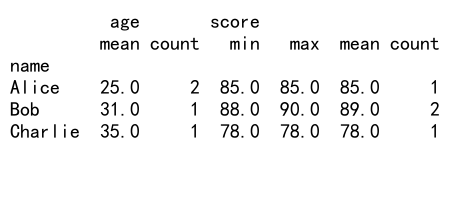

Output:

在这个例子中,我们使用agg方法对不同的列应用不同的聚合函数。对于age列,我们计算平均值;对于score列,我们计算最小值、最大值和平均值。

2. Pandas中的agg函数

agg函数是Pandas中非常强大的聚合工具,它允许我们对分组后的数据应用多种聚合函数。

2.1 基本的agg操作

让我们看一个简单的例子:

import pandas as pd

# 创建一个示例DataFrame

df = pd.DataFrame({

'name': ['Alice', 'Bob', 'Charlie', 'Alice', 'Bob'],

'age': [25, 30, 35, 25, 31],

'city': ['New York', 'London', 'Paris', 'New York', 'London'],

'score': [85, 90, 78, 92, 88]

})

# 使用agg函数计算多个统计量

result = df.groupby('name').agg({

'age': ['mean', 'max'],

'score': ['min', 'max', 'mean']

})

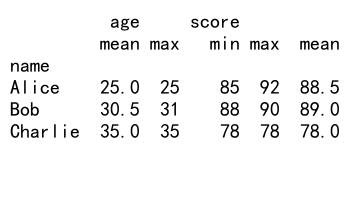

print(result)

Output:

在这个例子中,我们对name列进行分组,然后对age列计算平均值和最大值,对score列计算最小值、最大值和平均值。结果是一个多级列的DataFrame。

2.2 自定义聚合函数

agg函数还允许我们使用自定义的聚合函数:

import pandas as pd

import numpy as np

# 创建一个示例DataFrame

df = pd.DataFrame({

'name': ['Alice', 'Bob', 'Charlie', 'Alice', 'Bob'],

'age': [25, 30, 35, 25, 31],

'city': ['New York', 'London', 'Paris', 'New York', 'London'],

'score': [85, 90, 78, 92, 88]

})

# 定义一个自定义函数

def range_func(x):

return x.max() - x.min()

# 使用自定义函数进行聚合

result = df.groupby('name').agg({

'age': 'mean',

'score': [range_func, 'mean']

})

print(result)

Output:

在这个例子中,我们定义了一个range_func函数来计算最大值和最小值的差。然后,我们在agg函数中使用这个自定义函数来计算score列的范围。

2.3 重命名聚合结果

当使用agg函数时,结果的列名可能会变得复杂。我们可以通过传递一个元组列表来重命名结果列:

import pandas as pd

# 创建一个示例DataFrame

df = pd.DataFrame({

'name': ['Alice', 'Bob', 'Charlie', 'Alice', 'Bob'],

'age': [25, 30, 35, 25, 31],

'city': ['New York', 'London', 'Paris', 'New York', 'London'],

'score': [85, 90, 78, 92, 88]

})

# 使用元组列表重命名聚合结果

result = df.groupby('name').agg([

('平均年龄', 'age', 'mean'),

('最高分', 'score', 'max'),

('最低分', 'score', 'min')

])

print(result)

在这个例子中,我们使用元组列表来指定每个聚合操作的名称、列和函数。这样可以得到一个更易读的结果DataFrame。

3. Pandas中的count函数

count函数用于计算非空值的数量,这在数据分析中非常有用,特别是当我们需要了解数据的完整性时。

3.1 基本的count操作

让我们看一个简单的例子:

import pandas as pd

import numpy as np

# 创建一个包含缺失值的DataFrame

df = pd.DataFrame({

'name': ['Alice', 'Bob', 'Charlie', 'Alice', 'Bob'],

'age': [25, np.nan, 35, 25, 31],

'city': ['New York', 'London', None, 'New York', 'London'],

'score': [85, 90, 78, np.nan, 88]

})

# 计算每列非空值的数量

counts = df.count()

print(counts)

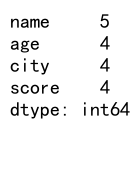

Output:

在这个例子中,我们创建了一个包含一些缺失值(NaN和None)的DataFrame。然后,我们使用count()函数计算每列非空值的数量。结果是一个Series,其中索引是列名,值是对应列的非空值数量。

3.2 结合groupby和count

我们可以结合groupby和count来计算每个分组中非空值的数量:

import pandas as pd

import numpy as np

# 创建一个包含缺失值的DataFrame

df = pd.DataFrame({

'name': ['Alice', 'Bob', 'Charlie', 'Alice', 'Bob'],

'age': [25, np.nan, 35, 25, 31],

'city': ['New York', 'London', None, 'New York', 'London'],

'score': [85, 90, 78, np.nan, 88]

})

# 按name分组,然后计算每组中每列非空值的数量

grouped_counts = df.groupby('name').count()

print(grouped_counts)

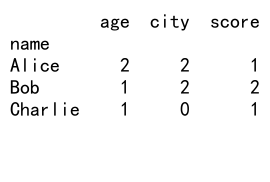

Output:

在这个例子中,我们首先按name列进行分组,然后对每个分组使用count()函数。结果是一个DataFrame,其中行索引是name的唯一值,列是原DataFrame中的其他列,值是每个分组中每列的非空值数量。

3.3 使用count进行数据完整性检查

count函数对于检查数据的完整性非常有用。例如,我们可以计算每列缺失值的比例:

import pandas as pd

import numpy as np

# 创建一个包含缺失值的DataFrame

df = pd.DataFrame({

'name': ['Alice', 'Bob', 'Charlie', 'Alice', 'Bob'],

'age': [25, np.nan, 35, 25, 31],

'city': ['New York', 'London', None, 'New York', 'London'],

'score': [85, 90, 78, np.nan, 88]

})

# 计算每列缺失值的比例

missing_ratio = 1 - df.count() / len(df)

print(missing_ratio)

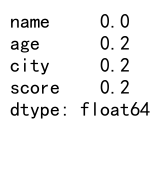

Output:

在这个例子中,我们首先使用count()计算每列非空值的数量,然后用DataFrame的总行数减去这个数量,最后除以总行数,得到每列缺失值的比例。这个信息可以帮助我们了解数据的质量,并决定如何处理缺失值。

4. 结合groupby、agg和count进行复杂分析

现在,让我们看看如何结合使用groupby、agg和count来进行更复杂的数据分析。

4.1 计算每个分组的统计量和非空值数量

import pandas as pd

import numpy as np

# 创建一个示例DataFrame

df = pd.DataFrame({

'name': ['Alice', 'Bob', 'Charlie', 'Alice', 'Bob'],

'age': [25, np.nan, 35, 25, 31],

'city': ['New York', 'London', 'Paris', 'New York', 'London'],

'score': [85, 90, 78, np.nan, 88]

})

# 结合groupby、agg和count进行复杂分析

result = df.groupby('name').agg({

'age': ['mean', 'count'],

'score': ['min', 'max', 'mean', 'count']

})

print(result)

Output:

在这个例子中,我们按name列进行分组,然后对age列计算平均值和非空值数量,对score列计算最小值、最大值、平均值和非空值数量。这样我们可以同时了解每个人的年龄和分数的统计信息,以及数据的完整性。

4.2 计算每个分组中特定条件的数量

我们可以使用自定义函数结合agg来计算满足特定条件的数量:

import pandas as pd

# 创建一个示例DataFrame

df = pd.DataFrame({

'name': ['Alice', 'Bob', 'Charlie', 'Alice', 'Bob'],

'age': [25, 30, 35, 25, 31],

'city': ['New York', 'London', 'Paris', 'New York', 'London'],

'score': [85, 90, 78, 92, 88]

})

# 定义一个函数来计算高分的数量

def high_score_count(x):

return (x > 85).sum()

# 使用自定义函数进行聚合

result = df.groupby('name').agg({

'age': 'mean',

'score': ['mean', high_score_count]

})

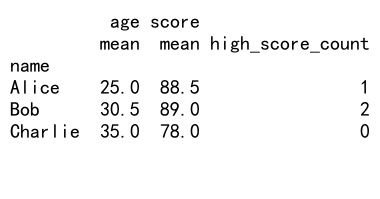

print(result)

Output:

在这个例子中,我们定义了一个high_score_count函数来计算分数高于85的数量。然后,我们在agg函数中使用这个自定义函数,同时计算平均分数。这样我们可以了解每个人的平均分数和高分次数。

4.3 计算每个分组的百分比

我们可以使用groupby和agg来计算每个分组中某个类别的百分比:

import pandas as pd

# 创建一个示例DataFrame

df = pd.DataFrame({

'name': ['Alice', 'Bob', 'Charlie', 'Alice', 'Bob'],

'age': [25, 30, 35, 25, 31],

'city': ['New York', 'London', 'Paris', 'New York', 'London'],

'passed': [True, True, False, True, False]

})

# 计算每个人的通过率

result = df.groupby('name').agg({

'passed': [('通过率', lambda x: x.mean() * 100),

('总次数', 'count')]

})

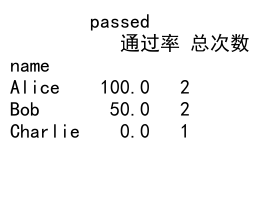

print(result)

Output:

在这个例子中,我们按name分组,然后计算每个人的通过率(通过次数除以总次数)和总考试次数。我们使用一个lambda函数来计算百分比,并使用元组来重命名结果列。

4.4 计算累计统计统计量

我们可以使用groupby和agg结合Pandas的累计函数来计算累计统计量:

import pandas as pd

# 创建一个示例DataFrame

df = pd.DataFrame({

'date': pd.date_range(start='2023-01-01', periods=10),

'sales': [100, 150, 200, 120, 180, 220, 190, 210, 230, 250],

'product': ['A', 'B', 'A', 'B', 'A', 'B', 'A', 'B', 'A', 'B']

})

# 计算每个产品的累计销售额

result = df.groupby('product').agg({

'sales': [('累计销售额', lambda x: x.cumsum().iloc[-1]),

('平均销售额', 'mean')]

})

print(result)

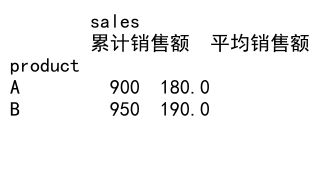

Output:

在这个例子中,我们按product分组,然后计算每个产品的累计销售额和平均销售额。我们使用lambda函数和cumsum()方法来计算累计销售额,并取最后一个值作为总累计销售额。

5. 高级技巧和注意事项

在使用Pandas的groupby、agg和count函数时,还有一些高级技巧和注意事项需要了解。

5.1 处理大数据集

当处理大型数据集时,内存使用可能会成为一个问题。在这种情况下,我们可以使用迭代器来逐块处理数据:

import pandas as pd

# 假设我们有一个大型CSV文件

chunksize = 10000

result = pd.DataFrame()

for chunk in pd.read_csv('pandasdataframe.com_large_file.csv', chunksize=chunksize):

# 对每个chunk进行处理

chunk_result = chunk.groupby('category').agg({

'value': ['sum', 'mean']

})

result = result.add(chunk_result, fill_value=0)

# 计算最终的平均值

result['value', 'mean'] = result['value', 'sum'] / result['value', 'count']

print(result)

在这个例子中,我们使用pd.read_csv的chunksize参数来逐块读取大型CSV文件。对于每个chunk,我们进行分组和聚合操作,然后将结果累加到最终结果中。这种方法可以有效减少内存使用。

5.2 处理时间序列数据

Pandas对时间序列数据有很好的支持。我们可以使用resample方法来对时间序列数据进行重采样和聚合:

import pandas as pd

import numpy as np

# 创建一个时间序列DataFrame

dates = pd.date_range('2023-01-01', periods=100, freq='D')

df = pd.DataFrame({

'date': dates,

'value': np.random.randn(100)

})

df.set_index('date', inplace=True)

# 按周重采样并计算平均值

weekly_mean = df.resample('W').mean()

print(weekly_mean)

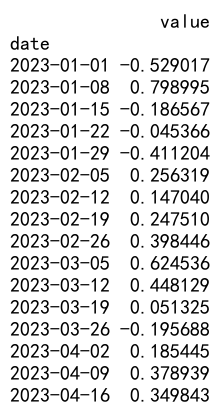

Output:

在这个例子中,我们创建了一个包含100天数据的时间序列DataFrame。然后,我们使用resample(‘W’)按周重采样,并计算每周的平均值。

5.3 使用transform方法

transform方法允许我们将聚合结果广播回原始DataFrame的形状,这在某些情况下非常有用:

import pandas as pd

# 创建一个示例DataFrame

df = pd.DataFrame({

'name': ['Alice', 'Bob', 'Charlie', 'Alice', 'Bob'],

'age': [25, 30, 35, 25, 31],

'score': [85, 90, 78, 92, 88]

})

# 计算每个人的平均分数,并添加到原DataFrame中

df['avg_score'] = df.groupby('name')['score'].transform('mean')

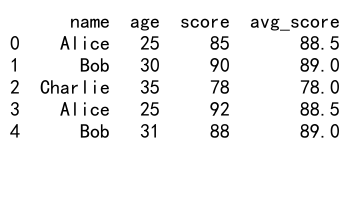

print(df)

Output:

在这个例子中,我们使用transform方法计算每个人的平均分数,并将结果添加为新的列。transform方法会将结果广播回原始DataFrame的形状,所以每个人都会得到他们的平均分数。

5.4 处理多级索引

当使用多个列进行分组时,结果通常会是一个具有多级索引的DataFrame。我们可以使用unstack方法来重塑这种结果:

import pandas as pd

# 创建一个示例DataFrame

df = pd.DataFrame({

'name': ['Alice', 'Bob', 'Charlie', 'Alice', 'Bob'],

'year': [2021, 2021, 2021, 2022, 2022],

'score': [85, 90, 78, 92, 88]

})

# 按name和year分组,计算平均分数

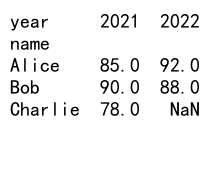

result = df.groupby(['name', 'year'])['score'].mean().unstack()

print(result)

Output:

在这个例子中,我们按name和year进行分组,计算平均分数。然后,我们使用unstack()方法将year从索引转换为列,得到一个更易读的表格形式。

6. 性能优化

在处理大型数据集时,性能可能会成为一个问题。以下是一些优化Pandas操作性能的技巧:

6.1 使用分类数据类型

对于具有有限且重复值的列,使用分类数据类型可以显著减少内存使用并提高性能:

import pandas as pd

# 创建一个示例DataFrame

df = pd.DataFrame({

'name': ['Alice', 'Bob', 'Charlie', 'Alice', 'Bob'] * 1000,

'city': ['New York', 'London', 'Paris', 'New York', 'London'] * 1000,

'score': range(5000)

})

# 将name和city列转换为分类类型

df['name'] = df['name'].astype('category')

df['city'] = df['city'].astype('category')

# 进行分组操作

result = df.groupby(['name', 'city'])['score'].mean()

print(result)

在这个例子中,我们将name和city列转换为分类类型。这对于包含大量重复值的列特别有效,可以显著减少内存使用并提高groupby操作的速度。

6.2 使用numba加速自定义聚合函数

对于复杂的自定义聚合函数,我们可以使用numba库来加速计算:

import pandas as pd

import numpy as np

from numba import jit

# 创建一个示例DataFrame

df = pd.DataFrame({

'group': ['A', 'B', 'A', 'B', 'A'] * 1000,

'value': np.random.randn(5000)

})

@jit(nopython=True)

def custom_agg(values):

return np.sum(np.exp(values))

# 使用numba加速的自定义聚合函数

result = df.groupby('group')['value'].agg(custom_agg)

print(result)

在这个例子中,我们定义了一个自定义的聚合函数custom_agg,并使用numba的@jit装饰器来编译这个函数。这可以显著提高复杂计算的速度,特别是对于大型数据集。

6.3 使用Dask进行并行计算

对于非常大的数据集,我们可以使用Dask库来进行并行计算:

import dask.dataframe as dd

# 假设我们有一个大型CSV文件

ddf = dd.read_csv('pandasdataframe.com_very_large_file.csv')

# 进行分组和聚合操作

result = ddf.groupby('category').agg({

'value': ['sum', 'mean']

}).compute()

print(result)

在这个例子中,我们使用Dask来读取一个非常大的CSV文件,然后进行分组和聚合操作。Dask会自动将计算分散到多个核心上,从而提高处理大型数据集的效率。

7. 结论

Pandas的groupby、agg和count函数是进行数据分析的强大工具。通过结合使用这些函数,我们可以高效地处理和分析各种类型的数据。从基本的分组操作到复杂的聚合分析,从处理小型数据集到优化大型数据集的性能,这些函数为我们提供了灵活而强大的数据处理能力。

在实际应用中,选择合适的分组策略、聚合函数和性能优化方法对于高效数据分析至关重要。通过深入理解这些函数的工作原理和使用技巧,我们可以更好地挖掘数据中的价值,为决策提供有力支持。

随着数据规模的不断增长和分析需求的日益复杂,掌握这些高级数据处理技能将变得越来越重要。持续学习和实践,不断探索Pandas及其相关生态系统的新特性和最佳实践,将有助于我们在数据分析领域保持竞争力。

极客笔记

极客笔记