如何在 pandas 中实现并行处理

在数据分析和数据处理中,pandas 是 Python 中最常用的库之一。pandas 提供了非常强大的数据结构和数据操作工具,使得处理大规模数据变得更加高效和方便。然而,当处理非常大的数据集时,pandas 的性能可能会成为一个瓶颈。为了解决这个问题,我们可以利用并行处理来加速 pandas 的 apply 函数。本文将详细介绍如何在 pandas 中实现并行处理,特别是如何并行化 apply 函数以提高数据处理速度。

1. pandas apply 函数简介

在 pandas 中,apply 函数是一个非常强大的工具,它允许用户对 DataFrame 或 Series 中的数据应用一个函数。这个函数可以是用户自定义的,也可以是任何可调用的对象。apply 函数通常用于复杂的数据转换或计算,但其缺点是只能在单个核心上运行,这在处理大型数据集时可能会导致性能问题。

示例代码 1:使用 apply 函数

import pandas as pd

# 创建一个简单的 DataFrame

df = pd.DataFrame({

'A': range(1, 6),

'B': ['pandasdataframe.com' for _ in range(5)]

})

# 定义一个简单的函数

def my_func(x):

return x * 2

# 使用 apply 函数

df['A'] = df['A'].apply(my_func)

print(df)

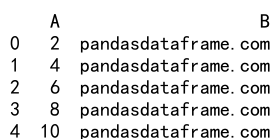

Output:

2. 并行化 apply 函数

为了提高 apply 函数的执行速度,我们可以使用多核处理的方法来并行化这个过程。Python 中有多种方式可以实现并行处理,常见的有使用 multiprocessing 库或第三方库如 joblib。

示例代码 2:使用 multiprocessing 并行化 apply

import pandas as pd

import multiprocessing as mp

# 创建一个 DataFrame

df = pd.DataFrame({

'A': range(1, 1001),

'B': ['pandasdataframe.com' for _ in range(1000)]

})

# 定义一个函数

def my_func(x):

return x * 2

# 并行化 apply 函数

def parallel_apply(df, func, num_partitions, num_cores):

df_split = np.array_split(df, num_partitions)

pool = mp.Pool(num_cores)

df = pd.concat(pool.map(func, df_split))

pool.close()

pool.join()

return df

# 使用并行化 apply

df['A'] = parallel_apply(df['A'], my_func, 10, mp.cpu_count())

print(df)

3. 使用 joblib 加速 apply

joblib 是一个用于轻松简单并行计算的库,它特别适合用于那些要求大量重复计算的任务。使用 joblib 可以很容易地将 apply 函数并行化。

示例代码 3:使用 joblib 并行化 apply

import pandas as pd

from joblib import Parallel, delayed

# 创建一个 DataFrame

df = pd.DataFrame({

'A': range(1, 1001),

'B': ['pandasdataframe.com' for _ in range(1000)]

})

# 定义一个函数

def my_func(x):

return x * 2

# 使用 joblib 并行化 apply

df['A'] = Parallel(n_jobs=-1)(delayed(my_func)(i) for i in df['A'])

print(df)

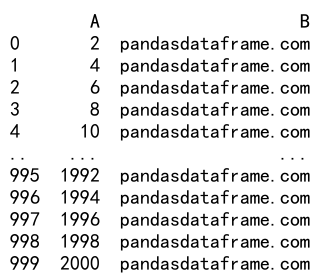

Output:

4. 性能比较

在实际应用中,使用并行处理可以显著提高 apply 函数的执行速度。这一节将通过一个实验来比较单线程和多线程处理 apply 函数的性能差异。

示例代码 4:性能比较

import pandas as pd

import time

# 创建一个大型 DataFrame

df = pd.DataFrame({

'A': range(1, 10001),

'B': ['pandasdataframe.com' for _ in range(10000)]

})

# 定义一个函数

def my_func(x):

return x * 2

# 测试单线程 apply

start_time = time.time()

df['A'] = df['A'].apply(my_func)

end_time = time.time()

print("单线程耗时:", end_time - start_time)

# 测试多线程 apply

start_time = time.time()

df['A'] = parallel_apply(df['A'], my_func, 10, mp.cpu_count())

end_time = time.time()

print("多线程耗时:", end_time - start_time)

5. 结论

通过并行处理,我们可以显著提高 pandas apply 函数的执行速度,特别是在处理大型数据集时。本文介绍了使用 multiprocessing 和 joblib 两种方法来实现 apply 函数的并行化。在选择并行化方法时,应根据具体的应用场景和数据特性来决定使用哪种方法。

极客笔记

极客笔记